Docker网络模式详解:bridge/host/none/container四种模式性能对比与场景选择

凌晨两点。我盯着终端里那行绿色的”Container started”,服务明明起来了,curl却一直timeout。docker logs翻了三遍,没报错。-p 8080:80端口映射也配了。路由没问题,防火墙关了。

问题到底在哪?

后来才发现,是网络模式用错了。我以为只要docker run -p就完事,压根不知道Docker还有bridge、host、none、container四种网络模式在背后偷偷运作。更尴尬的是,用了两年Docker,连docker0网桥是啥都说不清楚。

如果你也遇到过”容器起来了但就是访问不了”的情况,或者对Docker网络配置一知半解,这篇文章就是写给你的。我会用最直白的语言,把这四种网络模式的区别、原理和使用场景讲清楚。不讲复杂的Linux网络命名空间理论,只聊实战中真正需要知道的东西。

先搞清楚Docker网络的”地基”——docker0网桥

docker0是什么?你的容器”物业网关”

装完Docker,系统里会自动冒出一个叫docker0的虚拟网卡。你可以理解成小区的物业网关——所有容器(住户)想上网,都得通过它中转。

打开终端试试这个命令:

ip addr show docker0会看到类似这样的输出:

docker0: <BROADCAST,MULTICAST,UP,LOWER_UP> mtu 1500

inet 172.17.0.1/16 brd 172.17.255.255 scope global docker0看到那个172.17.0.1了吗?这是docker0的IP地址。Docker会给每个新建的容器分配172.17.0.0/16网段里的一个IP,比如172.17.0.2、172.17.0.3这样。

再看看Docker的网络列表:

docker network lsNETWORK ID NAME DRIVER SCOPE

7f8a2b3c9d4e bridge bridge local这个默认的bridge网络,底层用的就是docker0网桥。

veth pair:容器联网的”对讲机”

光有docker0还不够。容器在自己的”独立房间”里(专业术语叫网络命名空间),怎么和docker0通信?

答案是veth pair。这玩意就像一对对讲机:一端在容器内叫eth0,另一端在宿主机上叫vethXXX(比如veth9a7b4c),两端对着说话。

启动一个容器试试:

docker run -d --name test-nginx nginx在宿主机上看网卡:

ip addr | grep veth会看到多出来一个veth开头的设备。再进容器里看:

docker exec test-nginx ip addr容器内有个eth0接口,IP是172.17.0.2。这个eth0和宿主机上的vethXXX是一对,数据包从eth0发出来,瞬间就到vethXXX,然后经过docker0,再通过宿主机的网卡(比如eth0或ens33)出去访问外网。

整个链路是这样的:

容器内部(172.17.0.2)

↓ eth0

↓ (veth pair)

↓ vethXXX

↓

docker0网桥(172.17.0.1)

↓ NAT转发

↓

宿主机网卡(比如192.168.1.100)

↓

外网看起来有点绕,但实际运作很快。你ping一下容器IP,延迟基本就是零点几毫秒。

说实话,我第一次看到veth pair这个概念也懵了好一阵。后来想明白了:就是个虚拟网线,一头插容器,一头插docker0,仅此而已。

Bridge模式——Docker的”默认选项”

为什么默认用bridge?

不指定网络模式的话,Docker会自动用bridge模式。原因很简单:隔离性和易用性的平衡点。

bridge模式让每个容器有独立的IP,不会端口冲突,同时又能通过-p参数轻松把服务暴露到宿主机。对大多数场景来说,这就够了。

举个例子,起两个Nginx容器:

docker run -d -p 8080:80 --name web1 nginx

docker run -d -p 8081:80 --name web2 nginx两个容器都监听80端口,但因为各自在独立的网络空间里,不会冲突。宿主机上通过8080和8081访问,背后是Docker做了NAT端口转发。

用docker inspect web1看看网络配置:

"Networks": {

"bridge": {

"IPAddress": "172.17.0.2",

"Gateway": "172.17.0.1"

}

}看到了吧,容器拿到172.17.0.2这个私有IP,网关就是docker0的172.17.0.1。

默认bridge vs 自定义bridge:一个关键区别

这里有个坑。默认的bridge网络(也就是docker0),容器之间只能通过IP通信,不支持容器名解析。

试试这个:

docker run -d --name db mysql

docker run -it --name app alpine ping db会发现ping不通。必须用ping 172.17.0.2这样指定IP才行。

但如果你创建一个自定义bridge网络:

docker network create mynet

docker run -d --name db --network mynet mysql

docker run -it --name app --network mynet alpine ping db这回就通了。自定义bridge网络自带DNS解析功能,容器名直接当域名用。

这也是为什么生产环境推荐用自定义网络而非默认docker0——服务发现方便多了,不用写死IP。

-p参数背后的秘密:NAT转发

当你用-p 8080:80时,Docker实际上在宿主机的iptables里加了一条NAT规则:

iptables -t nat -L -n | grep 8080会看到类似这样的输出:

DNAT tcp -- 0.0.0.0/0 0.0.0.0/0 tcp dpt:8080 to:172.17.0.2:80意思是:所有发往宿主机8080端口的流量,都转发到容器的172.17.0.2:80。

这就是为什么外部访问http://宿主机IP:8080能访问到容器里的服务——Docker帮你做了一层地址转换。

Bridge模式的适用场景

说到底,bridge模式适合这些场景:

- 微服务架构:多个容器协作,需要隔离又要互相通信(用自定义bridge网络)

- 开发环境:快速起服务测试,默认bridge就够用

- 需要端口映射的Web应用:比如跑个博客、API服务

性能方面,bridge模式有一定的NAT和veth pair开销,但老实讲,对大多数应用来说这点损耗可以忽略。真正遇到性能瓶颈的场景不多,别一上来就担心这个。

Host模式——“性能至上”的选择

什么是Host模式?直接”裸奔”

Host模式最简单粗暴:容器不要独立网络了,直接用宿主机的网络栈。

启动容器时加个--net=host:

docker run -d --net=host --name web nginx这时候容器里没有独立的IP,没有eth0网卡,直接共享宿主机的网络接口。你在容器里看到的网卡配置,和宿主机上ip addr的输出一模一样。

更关键的是:不需要-p做端口映射了。容器里的服务监听80端口,外部直接访问宿主机IP:80就能访问到。

性能优势在哪?

Host模式跳过了docker0网桥和veth pair,也不需要NAT转发。数据包直接从宿主机网卡进出,相当于在宿主机上直接跑进程。

有人测过,高并发场景下host模式比bridge模式快5-10%左右。听起来不多,但对某些对延迟极度敏感的应用(比如高频交易、实时游戏服务器),这点差距就有意义了。

我之前遇到过一个案例:用Nginx做反向代理,每秒处理几万个请求。换成host模式后,P99延迟从12ms降到了9ms。虽然只省了3毫秒,但对那个项目来说,这3毫秒值好几万块。

Host模式的坑和代价

性能是好了,但坑也不少:

坑1:端口冲突

因为直接用宿主机的端口,启动多个容器监听同一个端口会直接报错:

docker run -d --net=host nginx # 监听80

docker run -d --net=host nginx # 又监听80,报错:Address already in use这和在宿主机上直接起两个Nginx没区别。想跑多个实例?要么改容器内的监听端口,要么别用host模式。

坑2:容器内服务必须监听0.0.0.0

如果容器里的服务只监听127.0.0.1,外部访问不了。必须监听0.0.0.0才能被外网访问到。

有次我把一个Node.js服务用host模式跑起来,代码里写的app.listen(3000, 'localhost'),结果外部死活连不上。改成app.listen(3000, '0.0.0.0')才搞定。

坑3:失去了网络隔离

容器能直接访问宿主机的所有网络资源,安全风险高。如果容器里跑的是不可信的第三方代码,用host模式就是给自己挖坑。

Host模式什么时候用?

说实话,只在真正遇到性能瓶颈时才考虑host模式。大多数场景下,bridge模式的那点开销根本不是问题。

Host模式适合这些场景:

- 监控工具:Prometheus、Grafana、ELK这些,需要直接访问宿主机网络资源

- 高性能代理:Nginx、HAProxy做负载均衡,追求极致延迟

- 数据库:MySQL、Redis这种对网络性能敏感的服务(但要注意安全性)

如果你的应用每秒请求量在几千以内,别折腾host模式了,bridge够用。

None和Container模式——“特殊场景专用”

None模式:彻底断网的沙箱

None模式就是字面意思:容器完全没网络。

docker run -it --net=none alpine sh进容器里执行ip addr,只能看到一个loopback接口(lo),连不了外网,别的容器也访问不了它。

什么时候用None模式?

坦白讲,我实际工作中几乎没用过none模式。它的应用场景非常窄:

- 安全测试:跑一些不信任的代码,完全隔离网络避免外泄数据

- 离线数据处理:容器只做本地计算,不需要任何网络通信

- 手动配置网络:极少数情况下,需要完全自定义网络配置(比如用pipework这类工具手动配置veth)

如果你不是搞安全研究或者有特殊的网络配置需求,基本用不上none模式。

Container模式:两个容器”共享网络”

Container模式让一个容器使用另一个容器的网络命名空间。听起来绕,看例子就明白了:

# 先启动一个容器

docker run -d --name web nginx

# 第二个容器共享web的网络

docker run -it --net=container:web alpine sh现在两个容器共享同一套网络配置:IP地址一样、端口空间一样、网卡配置一样。在第二个容器里用localhost:80就能访问到nginx。

Container模式的典型应用:Kubernetes的Pod

Kubernetes的Pod其实就是用container模式实现的。一个Pod里有多个容器,它们共享一个”pause”容器的网络。

比如一个Pod里跑着应用容器和日志收集的sidecar容器,两者可以通过localhost通信,不需要暴露端口到外部。

但如果你只是单纯用Docker而不是Kubernetes,container模式用得也不多。因为直接用bridge模式+自定义网络也能实现容器间通信,而且更灵活。

这两种模式的定位

说到底,none和container更像是”底层能力”而非日常方案。它们为特殊场景提供了灵活性,但80%的情况下你不需要它们。

记住:

- None模式:需要完全隔离网络时用(极少见)

- Container模式:在Kubernetes等编排工具中常见,单独用Docker时很少用

实战决策:如何选择合适的网络模式

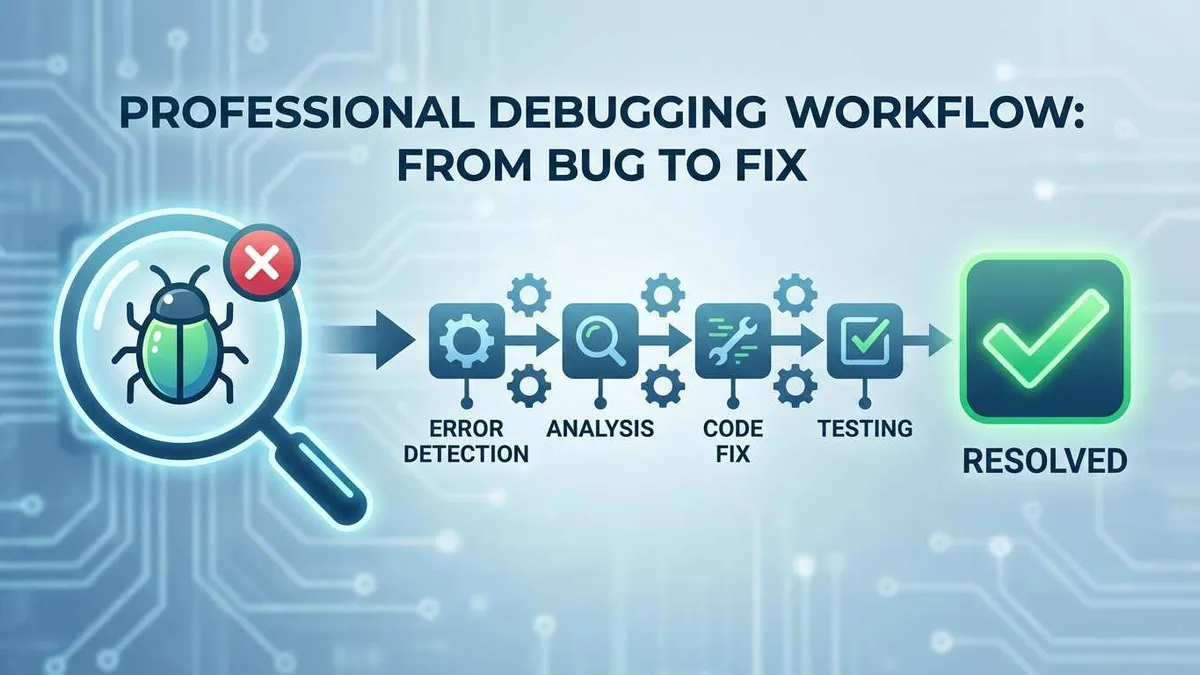

一张决策流程图

面对具体项目,到底该用哪种网络模式?我总结了一个简单的决策流程:

是否需要网络隔离?

│

├─ No → 有性能瓶颈吗?

│ │

│ ├─ Yes → 用Host模式(注意安全风险)

│ └─ No → 用Bridge模式(更安全)

│

└─ Yes → 需要容器间通过名称通信吗?

│

├─ Yes → 自定义Bridge网络

└─ No → 默认Bridge网络特殊场景:

- 完全不需要网络 → None模式

- Kubernetes Pod内容器 → Container模式

场景推荐速查表

| 场景 | 推荐模式 | 理由 |

|---|---|---|

| 微服务架构(多容器协作) | 自定义bridge | 支持容器名解析,隔离性好 |

| 单个Web应用 | 默认bridge | 简单够用,一条命令搞定 |

| 高性能数据库/缓存 | Host | 减少网络开销,但需评估安全风险 |

| 监控工具(Prometheus/ELK) | Host | 需要直接访问宿主机资源 |

| 负载均衡器(Nginx/HAProxy) | Host | 追求极致延迟 |

| 开发测试环境 | 默认bridge | 快速启动,无需复杂配置 |

| K8s Pod内的sidecar容器 | Container | 与主容器共享网络 |

| 安全沙箱/离线任务 | None | 彻底隔离网络 |

三个常见误区

误区1:“Host模式总是最好的”

错。Host模式牺牲了隔离性和灵活性,换来的性能提升在很多场景下可以忽略。

我见过有人把所有容器都用host模式跑,结果端口冲突、安全问题一堆。测下来性能确实快了点,但维护成本高了10倍。

真相:80%的应用用bridge模式就够了,别被”性能更好”忽悠。

误区2:“默认bridge够用了”

生产环境不推荐。默认bridge不支持容器名解析,多个服务通信时要写死IP或者用环境变量传IP,很脆弱。

自定义bridge网络创建很简单:

docker network create mynet

docker-compose.yml里指定network即可真相:多花2分钟配置自定义网络,省几个小时的排错时间。

误区3:“容器网络问题都是模式选错”

不一定。很多时候是防火墙、iptables配置、DNS问题。

排查步骤:

- 先在容器内ping网关(docker0的IP)能否通

- 再ping宿主机的外网IP能否通

- 检查iptables规则是否有DROP

- 检查Docker daemon的配置(/etc/docker/daemon.json)

真相:模式只是第一步,网络问题排查要系统化。

进阶技巧

技巧1:一个容器加入多个网络

有时候容器需要同时连到两个网络(比如前端网络和后端网络),可以这样:

docker network create frontend

docker network create backend

docker run -d --name web --network frontend nginx

docker network connect backend web现在web容器同时在frontend和backend两个网络里。

技巧2:精确控制IP分配

自定义网络时可以指定子网和网关:

docker network create \

--driver bridge \

--subnet 192.168.10.0/24 \

--gateway 192.168.10.1 \

mynet

docker run -d --network mynet --ip 192.168.10.100 nginx这在需要固定IP的场景下很有用(比如防火墙白名单)。

技巧3:排查网络问题的利器

进容器排查网络问题,这几个工具好用:

# 安装网络工具

docker exec -it <container> apk add curl netcat-openbsd

# 测试连通性

docker exec <container> nc -zv <host> <port>

# 查看路由表

docker exec <container> ip route

# 抓包分析(需要宿主机权限)

docker exec <container> tcpdump -i eth0结论

说了这么多,快速回顾一下四种网络模式:

- Bridge模式:默认选项,适合大多数场景,生产环境推荐用自定义bridge网络

- Host模式:性能优先,但牺牲隔离性,只在真正有瓶颈时用

- None模式:完全断网,极少使用

- Container模式:共享网络,主要在Kubernetes里用

记住一点:没有最好的模式,只有最合适的。

如果你刚接触Docker,从默认bridge开始就行。遇到具体问题再调整:服务发现麻烦就换自定义bridge,性能真不够了再考虑host,不要一开始就纠结哪个模式”最优”。

建议动手试试:创建一个自定义网络,启动几个容器,测测它们能不能通过容器名互相访问。真正跑一遍,比看10篇文章都管用。

如果你在实际项目中遇到了Docker网络问题,欢迎留言讨论。这块水挺深,但掌握了这些基础概念,80%的问题都能自己搞定。

Docker网络模式选择完整指南

深度解析bridge/host/none/container四种网络模式的原理、性能对比和适用场景

⏱️ 预计耗时: 30 分钟

- 1

步骤1: 理解四种网络模式

四种网络模式:

bridge(默认模式)

• 通过docker0网桥通信,需要端口映射

• 适合大多数场景,性能略低于host模式,但安全性更高

host模式

• 直接使用宿主机网络,无需端口映射

• 性能最好(接近原生),但安全性低(容器直接暴露在宿主机网络)

• 适合高性能场景

none模式

• 无网络,完全隔离

container模式

• 共享其他容器的网络命名空间 - 2

步骤2: 性能对比和场景选择

性能对比:

• host模式性能最好(接近原生)

• bridge模式性能略低(有NAT开销)

• container模式性能取决于共享的容器

• none模式无网络

场景选择:

• 大多数场景用bridge模式(默认,安全,需要端口映射)

• 高性能需求用host模式(性能最好,但安全性低)

• 完全隔离用none模式(无网络,完全隔离)

• 容器间共享网络用container模式(共享其他容器的网络命名空间) - 3

步骤3: 实战配置和最佳实践

bridge模式配置:

• docker run -d -p 8080:80 nginx(默认bridge模式,端口映射)

• 创建自定义网络:docker network create my-network

• 使用自定义网络:docker run --network my-network

host模式配置:

• docker run --network host nginx(直接使用宿主机网络)

最佳实践:

• 如果你刚接触Docker,从默认bridge开始就行

• 遇到具体问题再调整

• 服务发现麻烦就换自定义bridge

• 性能真不够了再考虑host

• 不要一开始就纠结哪个模式"最优"

常见问题

Docker有哪四种网络模式?各有什么特点?

bridge(默认模式):

• 通过docker0网桥通信,需要端口映射

• 适合大多数场景,性能略低于host模式,但安全性更高

host模式:

• 直接使用宿主机网络,无需端口映射

• 性能最好(接近原生),但安全性低(容器直接暴露在宿主机网络)

• 适合高性能场景

none模式:

• 无网络,完全隔离

container模式:

• 共享其他容器的网络命名空间

bridge模式和host模式有什么区别?

• 默认模式,容器通过docker0网桥通信

• 需要-p参数进行端口映射

• 适合大多数场景,性能略低于host模式,但安全性更高

host模式:

• 直接使用宿主机网络,无需端口映射

• 性能最好(接近原生)

• 但安全性低(容器直接暴露在宿主机网络)

• 适合高性能场景

性能对比:host模式性能最好(接近原生),bridge模式性能略低(有NAT开销)。

如何选择适合的网络模式?

• 大多数场景用bridge模式(默认,安全,需要端口映射)

• 高性能需求用host模式(性能最好,但安全性低)

• 完全隔离用none模式(无网络,完全隔离)

• 容器间共享网络用container模式(共享其他容器的网络命名空间)

最佳实践:

• 如果你刚接触Docker,从默认bridge开始就行

• 遇到具体问题再调整

• 服务发现麻烦就换自定义bridge

• 性能真不够了再考虑host

• 不要一开始就纠结哪个模式"最优"

13 分钟阅读 · 发布于: 2025年12月17日 · 修改于: 2026年2月5日

评论

使用 GitHub 账号登录后即可评论