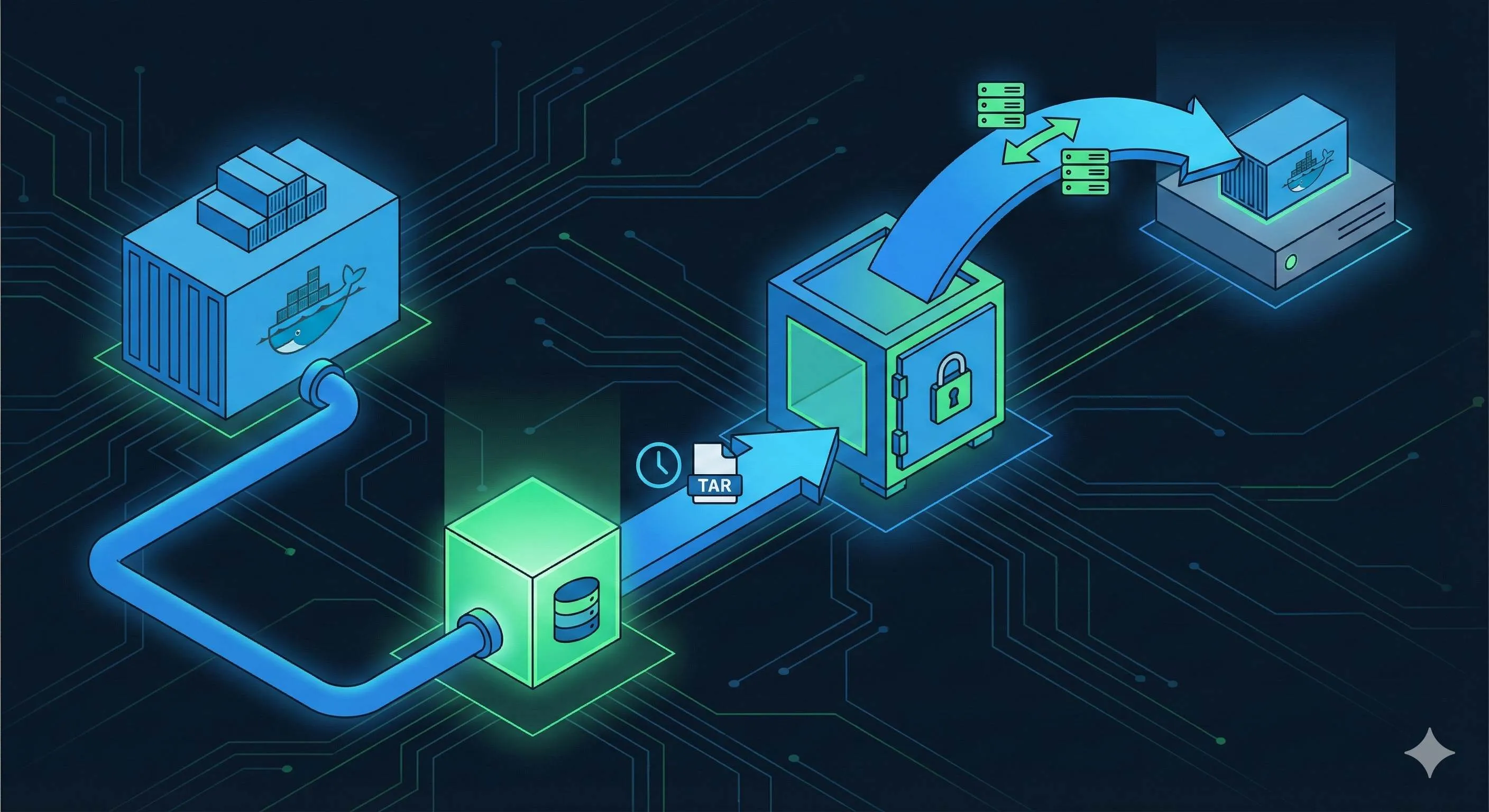

Docker数据卷备份与迁移实战指南:3种方法全面解析

去年双十一,公司决定把服务器从阿里云迁到腾讯云。老板突然找到我:“Docker里那些数据库数据怎么办?“说实话,当时我心里咯噔一下——跑了大半年的PostgreSQL容器,里面是几个GB的用户数据,我从来没备份过。

那天晚上我疯狂搜索Docker备份方法,看了无数教程。docker cp、tar打包、什么docker-volume-backup工具…越看越迷糊。每个方法看着都挺对,但就是不知道该用哪个,也不敢在生产环境上试。最怕的是备份到一半数据库正在写东西,结果搞出个损坏的备份文件。

后来踩了几次坑,也算摸清楚了门道。其实Docker数据备份没那么复杂,关键是要知道不同方法适合什么场景。这篇文章我就来聊聊3种主流的备份方法,每种方法我都会告诉你什么时候用、怎么用、以及要注意什么坑。看完你就知道怎么给自己的Docker应用做个靠谱的备份了。

为什么Docker数据备份很重要

Docker数据存储机制简介

很多人刚开始用Docker的时候,可能没太注意数据存储这回事。容器一启动就能用,数据也存着,看着挺好。但有个很多人容易忽略的点:容器本身是临时的。

你把数据直接写在容器里,下次重启容器或者更新镜像,数据就没了。所以Docker提供了两种持久化数据的方式:

- Volume(数据卷):Docker自己管理的存储区域,数据保存在

/var/lib/docker/volumes/目录下。这是官方推荐的方式,好处是Docker会帮你管理权限和生命周期。 - Bind Mount(挂载目录):直接把宿主机的某个目录挂到容器里。比如你把

/home/user/data挂到容器的/data,数据就存在你熟悉的地方,想备份直接cp就行。

对于哪些数据需要备份,我的建议是:

- 数据库文件(PostgreSQL、MySQL、MongoDB的数据目录)

- 用户上传的文件(头像、文档、图片)

- 配置文件(虽然大部分配置可以重建,但有些敏感配置还是备份保险)

- 日志文件(如果你要分析历史日志的话)

常见的数据丢失场景

我见过或者听说过的数据丢失事故,基本都是下面这几种:

手滑删容器。这是最常见的。你想删个测试容器,结果一个docker rm -v连数据卷一起删了。那个-v参数就是罪魁祸首——它会把关联的匿名volume一起删掉。我第一次用的时候也不知道,测试环境的数据库直接没了。

硬盘故障。服务器跑了两三年,突然硬盘SMART报警,赶紧换盘。数据倒是还能读出来,但那种心惊肉跳的感觉真不好受。如果平时有备份,就算硬盘挂了,换块新盘恢复一下,几十分钟就能跑起来。

服务器迁移。这个我开头就说了。无论是换机房、换云服务商,还是把服务从VPS迁到Kubernetes,数据怎么搬是个大问题。没有备份的话,你只能祈祷scp传输中途别断网。

还有个真实案例:去年一个朋友的创业公司,数据库容器不知道为什么自己崩了。重启之后发现volume里的数据损坏了,PostgreSQL启不来。最后找到的最近备份是两个月前的。两个月的订单数据全丢了,直接给公司造成了几十万损失。

说这些不是吓你,而是想说:定期备份真的很重要。数据丢了,再多的技术也救不回来。

3种备份方法详解

方法1:使用tar命令备份(⭐⭐⭐⭐⭐推荐)

这是我最常用的方法,适合各种场景。核心思路很简单:用一个临时容器把volume挂载进来,然后用tar打包。

备份命令:

docker run --rm \

-v postgres_data:/data:ro \

-v $(pwd):/backup \

ubuntu tar czf /backup/postgres-backup-20251217.tar.gz -C /data .拆解一下这个命令:

--rm:容器运行完自动删除,不留垃圾-v postgres_data:/data:ro:把要备份的volume(postgres_data)挂到容器的/data目录,:ro表示只读,防止误操作-v $(pwd):/backup:把当前目录挂到容器的/backup,备份文件就保存在这tar czf:c创建归档、z用gzip压缩、f指定文件名-C /data .:切换到/data目录,打包所有内容(.表示当前目录所有文件)

恢复命令:

docker run --rm \

-v postgres_data:/data \

-v $(pwd):/backup \

ubuntu tar xzf /backup/postgres-backup-20251217.tar.gz -C /data这里x表示解压,其他参数和备份时类似。

什么时候用这个方法?

- 适合所有volume类型,最通用

- 需要压缩以节省空间(压缩率能到30-50%)

- 要把备份文件传到其他服务器或云存储

注意事项:

我第一次用的时候犯了个错误:直接备份正在运行的MySQL容器。备份是成功了,但恢复的时候发现数据库启动报错,说表损坏。后来才知道,备份时如果数据库正在写入,可能捕获到不一致的状态。

最安全的做法:

- 停止写入(停止容器或锁表)

- 执行备份

- 恢复写入

如果实在不能停服务,至少要确保你的数据库开启了journal或WAL日志,这样即使备份时有写入,恢复后数据库也能自己修复。

实战案例:备份PostgreSQL数据

# 1. 停止PostgreSQL容器(如果可以的话)

docker stop my-postgres

# 2. 备份数据卷

docker run --rm \

-v postgres_data:/data:ro \

-v /backup:/backup \

ubuntu tar czf /backup/pg-$(date +%Y%m%d-%H%M%S).tar.gz -C /data .

# 3. 验证备份文件

ls -lh /backup/pg-*.tar.gz

# 4. 重启容器

docker start my-postgres命名上我喜欢加时间戳,这样一眼就能看出是什么时候备份的。

方法2:使用docker cp命令(⭐⭐⭐)

这个方法更直观,不需要打包,直接把文件复制出来。适合快速备份几个配置文件或小目录。

备份步骤:

# 1. 创建一个临时容器关联volume

docker create -v nginx_config:/data --name temp_backup busybox

# 2. 复制数据到宿主机

docker cp temp_backup:/data ./nginx-config-backup

# 3. 清理临时容器

docker rm temp_backup恢复步骤:

# 假设你要恢复到一个新的容器

docker cp ./nginx-config-backup/. my-nginx:/etc/nginx/什么时候用这个方法?

- 只需要备份几个配置文件

- 文件比较小(几十MB以内)

- 想快速查看备份内容(不用解压)

缺点:

- 不支持压缩,大文件占空间

- 传输速度比tar慢一些

- 不能完美保留所有权限和特殊属性

实战案例:备份Nginx配置

# 创建临时容器

docker create -v nginx_config:/config --name nginx_temp busybox

# 复制配置文件

docker cp nginx_temp:/config/nginx.conf ./backup/

# 也可以复制整个目录

docker cp nginx_temp:/config/. ./backup/nginx-config/

# 清理

docker rm nginx_temp我一般用这个方法备份配置文件。比如突然要改Nginx配置,改之前先docker cp一份出来,万一改崩了可以快速恢复。

方法3:使用docker-volume-backup工具(⭐⭐⭐⭐自动化首选)

前面两个方法都是手动操作,适合临时备份。但生产环境你肯定希望自动定时备份,这时候就该上工具了。

我现在用的是offen/docker-volume-backup,这是2025年比较流行的开源方案。它的厉害之处在于:

- 定时自动备份(cron表达式配置)

- 备份前自动停止容器,确保数据一致性

- 支持多种存储后端(S3、Google Drive、SSH、WebDAV)

- 自动清理旧备份

Docker Compose配置示例:

version: '3.8'

services:

# 你的数据库服务

postgres:

image: postgres:15

volumes:

- db_data:/var/lib/postgresql/data

labels:

# 标记这个容器需要在备份时停止

- "docker-volume-backup.stop-during-backup=true"

# 备份服务

backup:

image: offen/docker-volume-backup:latest

environment:

# 每天凌晨2点备份

BACKUP_CRON_EXPRESSION: "0 2 * * *"

# 备份文件命名

BACKUP_FILENAME: "db-backup-%Y%m%d-%H%M%S.tar.gz"

# 保留最近7天的备份

BACKUP_RETENTION_DAYS: "7"

volumes:

# 要备份的volume(只读)

- db_data:/backup/db_data:ro

# 备份文件保存位置

- ./backups:/archive

# 必须挂载Docker socket才能停止容器

- /var/run/docker.sock:/var/run/docker.sock:ro

volumes:

db_data:工作流程:

- 每天凌晨2点,备份容器启动

- 检测到

postgres容器有stop-during-backup标签,自动停止它 - 用tar打包

db_datavolume - 将备份文件保存到

./backups目录 - 自动启动

postgres容器 - 删除7天前的旧备份

什么时候用这个方法?

- 生产环境,需要定期自动备份

- 想要把备份传到云存储(S3、GCS等)

- 管理多个容器的备份

注意事项:

第一次配置的时候要注意权限问题。/var/run/docker.sock必须让备份容器能读取,不然它没法停止其他容器。

还有,这个工具会真的停止你的服务几秒到几十秒(取决于数据量)。如果你的服务不能停,就别用stop-during-backup标签,但那样就得接受可能备份到不一致状态的风险。

实战案例:MongoDB自动备份

version: '3.8'

services:

mongodb:

image: mongo:7

volumes:

- mongo_data:/data/db

labels:

- "docker-volume-backup.stop-during-backup=true"

backup:

image: offen/docker-volume-backup:latest

environment:

BACKUP_CRON_EXPRESSION: "0 3 * * *"

BACKUP_FILENAME: "mongo-%Y%m%d.tar.gz"

BACKUP_RETENTION_DAYS: "14"

# 备份到AWS S3

AWS_S3_BUCKET_NAME: "my-backups"

AWS_ACCESS_KEY_ID: "${AWS_KEY}"

AWS_SECRET_ACCESS_KEY: "${AWS_SECRET}"

volumes:

- mongo_data:/backup/mongo_data:ro

- /var/run/docker.sock:/var/run/docker.sock:ro

volumes:

mongo_data:这个配置会每天凌晨3点自动备份MongoDB,并把备份文件上传到S3,本地不保留。我用这个跑了半年多,很稳定。

数据迁移完整流程

服务器迁移实战步骤

说完了备份方法,咱们来聊聊实际迁移服务器的完整流程。我去年就经历过一次从阿里云迁到腾讯云,整个过程大概是这样的:

1. 准备阶段(千万别跳过)

先把现有环境摸清楚:

# 列出所有容器

docker ps -a

# 列出所有volume

docker volume ls

# 导出每个容器的配置(很重要!)

docker inspect my-postgres > postgres-config.json

docker inspect my-nginx > nginx-config.json

# 记录docker-compose.yml和.env文件

cp docker-compose.yml docker-compose.backup.yml

cp .env .env.backup这些配置文件一定要备份好。我第一次迁移的时候忘了保存环境变量,结果新服务器上数据库密码对不上,折腾了好久。

2. 备份阶段

停掉所有服务,开始备份:

# 停止所有容器

docker-compose down

# 备份每个volume

docker run --rm \

-v postgres_data:/data:ro \

-v $(pwd)/backups:/backup \

ubuntu tar czf /backup/postgres_data.tar.gz -C /data .

docker run --rm \

-v nginx_config:/data:ro \

-v $(pwd)/backups:/backup \

ubuntu tar czf /backup/nginx_config.tar.gz -C /data .

# 验证备份文件

ls -lh backups/

md5sum backups/*.tar.gz > backups/checksums.txt那个md5sum很重要。传输文件的时候,万一网络不稳定导致文件损坏,你至少能发现。

3. 迁移阶段

把备份文件传到新服务器:

# 我一般用rsync,可以断点续传

rsync -avP --partial backups/ user@new-server:/tmp/backups/

# 或者用scp

scp -r backups/ user@new-server:/tmp/backups/如果文件特别大(几十GB那种),网络又不太稳定,建议用云对象存储中转。先传到S3或OSS,再从新服务器下载,速度更快也更可靠。

在新服务器上恢复:

# 1. 创建volume

docker volume create postgres_data

docker volume create nginx_config

# 2. 恢复数据

docker run --rm \

-v postgres_data:/data \

-v /tmp/backups:/backup \

ubuntu tar xzf /backup/postgres_data.tar.gz -C /data

docker run --rm \

-v nginx_config:/data \

-v /tmp/backups:/backup \

ubuntu tar xzf /backup/nginx_config.tar.gz -C /data

# 3. 验证恢复的数据

docker run --rm -v postgres_data:/data ubuntu ls -lh /data

# 4. 启动服务

docker-compose up -d4. 验证阶段

服务启动后,别急着切流量。先验证:

# 检查容器状态

docker ps

# 查看日志,确保没有报错

docker-compose logs -f

# 测试数据库连接

docker exec -it my-postgres psql -U postgres -c "SELECT COUNT(*) FROM users;"

# 对比新旧服务器的数据

# (这一步我一般会写个脚本,对比关键表的记录数)都没问题了,再修改DNS或者负载均衡配置,把流量切过来。

我踩过的坑:

去年迁移的时候,有个volume特别大(50GB),用docker run tar的方式解压花了快一个小时。后来发现其实可以先用docker volume create创建volume,然后直接在宿主机上解压到/var/lib/docker/volumes/volume_name/_data,速度快得多。不过这种方式要注意权限问题。

数据库备份的特殊注意事项

数据库备份是个大坑,我单独说说。

为什么文件级备份不够可靠?

你想啊,数据库在运行的时候,数据是不断在写的。MySQL的InnoDB引擎有redo log、undo log,PostgreSQL有WAL日志,这些都是为了保证事务一致性。如果你直接tar打包数据文件,很可能打包到一半,数据库正好在写一个事务,你的备份就是个不一致的状态。

我见过最惨的案例:有人备份MySQL的时候,正好赶上数据库在做大事务(批量插入几百万条数据)。备份文件看着是正常的,但恢复之后MySQL死活启动不了,报InnoDB表空间损坏。

正确做法:用应用层备份

PostgreSQL:

# 备份单个数据库

docker exec my-postgres pg_dump -U postgres mydb > mydb-backup.sql

# 备份所有数据库

docker exec my-postgres pg_dumpall -U postgres > all-dbs-backup.sql

# 恢复

docker exec -i my-postgres psql -U postgres mydb < mydb-backup.sqlMySQL:

# 备份

docker exec my-mysql mysqldump -u root -p mydb > mydb-backup.sql

# 恢复

docker exec -i my-mysql mysql -u root -p mydb < mydb-backup.sqlMongoDB:

# 备份

docker exec my-mongo mongodump --out=/backup

docker cp my-mongo:/backup ./mongo-backup

# 恢复

docker cp ./mongo-backup my-mongo:/backup

docker exec my-mongo mongorestore /backup双保险策略:

我现在的做法是:应用层备份 + volume备份,两手抓。

- 应用层备份(pg_dump等):作为主要的恢复手段,数据一致性有保证

- volume备份(tar打包):作为灾难恢复的后备方案,万一应用层备份失败或损坏,至少还有个文件级备份可以试试

这样虽然多占点空间,但保险啊。那个朋友公司丢数据的事,就是只有volume备份,恢复的时候发现损坏了,应用层备份根本没做。

最佳实践和避坑指南

备份策略设计

有了备份方法,还得有个合理的备份策略。不然要么备份太频繁浪费资源,要么太少了丢数据。

3-2-1原则(业界通用的备份黄金法则):

- 3份副本:原始数据 + 2份备份

- 2种存储介质:比如本地硬盘 + 云存储,或者两块不同的硬盘

- 1份异地存储:至少有1份备份在不同地理位置(防火灾、地震等)

听着挺复杂,其实实现起来不难。我的做法:

- 本地服务器保留最近7天的每日备份(第1份)

- NAS上保留最近30天的备份(第2份,不同存储介质)

- S3上保留最近3个月的月度备份(第3份,异地存储)

备份频率建议:

| 数据重要性 | 备份频率 | 保留策略 |

|---|---|---|

| 核心数据库 | 每小时 | 最近24小时每小时1份,最近7天每天1份 |

| 一般应用数据 | 每天 | 最近7天每天1份,最近4周每周1份 |

| 配置文件 | 改动时 | 每次修改前手动备份,保留最近10个版本 |

| 日志文件 | 每周 | 最近4周每周1份 |

备份命名规范:

别小看命名,混乱的命名会让你恢复的时候抓狂。我的命名格式:

<服务名>-<数据类型>-<YYYYMMDD>-<HHMMSS>.tar.gz示例:

myapp-postgres-20251217-020000.tar.gz

myapp-nginx-config-20251217-020000.tar.gz

myapp-uploads-20251217-020000.tar.gz这样排序的时候自然按时间顺序,一眼就能看出是什么时候的备份。

常见问题和解决方案

问题1:备份时提示”volume is in use”

这个错误一般不会真的出现,因为volume可以同时挂载到多个容器。但如果你遇到了,可能是因为:

- 容器有文件锁

- NFS或其他网络存储的挂载问题

解决办法:

# 检查哪些容器在使用这个volume

docker ps --filter volume=my_volume

# 如果可以的话,停止这些容器

docker stop container_name

# 或者使用--volumes-from参数

docker run --rm --volumes-from=my_container -v $(pwd):/backup ubuntu tar czf /backup/data.tar.gz -C /data .问题2:恢复后文件权限不对

这个我也遇到过。tar打包默认会保留权限信息,但如果你在不同的系统之间迁移(比如Ubuntu到CentOS),UID/GID可能对不上。

症状:容器启动报错,说没权限读写某些文件。

解决办法:

# 恢复时指定owner

docker run --rm -v my_volume:/data -v $(pwd):/backup ubuntu sh -c "tar xzf /backup/data.tar.gz -C /data && chown -R 999:999 /data"

# 999:999是PostgreSQL容器里的postgres用户UID

# 不同镜像的UID不一样,需要查文档或docker inspect查看问题3:备份文件太大,传输困难

我之前备份一个50GB的MySQL数据库,用gzip压缩后还有30GB。走公网传输慢得要死,还经常中断。

解决办法:

用更高压缩率:xz格式比gzip压缩率高20-30%,就是速度慢点

tar cJf backup.tar.xz /data # J表示xz压缩分卷压缩:适合传到一些有文件大小限制的地方

tar czf - /data | split -b 1G - backup.tar.gz. # 恢复时:cat backup.tar.gz.* | tar xzf -增量备份:只备份变化的文件(需要工具支持,比如rsync或专门的备份软件)

问题4:恢复时发现备份文件损坏

最坑的情况——备份的时候没发现问题,需要用的时候才发现文件损坏。

预防措施:

# 备份完立即校验

md5sum backup.tar.gz > backup.tar.gz.md5

# 传输到新服务器后再次校验

md5sum -c backup.tar.gz.md5

# 定期测试恢复(这个最重要!)

# 每个月找个测试环境,实际恢复一次备份,验证能不能用我现在的习惯:每次备份完,都会试着解压前几个文件看看,至少保证备份文件本身是完整的。

自动化和监控

手动备份虽然可靠,但人总会忘。生产环境必须自动化。

用crontab定时执行备份脚本:

# 创建备份脚本 /opt/scripts/backup-docker-volumes.sh

#!/bin/bash

DATE=$(date +%Y%m%d-%H%M%S)

BACKUP_DIR=/backup

# 备份PostgreSQL

docker run --rm \

-v postgres_data:/data:ro \

-v $BACKUP_DIR:/backup \

ubuntu tar czf /backup/postgres-$DATE.tar.gz -C /data .

# 备份Nginx配置

docker run --rm \

-v nginx_config:/data:ro \

-v $BACKUP_DIR:/backup \

ubuntu tar czf /backup/nginx-$DATE.tar.gz -C /data .

# 清理7天前的旧备份

find $BACKUP_DIR -name "*.tar.gz" -mtime +7 -delete

# 发送通知(可选)

echo "Backup completed: $DATE" | mail -s "Docker Backup Report" [email protected]# 添加到crontab

crontab -e

# 每天凌晨2点执行

0 2 * * * /opt/scripts/backup-docker-volumes.sh >> /var/log/docker-backup.log 2>&1监控和告警:

光自动化还不够,还得知道备份有没有成功。我的做法:

- 记录日志:每次备份都记log,包含时间、文件大小、MD5

- 监控脚本:每天检查是否有新的备份文件生成,如果没有就告警

- 文件大小异常检测:如果备份文件突然变得很大或很小(超过平均值50%),可能有问题

简单的监控脚本:

#!/bin/bash

BACKUP_DIR=/backup

EXPECTED_SIZE=100000000 # 100MB,根据你的实际情况调整

LATEST_BACKUP=$(ls -t $BACKUP_DIR/postgres-*.tar.gz | head -1)

if [ -z "$LATEST_BACKUP" ]; then

echo "ERROR: No backup file found!"

exit 1

fi

# 检查备份文件是否是今天的

BACKUP_DATE=$(stat -c %Y "$LATEST_BACKUP")

TODAY=$(date +%s)

AGE=$((TODAY - BACKUP_DATE))

if [ $AGE -gt 86400 ]; then

echo "ERROR: Latest backup is older than 24 hours!"

exit 1

fi

# 检查文件大小

SIZE=$(stat -c %s "$LATEST_BACKUP")

if [ $SIZE -lt $(($EXPECTED_SIZE / 2)) ]; then

echo "WARNING: Backup file is too small: $SIZE bytes"

exit 1

fi

echo "Backup check passed: $LATEST_BACKUP ($SIZE bytes)"这些监控脚本可以集成到你的监控系统(Prometheus、Zabbix等),或者直接发邮件/企业微信通知。

结论

说了这么多,回到最开始的问题:Docker数据怎么备份?

其实答案很简单:没有哪个方法是万能的,关键是根据你的场景选对方法。

- 临时备份、快速迁移:用tar方法,通用靠谱

- 配置文件、小文件:docker cp就够了,简单直接

- 生产环境、需要自动化:上docker-volume-backup,省心省力

还有最重要的一点:定期备份,定期测试恢复。别等到真的需要恢复数据的时候,才发现备份文件损坏或者根本恢复不了。我每个月都会找个测试环境,把最新的备份实际恢复一遍,验证流程没问题。

最后给你个建议:今天就给你的Docker应用做第一次备份吧。不需要很复杂,就用最简单的tar方法,备份一次试试。备份文件躺在硬盘里,心里踏实多了。

如果你在备份过程中遇到什么问题,或者有更好的方法,欢迎在评论区聊聊。大家一起交流,才能少踩坑。

Docker数据卷备份与迁移完整流程

3种方法全面解析:tar打包、docker cp命令和自动化工具,包含数据库备份注意事项和服务器迁移完整流程

⏱️ 预计耗时: 1 小时

- 1

步骤1: 理解问题背景和3种备份方法

问题背景:

• 跑了大半年的PostgreSQL容器,里面是几个GB的用户数据

• 从来没备份过,服务器迁移时数据怎么办?

• 需要可靠的备份方案

3种备份方法:

1. tar打包(推荐)

• docker run --rm -v volume-name:/data -v $(pwd):/backup alpine tar czf /backup/backup.tar.gz /data

• 适合一次性备份,简单可靠,可以压缩节省空间

2. docker cp命令

• docker cp container-name:/data ./backup

• 适合小文件备份,直接复制文件,不需要额外工具

3. 自动化工具

• docker-volume-backup、velero等

• 适合定期备份,支持自动调度,支持多种存储后端 - 2

步骤2: 数据库备份注意事项和服务器迁移

数据库备份注意事项:

• 备份前停止数据库或使用pg_dump等工具

• 避免备份时数据库正在写数据导致损坏

• 使用--volumes-from参数备份运行中的容器数据

MySQL备份:

• 使用mysqldump导出数据

• 或停止容器后备份数据目录

PostgreSQL备份:

• 使用pg_dump导出数据

• 或停止容器后备份数据目录

Redis备份:

• 使用redis-cli --rdb导出RDB文件

• 或停止容器后备份数据目录

服务器迁移完整流程:

1. 备份数据卷(使用tar或docker cp)

2. 传输备份文件到新服务器(使用scp、rsync等)

3. 在新服务器上恢复数据卷:

docker run --rm -v volume-name:/data -v $(pwd):/backup alpine tar xzf /backup/backup.tar.gz -C /data

4. 启动容器并验证数据

验证步骤:

• 检查数据文件是否存在

• 检查文件权限是否正确

• 测试应用是否能正常访问数据 - 3

步骤3: 最佳实践和自动化

最佳实践:

• 定期备份数据卷

• 使用自动化工具

• 测试备份恢复流程

• 备份前停止数据库或使用数据库备份工具

• 验证备份文件完整性

还有最重要的一点:

• 定期备份,定期测试恢复

• 别等到真的需要恢复数据的时候,才发现备份文件损坏或者根本恢复不了

• 我每个月都会找个测试环境,把最新的备份实际恢复一遍,验证流程没问题

今天就给你的Docker应用做第一次备份吧,不需要很复杂,就用最简单的tar方法,备份一次试试,备份文件躺在硬盘里,心里踏实多了。

常见问题

Docker数据卷备份有哪些方法?

1) tar打包:docker run --rm -v volume-name:/data -v $(pwd):/backup alpine tar czf /backup/backup.tar.gz /data

2) docker cp命令:docker cp container-name:/data ./backup

3) 自动化工具:docker-volume-backup、velero等

方法对比:

• tar打包:适合一次性备份,简单可靠,可以压缩节省空间

• docker cp命令:适合小文件备份,直接复制文件,不需要额外工具

• 自动化工具:适合定期备份,支持自动调度,支持多种存储后端

数据库备份需要注意什么?

• 备份前停止数据库或使用pg_dump等工具

• 避免备份时数据库正在写数据导致损坏

• 使用--volumes-from参数备份运行中的容器数据

不同数据库的备份方法:

• MySQL备份:使用mysqldump导出数据,或停止容器后备份数据目录

• PostgreSQL备份:使用pg_dump导出数据,或停止容器后备份数据目录

• Redis备份:使用redis-cli --rdb导出RDB文件,或停止容器后备份数据目录

如何迁移Docker数据卷到新服务器?

1) 备份数据卷(使用tar或docker cp)

2) 传输备份文件到新服务器(使用scp、rsync等)

3) 在新服务器上恢复数据卷:

docker run --rm -v volume-name:/data -v $(pwd):/backup alpine tar xzf /backup/backup.tar.gz -C /data

4) 启动容器并验证数据

验证步骤:

• 检查数据文件是否存在

• 检查文件权限是否正确

• 测试应用是否能正常访问数据

Docker数据备份的最佳实践是什么?

• 定期备份数据卷

• 使用自动化工具

• 测试备份恢复流程

• 备份前停止数据库或使用数据库备份工具

• 验证备份文件完整性

还有最重要的一点:

• 定期备份,定期测试恢复

• 别等到真的需要恢复数据的时候,才发现备份文件损坏或者根本恢复不了

• 我每个月都会找个测试环境,把最新的备份实际恢复一遍,验证流程没问题

今天就给你的Docker应用做第一次备份吧,不需要很复杂,就用最简单的tar方法,备份一次试试,备份文件躺在硬盘里,心里踏实多了。

15 分钟阅读 · 发布于: 2025年12月17日 · 修改于: 2026年2月5日

评论

使用 GitHub 账号登录后即可评论