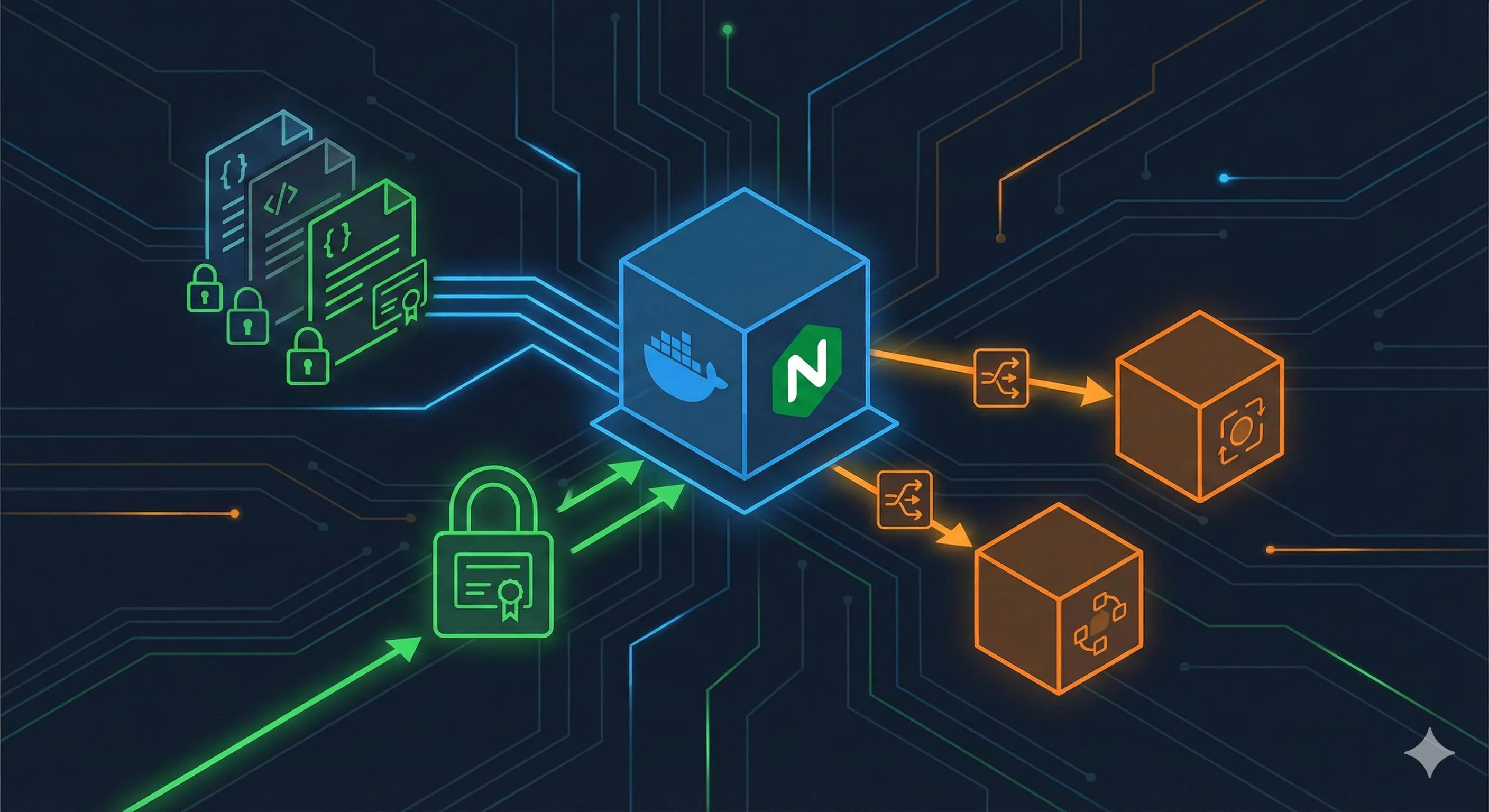

Docker部署Nginx完全指南:配置文件挂载、HTTPS配置与反向代理实战

引言

凌晨一点,我盯着终端里的 docker restart nginx 命令,第七次按下回车键。刷新浏览器——还是那个该死的502错误页面。明明改了nginx.conf,为啥容器里的配置就是不生效?我当时的内心OS大概是:Docker你是不是在逗我玩?

如果你也有过这种经历,恭喜,你不是一个人。Docker部署Nginx的配置问题,几乎是每个做容器化的人都踩过的坑。配置文件挂载、HTTPS证书、容器间通信——这些看起来简单的操作,实际上暗藏各种细节陷阱。

说实话,我花了好几个通宵才搞明白这些门道。今天这篇文章,我会把自己踩过的坑、找到的解决方案,全都掰开了揉碎了讲清楚。从配置文件正确的挂载方式,到HTTPS证书的自动续期,再到反向代理其他容器的网络配置——给你一个完整可用的Docker Nginx部署方案。

你将学到:

- 配置文件为什么改了不生效,以及5种正确的挂载姿势

- HTTPS证书从自签名到Let’s Encrypt的完整配置路径

- 反向代理其他Docker容器时的网络配置技巧

- 生产环境的安全加固和性能调优实战

Docker Nginx基础配置与文件挂载

为什么一定要挂载配置文件?

你可能会问:直接把Nginx配置打包进镜像不行吗?行是行,但那酸爽…

每次改个配置就要重新构建镜像、推送到仓库、再拉下来重启容器——整个流程走下来十几分钟过去了。更别提配置版本管理、多环境切换这些需求了。凌晨两点线上出了问题,你想快速回滚配置,结果还得等镜像构建?那画面,不敢想。

挂载配置文件就是为了解决这个痛点:修改宿主机的文件,容器内立即生效。测试、回滚、团队协作都方便多了。

Nginx容器的关键目录结构

先搞清楚Nginx在容器里的家当都放在哪儿:

/etc/nginx/

├── nginx.conf # 主配置文件,老大哥

├── conf.d/ # 子配置文件目录,各个站点配置放这

│ └── default.conf # 默认站点配置

/usr/share/nginx/html # 静态文件根目录

/var/log/nginx/ # 日志目录

├── access.log

└── error.log关键点来了:nginx.conf里有一行 include /etc/nginx/conf.d/*.conf;。这意味着主配置会自动加载conf.d目录下的所有.conf文件。如果你只挂载了nginx.conf,忘了挂载conf.d——恭喜你发现了第一个坑。

正确的挂载方式:step by step

别急着启动容器。先做个准备工作,能省你后面一堆麻烦。

步骤1:复制容器默认配置作为模板

为啥要这么做?官方的默认配置是经过测试的,直接拿来改比自己从零写靠谱。

# 先启动一个临时容器

docker run --name nginx-temp -d nginx

# 把默认配置复制出来

docker cp nginx-temp:/etc/nginx/nginx.conf ./nginx/nginx.conf

docker cp nginx-temp:/etc/nginx/conf.d ./nginx/conf.d

# 用完删掉

docker stop nginx-temp && docker rm nginx-temp步骤2:在宿主机创建标准目录结构

我的习惯是所有Docker相关文件都放在 /opt 下,你可以根据自己的喜好调整:

mkdir -p /opt/nginx/{conf,conf.d,html,logs,ssl}这个目录结构覆盖了配置、静态文件、日志、SSL证书的所有需求。一步到位。

步骤3:启动容器并挂载所有目录

重头戏来了。注意看每个 -v 参数后面的路径映射:

docker run -d --name my-nginx \

-p 80:80 -p 443:443 \

-v /opt/nginx/conf/nginx.conf:/etc/nginx/nginx.conf:ro \

-v /opt/nginx/conf.d:/etc/nginx/conf.d \

-v /opt/nginx/html:/usr/share/nginx/html \

-v /opt/nginx/logs:/var/log/nginx \

-v /opt/nginx/ssl:/etc/nginx/ssl \

nginx几个要点:

-p 80:80 -p 443:443:同时暴露HTTP和HTTPS端口(后面配HTTPS要用)nginx.conf后面加了:ro(只读挂载),防止容器内进程误改配置conf.d挂载整个目录,而非单个文件(这个很关键,下面会说为啥)

四个你可能踩的坑

坑1:用vim编辑配置后容器内不同步

这是我遇到的第一个坑。改了宿主机的nginx.conf,重启容器,没效果。

原因:vim编辑文件时会改变文件的inode值。Docker挂载是通过inode关联的,inode变了,容器内的文件自然还是老的。

解决办法有两个:

- 方案A:用nano编辑器(不改inode)

- 方案B:挂载整个目录而不是单个文件

我现在都用方案B。挂载目录的话,文件inode怎么变都不影响,还能灵活添加删除配置文件。

坑2:include路径配置错误

进容器看看你的nginx.conf:

docker exec -it my-nginx bash

cat /etc/nginx/nginx.conf | grep include确保这一行存在:

include /etc/nginx/conf.d/*.conf;如果你把它改成了 /opt/nginx/conf.d/*.conf(宿主机路径),那就错了。容器内只认容器内的路径。

坑3:忘记挂载conf.d目录

单独挂载nginx.conf是不够的。你在宿主机的conf.d下加了新站点配置,容器里压根看不到。

验证方法:

docker exec my-nginx ls /etc/nginx/conf.d应该能看到你宿主机 /opt/nginx/conf.d 下的所有文件。

坑4:文件权限导致Nginx读不了配置

这个在Linux系统上容易遇到。配置文件权限太严格,Nginx进程(通常是nginx用户)没权限读取。

解决:

chmod 644 /opt/nginx/conf/nginx.conf

chmod 644 /opt/nginx/conf.d/*.conf改完配置后,养成习惯测试一下语法:

docker exec my-nginx nginx -t看到 syntax is ok 就放心了。

单文件挂载 vs 目录挂载:该选哪个?

这是个经常被问到的问题。我的建议:

主配置nginx.conf:可以单文件挂载+只读(:ro),因为它基本不会频繁改动

conf.d目录:必须目录挂载,方便灵活添加新站点配置

html、logs:目录挂载,没啥好说的

记住一个原则:需要灵活管理多个文件的,就挂载目录;核心配置文件想要版本控制的,可以单文件挂载但加上只读保护。

HTTPS配置与Let’s Encrypt自动续期

自签名证书:开发环境快速验证

生产环境肯定要用正规证书,但开发测试阶段,自签名证书够用了。几条命令搞定:

openssl req -x509 -nodes -days 365 -newkey rsa:2048 \

-keyout /opt/nginx/ssl/nginx.key \

-out /opt/nginx/ssl/nginx.crt \

-subj "/C=CN/ST=Beijing/L=Beijing/O=Dev/CN=localhost"这个命令会生成两个文件:

nginx.key:私钥,千万别泄露nginx.crt:证书文件

然后在 /opt/nginx/conf.d/ 下创建一个 ssl.conf:

server {

listen 443 ssl;

server_name localhost;

ssl_certificate /etc/nginx/ssl/nginx.crt;

ssl_certificate_key /etc/nginx/ssl/nginx.key;

ssl_protocols TLSv1.2 TLSv1.3;

ssl_ciphers HIGH:!aNULL:!MD5;

location / {

root /usr/share/nginx/html;

index index.html;

}

}重点:

ssl_certificate路径是容器内路径(/etc/nginx/ssl),不是宿主机的/opt/nginx/sslssl_protocols只开TLS 1.2和1.3,老版本协议有安全漏洞- 启动容器时别忘了

-p 443:443,不然HTTPS端口没暴露

热重载配置:

docker exec my-nginx nginx -s reload访问 https://localhost,浏览器会警告证书不受信任——别慌,这是正常的。自签名证书就是这样,点”继续访问”就行。

Let’s Encrypt:生产环境免费证书

Let’s Encrypt是真香。免费、自动化、全球信任。唯一的”缺点”是证书90天过期,但配置好自动续期就没事了。

这里我推荐用 docker-compose + certbot 容器的方案,比手动折腾靠谱多了。

先看完整的 docker-compose.yml:

version: '3'

services:

nginx:

image: nginx:latest

container_name: my-nginx

ports:

- "80:80"

- "443:443"

volumes:

- ./nginx/conf.d:/etc/nginx/conf.d

- ./nginx/html:/usr/share/nginx/html

- ./certbot/conf:/etc/letsencrypt

- ./certbot/www:/var/www/certbot

command: "/bin/sh -c 'while :; do sleep 6h & wait $${!}; nginx -s reload; done & nginx -g \"daemon off;\"'"

networks:

- web

certbot:

image: certbot/certbot

container_name: certbot

volumes:

- ./certbot/conf:/etc/letsencrypt

- ./certbot/www:/var/www/certbot

entrypoint: "/bin/sh -c 'trap exit TERM; while :; do certbot renew; sleep 12h & wait $${!}; done;'"

networks:

- web

networks:

web:

driver: bridge几个关键点:

1. 证书和验证文件的共享挂载

./certbot/conf挂载到两个容器,certbot生成证书,nginx读取证书./certbot/www用于Let’s Encrypt的HTTP验证(webroot方式)

2. Nginx每6小时自动reload

这行命令看着复杂,实际就是后台启动一个循环,每6小时reload一次配置,这样证书续期后能立即生效。

3. Certbot每12小时检查续期

Let’s Encrypt建议每天检查一次,这里设成12小时更保险。

首次申请证书的步骤

在 /opt/nginx/conf.d/ 下先创建一个临时配置 temp.conf,用于HTTP验证:

server {

listen 80;

server_name your-domain.com; # 改成你的域名

location /.well-known/acme-challenge/ {

root /var/www/certbot;

}

location / {

return 301 https://$host$request_uri;

}

}启动服务:

docker-compose up -d申请证书(把your-domain.com和[email protected]换成你的):

docker-compose run --rm certbot certonly --webroot \

-w /var/www/certbot \

-d your-domain.com \

--email [email protected] \

--agree-tos \

--no-eff-email如果一切顺利,你会看到”Congratulations!”字样。证书文件在 ./certbot/conf/live/your-domain.com/ 目录下。

现在可以创建正式的HTTPS配置了。修改 temp.conf 为:

server {

listen 80;

server_name your-domain.com;

location /.well-known/acme-challenge/ {

root /var/www/certbot;

}

location / {

return 301 https://$host$request_uri;

}

}

server {

listen 443 ssl http2;

server_name your-domain.com;

ssl_certificate /etc/letsencrypt/live/your-domain.com/fullchain.pem;

ssl_certificate_key /etc/letsencrypt/live/your-domain.com/privkey.pem;

# SSL优化配置

ssl_session_cache shared:SSL:10m;

ssl_session_timeout 10m;

ssl_protocols TLSv1.2 TLSv1.3;

ssl_ciphers 'ECDHE-ECDSA-AES128-GCM-SHA256:ECDHE-RSA-AES128-GCM-SHA256';

ssl_prefer_server_ciphers on;

# HSTS(强制HTTPS)

add_header Strict-Transport-Security "max-age=31536000; includeSubDomains" always;

location / {

root /usr/share/nginx/html;

index index.html;

}

}reload配置:

docker-compose exec nginx nginx -s reload自动续期的验证

Let’s Encrypt证书90天有效,但certbot会在剩余30天时自动续期。你可以手动测试一下:

docker-compose run --rm certbot renew --dry-run看到”The dry run was successful”就OK了。

还可以检查cron日志,看续期任务是否正常运行:

docker-compose logs certbotHTTPS配置的安全加分项

如果你想让SSL配置更安全,可以加上这些:

# OCSP Stapling(在线证书状态检查)

ssl_stapling on;

ssl_stapling_verify on;

ssl_trusted_certificate /etc/letsencrypt/live/your-domain.com/chain.pem;

resolver 8.8.8.8 8.8.4.4 valid=300s;

resolver_timeout 5s;

# 禁止iframe嵌入(防点击劫持)

add_header X-Frame-Options DENY;

# 防XSS

add_header X-Content-Type-Options nosniff;

add_header X-XSS-Protection "1; mode=block";配置完后,可以去 SSL Labs 测试一下你的SSL配置评分。做到A+不难。

反向代理与Docker容器间通信

容器网络的那些事儿

说到用Nginx代理其他Docker容器,最让人头疼的就是网络配置。你可能试过直接用容器IP,结果重启一次IP就变了——配置又得改。

Docker有几种网络模式,常用的是这两种:

- bridge(桥接):默认模式,容器之间通过虚拟网桥通信

- host:容器直接用宿主机的网络栈,性能好但隔离性差

对于Nginx反向代理场景,我强烈推荐自定义bridge网络。为啥?

- 容器间可以直接用服务名通信,不用关心IP变化

- 网络隔离,一个项目的容器组成独立的网络环境

- 自动DNS解析,Docker内置的服务发现机制

创建自定义网络并运行容器

先创建一个自定义网络:

docker network create my-app-network启动你的后端服务(假设是个Node.js API):

docker run -d \

--name backend-api \

--network my-app-network \

-e NODE_ENV=production \

my-backend:latest启动Nginx,同样连接到这个网络:

docker run -d \

--name my-nginx \

--network my-app-network \

-p 80:80 -p 443:443 \

-v /opt/nginx/conf.d:/etc/nginx/conf.d \

nginx关键点:两个容器在同一个网络里,Nginx配置中就可以直接用 backend-api 这个名字访问后端服务了。

Nginx反向代理配置实战

在 /opt/nginx/conf.d/ 下创建 api-proxy.conf:

upstream backend {

server backend-api:3000; # 容器名:端口

keepalive 32;

}

server {

listen 80;

server_name api.example.com;

# API接口代理

location /api/ {

proxy_pass http://backend/;

# 传递真实客户端信息

proxy_set_header Host $host;

proxy_set_header X-Real-IP $remote_addr;

proxy_set_header X-Forwarded-For $proxy_add_x_forwarded_for;

proxy_set_header X-Forwarded-Proto $scheme;

# WebSocket支持(如果需要)

proxy_http_version 1.1;

proxy_set_header Upgrade $http_upgrade;

proxy_set_header Connection "upgrade";

# 超时设置

proxy_connect_timeout 60s;

proxy_send_timeout 60s;

proxy_read_timeout 60s;

}

# 静态文件直接由Nginx处理

location / {

root /usr/share/nginx/html;

index index.html;

try_files $uri $uri/ /index.html;

}

}几个容易忽略的细节:

1. upstream和proxy_pass的路径处理

注意 proxy_pass http://backend/; 最后有个斜杠。这意味着请求 /api/users 会被转发为 http://backend/users(去掉/api前缀)。

如果写成 proxy_pass http://backend;(没斜杠),则转发为 http://backend/api/users(保留完整路径)。

2. X-Forwarded-For头部的重要性

后端服务如果需要获取真实客户端IP,就得靠这个头部。不然后端看到的都是Nginx容器的IP。

3. keepalive连接池

upstream 里的 keepalive 32 能复用TCP连接,减少握手开销。对高并发场景很有用。

用docker-compose简化多容器管理

手动创建网络、一个个启动容器太麻烦了。用docker-compose一键搞定:

version: '3.8'

services:

backend:

image: my-backend:latest

container_name: backend-api

environment:

- NODE_ENV=production

- DATABASE_URL=postgres://db:5432/mydb

networks:

- app-network

depends_on:

- db

nginx:

image: nginx:latest

container_name: my-nginx

ports:

- "80:80"

- "443:443"

volumes:

- ./nginx/conf.d:/etc/nginx/conf.d

- ./nginx/html:/usr/share/nginx/html

- ./nginx/logs:/var/log/nginx

networks:

- app-network

depends_on:

- backend

db:

image: postgres:14

container_name: postgres-db

environment:

- POSTGRES_PASSWORD=secret

- POSTGRES_DB=mydb

volumes:

- db-data:/var/lib/postgresql/data

networks:

- app-network

networks:

app-network:

driver: bridge

volumes:

db-data:一行命令启动整个服务栈:

docker-compose up -dDocker会自动:

- 创建名为

app-network的网络 - 按照

depends_on顺序启动容器 - 设置容器间的DNS解析

你的Nginx配置里直接用 backend 和 db 作为主机名就能访问对应服务。爽歪歪。

常见代理问题的排查套路

问题1:502 Bad Gateway

最常见的错误,原因通常是:

- 后端服务没启动或挂了

- Nginx和后端不在同一个网络

- 后端监听的端口不对

排查步骤:

# 检查后端服务是否运行

docker ps | grep backend

# 检查网络连接

docker network inspect my-app-network

# 进入Nginx容器测试连通性

docker exec -it my-nginx sh

ping backend-api

curl http://backend-api:3000/health如果ping不通,说明网络配置有问题。如果curl返回超时,说明后端服务监听有问题。

问题2:请求超时

默认的proxy超时是60秒。如果你的API处理时间长(比如大文件上传、复杂计算),需要加大超时:

location /api/long-running/ {

proxy_pass http://backend/;

proxy_connect_timeout 300s;

proxy_send_timeout 300s;

proxy_read_timeout 300s;

}问题3:POST请求体丢失

有时候POST请求到后端变成GET了,或者请求体为空。检查这个配置:

location /api/ {

proxy_pass http://backend/;

proxy_request_buffering off; # 禁用请求缓冲

client_max_body_size 100M; # 允许大文件上传

}多个后端服务的负载均衡

如果你的后端服务有多个实例,Nginx可以做负载均衡:

upstream backend_cluster {

least_conn; # 最少连接算法

server backend-1:3000 weight=3; # 权重3

server backend-2:3000 weight=1; # 权重1

server backend-3:3000 backup; # 备用服务器

keepalive 32;

}

server {

listen 80;

location /api/ {

proxy_pass http://backend_cluster/;

# ... 其他proxy设置

}

}负载均衡算法有几种:

round-robin(默认):轮询least_conn:最少连接数优先ip_hash:同一客户端IP始终分配到同一台服务器

如果某个后端挂了,Nginx会自动把流量切到其他健康的节点。

生产环境最佳实践与性能优化

配置文件管理:不要裸奔上线

把配置文件直接扔在服务器上?那是开发环境的玩法。生产环境得有点讲究。

用Git管理配置

我的做法是单独建一个仓库存所有Nginx配置,不同环境分目录管理。好处显而易见:

- 版本历史一目了然,回滚就是

git checkout - 团队协作方便,PR review配置变更

- CI/CD集成,自动化部署

配置模板化

不同环境的配置大同小异,用模板+变量替换能省很多事。部署时用 envsubst 替换变量即可。

日志管理:别等硬盘满了才想起来

Nginx日志写得挺快的,高流量站点一天几个G不稀奇。不管好,哪天硬盘满了容器直接挂。

日志轮转配置

在宿主机上配置 logrotate,每天轮转日志,保留14天,自动压缩旧日志。关键是轮转后要让Nginx重新打开日志文件(nginx -s reopen),不然它还在写旧文件。

集中式日志方案

如果你有多台服务器,可以考虑把日志发到集中式平台(ELK、Loki、云服务)。用Docker日志驱动或Promtail都很简单。

优雅重载:别让用户感知到

改完配置后,千万别直接 docker restart。重启会断开所有连接,正在处理的请求全丢了。

正确姿势:

# 先测试配置语法

docker exec my-nginx nginx -t

# 语法没问题再reload

docker exec my-nginx nginx -s reloadreload 是优雅重载:新worker进程启动加载新配置,老worker处理完现有请求后退出,全程无缝切换,用户无感知。

安全加固清单

生产环境上线前,这些安全点记得检查:

1. 隐藏Nginx版本号

默认情况下,错误页面会暴露Nginx版本。黑客能据此针对性攻击已知漏洞。在http块加 server_tokens off; 隐藏版本号。

2. 限流防DDoS

简单有效的防护:

http {

# 限制每个IP的请求频率

limit_req_zone $binary_remote_addr zone=api_limit:10m rate=10r/s;

# 限制并发连接数

limit_conn_zone $binary_remote_addr zone=conn_limit:10m;

}

server {

location /api/ {

limit_req zone=api_limit burst=20 nodelay;

limit_conn conn_limit 10;

proxy_pass http://backend/;

}

}3. 配置文件只读挂载

主配置加 :ro 防止容器内进程误改。

4. 最小权限原则

确保nginx.conf里有 user nginx;,不要改成root,安全风险极大。

性能调优:榨干Nginx的性能

worker进程数优化

worker_processes auto; # 自动匹配CPU核心数

worker_cpu_affinity auto; # 绑定CPU亲和性auto 是懒人福音,Nginx会自动检测CPU核心数。

连接数优化

events {

worker_connections 2048; # 每个worker最大连接数

use epoll; # Linux下用epoll性能最好

}理论最大并发:worker_processes * worker_connections。但实际还要考虑文件句柄限制(ulimit -n)。

gzip压缩

文本内容压缩后能减少60-80%的传输量:

http {

gzip on;

gzip_vary on;

gzip_proxied any;

gzip_comp_level 6; # 压缩级别1-9,6是性能和压缩率的平衡点

gzip_types

text/plain

text/css

text/xml

application/json

application/javascript

application/xml+rss

application/atom+xml

image/svg+xml;

gzip_min_length 1000; # 小于1KB的文件不压缩,反而浪费CPU

}静态资源缓存

location ~* \.(jpg|jpeg|png|gif|ico|css|js|woff2)$ {

expires 30d; # 浏览器缓存30天

add_header Cache-Control "public, immutable";

}HTTP/2支持

HTTP/2能显著提升性能,开启很简单:

server {

listen 443 ssl http2; # 加个http2就行

# ... 其他配置

}前提是你得有HTTPS,HTTP/2必须基于TLS。

监控和健康检查

最后别忘了监控。推荐用Prometheus + Grafana,配合nginx-prometheus-exporter导出指标。在Nginx配置中开启stub_status,限制只允许Docker内部网络访问,然后在Prometheus抓取metrics,Grafana展示监控面板。

结论

说了这么多,核心就是四件事:

配置文件挂载:目录挂载优于单文件,主配置加只读保护,别忘了conf.d和ssl目录。vim的inode坑记得避开。

HTTPS配置:开发用自签名快速验证,生产用Let’s Encrypt+Certbot自动化。docker-compose能让续期变得无脑简单。

反向代理:自定义bridge网络是王道,用容器名通信省心。upstream配置加上keepalive,性能和可靠性都有保障。

生产实践:Git管理配置版本,日志轮转别忘记,优雅reload不要restart,该加的安全策略一个别落下。

Docker Nginx这套东西看着简单,实际上细节很多。但搞明白这些,你就能搭出一个从开发到生产都稳定可靠的Web服务架构了。

如果这篇文章帮你避开了几个坑,或者解决了困扰你很久的问题,那就值了。动手试试吧,遇到问题欢迎留言交流。

最后给个建议:把这篇文章里的配置模板都保存下来,下次直接复用。轮子不用重复造,省下的时间多陪陪家人不香吗?

Docker部署Nginx完整流程

配置文件挂载、HTTPS配置与反向代理实战,解决配置不生效、容器互联等常见问题

⏱️ 预计耗时: 1 小时

- 1

步骤1: 配置文件挂载:5种正确的挂载姿势

5种正确的挂载姿势:

• 挂载配置文件目录:-v ./nginx.conf:/etc/nginx/nginx.conf

• 挂载配置目录:-v ./conf.d:/etc/nginx/conf.d

• 使用Volume挂载

• 使用docker-compose配置

• 使用ConfigMap(K8s环境)

常见问题:

• 配置文件改了不生效,明明改了nginx.conf,为啥容器里的配置就是不生效?

• 需要正确挂载配置文件,使用-v参数挂载配置文件目录

• 确保配置文件格式正确

最佳实践:

• 目录挂载优于单文件

• 主配置加只读保护

• 别忘了conf.d和ssl目录

• vim的inode坑记得避开 - 2

步骤2: HTTPS配置和Let's Encrypt自动续期

HTTPS配置:

• 使用Let's Encrypt免费证书

• 配置自动续期:certbot renew

• 挂载证书目录:-v ./certs:/etc/nginx/certs

• 配置SSL证书路径

• 支持HTTP/2和TLS 1.3

Let's Encrypt配置:

• 使用certbot获取证书:certbot certonly --standalone

• 配置自动续期:certbot renew --dry-run

• 挂载证书到容器:-v ./letsencrypt:/etc/letsencrypt

• 配置nginx.conf使用证书 - 3

步骤3: 反向代理配置和生产环境最佳实践

反向代理配置:

• 配置upstream指向后端容器

• 使用容器名或服务名:proxy_pass http://backend:8080

• 配置健康检查

• 处理CORS问题

• 配置负载均衡

生产环境最佳实践:

• 使用docker-compose管理多容器

• 配置健康检查

• 设置资源限制

• 配置日志轮转

• 使用环境变量管理配置

• 定期更新镜像

Docker Nginx这套东西看着简单,实际上细节很多,但搞明白这些,你就能搭出一个从开发到生产都稳定可靠的Web服务架构了。

常见问题

为什么Docker Nginx配置文件改了不生效?

5种正确的挂载姿势:

1) 挂载配置文件目录:-v ./nginx.conf:/etc/nginx/nginx.conf

2) 挂载配置目录:-v ./conf.d:/etc/nginx/conf.d

3) 使用Volume挂载

4) 使用docker-compose配置

5) 使用ConfigMap(K8s环境)

最佳实践:

• 目录挂载优于单文件

• 主配置加只读保护

• 别忘了conf.d和ssl目录

• vim的inode坑记得避开

如何配置Docker Nginx的HTTPS?

• 使用Let's Encrypt免费证书

• 配置自动续期:certbot renew

• 挂载证书目录:-v ./certs:/etc/nginx/certs

• 配置SSL证书路径

• 支持HTTP/2和TLS 1.3

Let's Encrypt配置:

• 使用certbot获取证书:certbot certonly --standalone

• 配置自动续期:certbot renew --dry-run

• 挂载证书到容器:-v ./letsencrypt:/etc/letsencrypt

• 配置nginx.conf使用证书

如何配置Docker Nginx反向代理?

• 配置upstream指向后端容器

• 使用容器名或服务名:proxy_pass http://backend:8080

• 配置健康检查

• 处理CORS问题

• 配置负载均衡

容器互联:

• 使用docker-compose创建自定义网络

• 确保容器在同一网络中

• 使用服务名或容器名访问

• 配置upstream指向后端服务

Docker Nginx生产环境最佳实践是什么?

• 使用docker-compose管理多容器

• 配置健康检查

• 设置资源限制

• 配置日志轮转

• 使用环境变量管理配置

• 定期更新镜像

Docker Nginx这套东西看着简单,实际上细节很多,但搞明白这些,你就能搭出一个从开发到生产都稳定可靠的Web服务架构了。

建议:把这篇文章里的配置模板都保存下来,下次直接复用,轮子不用重复造。

14 分钟阅读 · 发布于: 2025年12月18日 · 修改于: 2026年2月5日

评论

使用 GitHub 账号登录后即可评论