Docker资源限制完全指南:防止容器内存泄漏拖垮服务器

凌晨3点,手机尖锐的告警铃声把我从梦中拽醒。睡眼惺忪地解锁屏幕——“服务器无响应”、“CPU 100%”、“SSH连接超时”。一股凉意从后背窜上来。

摸黑爬起来打开电脑,VPN拨了三次才连上,终端窗口里敲下ssh命令——超时。再试——还是超时。心里咯噔一下:完了,服务器卡死了。

只能硬重启。五分钟后服务器终于恢复,赶紧看日志。结果让我冷汗直流:某个跑了半年的容器内存泄漏,从最初的500MB一路飙到16GB,把整个服务器的内存吃干抹净,连SSH都没资源响应了。更惨的是,其他三个正常运行的容器也跟着挂了——生产环境直接炸锅。

说实话,这种事在Docker社区太常见了。2024年Docker 27.0.3版本就曝出过严重的内存泄漏Bug,导致68个容器被Linux内核的OOM Killer一锅端。你可能会想:“我就跑几个容器,应该不会遇到这种问题吧?“相信我,我当初也这么想。

这篇文章要聊的不是”如何避免应用内存泄漏”——那是开发团队的事。咱们要搞定的是:怎么防止单个容器把整个服务器拖垮。从cgroups底层原理到--memory、--cpus参数的实战用法,再到docker stats、cAdvisor、Prometheus三大监控工具,一次性讲清楚Docker资源限制这件事。学完之后,你至少能做到:发现内存泄漏的苗头时容器自己挂掉,而不是让整个服务器陪葬。

为什么容器会拖垮服务器?

Docker有个”特性”——默认情况下,容器对资源的使用没有任何限制。听起来挺自由的,对吧?自由到容器可以把宿主机的内存和CPU全部吃光,然后所有人一起玩完。

Docker 27.4.0的真实案例:有用户发现dockerd守护进程在几天内从几百MB膨胀到8GB,最后把服务器拖到响应迟缓。你不能怪Docker不稳定——问题在于,如果你不主动设置限制,容器就像脱缰的野马,想吃多少资源就吃多少。

这时候Linux内核会启动一个”杀手”机制——OOM Killer(Out Of Memory Killer)。当系统内存不够用时,它会挑一个”最合适”的进程杀掉来释放内存。怎么挑?内核会给每个进程打分(oom_score),分数越高越容易被杀。容器里的进程通常分数挺高,但Docker daemon自己比较聪明,会调低自己的OOM优先级(oom_score_adj设为-500),所以挨刀的往往是你的容器。

你在docker ps里看到容器消失了,去查日志会发现Exit Code是137。这个数字的意思是:128 + 9(SIGKILL信号),翻译成人话就是”被强制杀死了”。不是优雅退出,是被内核一刀砍了。

内存泄漏的症状长这样:

- 容器内存占用像坐火箭,从几百MB涨到几个GB不停

- 服务器开始疯狂用swap(交换分区),硬盘灯狂闪

- 其他容器响应越来越慢,最后干脆挂掉

- 你的监控图表出现一条漂亮的斜向上直线

2024年有个Storj社区的案例特别夸张:某个容器内存从正常的几百MB一路飙到37GB,差点把整个存储节点搞崩。要是提前设了内存限制,容器到1GB就会被OOM Killer收拾掉,服务器稳如老狗。

[图片:内存泄漏曲线图]

提示词:server memory usage graph showing sharp upward spike, red critical zone at 90%, dark background, monitoring dashboard style, high quality

cgroups:资源限制的底层原理

你可能听说过Docker是用”cgroups”实现资源限制的,但这玩意到底是啥?说白了,cgroups(Control Groups)是Linux内核的一个功能,专门用来给进程组设置资源配额——就像给每个进程发了一张”资源卡”,卡里的额度用完就不能再透支了。

Docker在创建容器时会自动创建一个cgroup,然后把容器的进程塞进去。你在运行docker run -m 512m nginx的时候,Docker背后是往/sys/fs/cgroup/memory/docker/<容器ID>/这个目录下的memory.limit_in_bytes文件里写了个值:536870912(512MB的字节数)。内核读到这个文件,嗯,这个容器最多用512MB,超了就干掉。

cgroups v1 vs v2的区别:

- v1:把内存、CPU、磁盘I/O分成独立的子系统,像分散的部门各管各的

- v2:统一管理,层级结构更清晰,更适合容器这种需要整体控制的场景

- 老系统(比如RHEL 7)还在用v1,新系统(Ubuntu 20.04+、RHEL 8+)基本都换v2了

你要是好奇容器实际的cgroup配置长啥样,可以这么查:

# 找到容器的完整ID

docker inspect --format='{{.Id}}' my_container

# 查看内存限制(cgroups v1)

cat /sys/fs/cgroup/memory/docker/<容器ID>/memory.limit_in_bytes

# 查看CPU配额(cgroups v1)

cat /sys/fs/cgroup/cpu/docker/<容器ID>/cpu.cfs_quota_us我第一次看到这些文件时还挺懵的:怎么资源限制是靠文件系统实现的?后来才明白,这是Linux的”一切皆文件”哲学——内核把cgroup的配置暴露成文件,Docker往文件里写值,内核读文件来执行限制。挺优雅的设计。

[图片:cgroups层级结构示意图]

提示词:Linux cgroups hierarchy diagram, containers grouped under docker cgroup, memory and CPU subsystems, tree structure, technical illustration, clean design, high quality

内存限制参数全解析

Docker的内存参数看着一堆,但真正常用的就几个。咱们挨个拆解。

1. --memory / -m(硬限制,最关键)

这是救命参数。容器内存用到这个值就会触发OOM Killer,容器直接被杀。最小可以设6MB(虽然基本没法跑啥),实际生产环境怎么也得给个几百MB起步。

# 限制容器最多用512MB内存

docker run -m 512m nginx

# 也可以用GB单位

docker run -m 2g my-app怎么设合适?我的经验是:压测一下应用正常运行时的内存占用,然后乘以1.2到1.5倍。比如应用平时用300MB,设400-450MB比较稳妥。设太低容器频繁被杀,设太高又失去了保护作用。

2. --memory-swap(交换空间,容易被误解)

这个参数挺绕的,很多人搞不明白。它设置的是内存+swap的总量,不是单独的swap大小。

# 512MB内存 + 512MB swap(总共1GB可用)

docker run -m 512m --memory-swap 1g nginx

# 禁用swap(只用内存)

docker run -m 512m --memory-swap 512m nginx

# 允许无限swap(危险!)

docker run -m 512m --memory-swap -1 nginx如果你不设--memory-swap,默认行为是:swap = memory,也就是总共可用内存是memory的两倍。比如-m 512m的容器实际能用到1GB(512m内存 + 512m swap)。

生产环境建议:要么禁用swap(--memory-swap等于--memory),要么限制swap不超过内存的一半。别设成-1,不然容器疯狂用swap会把硬盘拖垮。

3. --memory-reservation(软限制)

这是一个”弹性额度”。服务器内存够用时,容器可以超过这个值;内存紧张时,内核会尽量把容器压回到这个值以下。它必须小于--memory。

# 软限制750MB,硬限制1GB

docker run -m 1g --memory-reservation 750m nginx适用场景:有些应用偶尔会短时间吃很多内存(比如跑批处理),但平时用的少。设个软限制能让资源更灵活。

4. --kernel-memory(内核内存,慎用)

限制容器使用的内核内存(比如网络缓冲区、文件系统缓存),这部分内存不能被swap。老实讲,除非你很清楚自己在干嘛,否则别碰这个参数——设不好容器启动都启动不了。

5. --oom-kill-disable(危险参数,划重点)

禁用OOM Killer,让容器内存超限时不被杀死。听起来挺好?大错特错。如果容器内存失控又不会被杀,结果就是整个服务器内存被耗尽。

# 这样用会出人命!(容器可以无限吃内存)

docker run --oom-kill-disable nginx

# 如果非要用,必须同时设置内存限制

docker run -m 512m --oom-kill-disable nginx啥时候用这个参数?几乎不用。除非你有个特殊应用,必须保证进程不会被突然杀死(比如数据库的checkpoint过程),而且你能保证应用自己会控制内存。

真实案例:AWS有个用户把EC2实例跑崩了,查半天发现是某个容器没设内存限制,跑着跑着吃了30GB,把实例搞到完全无响应。加了-m 2g之后,容器到限制就自己挂掉重启,服务器稳得很。

[图片:内存参数关系示意图]

提示词:Docker memory parameters diagram, showing memory and swap relationship, visual chart with bars and labels, technical illustration, blue and orange colors, high quality

CPU限制参数全解析

CPU限制比内存限制温柔一些——超了不会被杀,只是被”掐”住速度。但失控的CPU一样能把服务器搞到卡死。

1. --cpus(最直观的方式)

直接指定容器能用几个CPU核心,支持小数。

# 最多使用1.5个CPU核心

docker run --cpus="1.5" nginx

# 只用半个核心

docker run --cpus="0.5" my-app这个参数底层是通过--cpu-period和--cpu-quota实现的,Docker帮你算好了比例。设成1.5的话,容器在任意时刻最多占用1.5个核心的计算能力——跑满1个核还能用另一个核的50%。

2. --cpu-shares(相对权重,不是硬限制)

这个参数设置的是CPU调度的优先级,默认值1024。关键在于:它只在CPU资源紧张时才生效。服务器CPU充足的话,容器想用多少用多少。

# 容器A获得2倍于容器B的CPU时间

docker run --cpu-shares 2048 --name app_a my-app

docker run --cpu-shares 1024 --name app_b my-app比如服务器只有2个核心都在满负荷运行,上面两个容器会按2:1的比例分配CPU——容器A拿到大约1.33个核,容器B拿0.67个核。但要是服务器CPU很闲,两个容器都能跑到满速。

什么时候用?当你有多个容器,希望在资源竞争时优先保证某个重要服务(比如API服务优先于后台任务)。

3. --cpuset-cpus(绑定到特定核心)

把容器钉死在某几个CPU核心上,别的核心不让用。

# 只使用第0和第3个核心

docker run --cpuset-cpus="0,3" nginx

# 使用第2到第5个核心

docker run --cpuset-cpus="2-5" my-app适用场景:

- NUMA架构:多路CPU服务器,把容器绑定到同一个CPU socket的核心上,减少跨socket内存访问

- 避免缓存失效:容器进程在固定核心上跑,CPU缓存命中率更高

- 隔离关键服务:把重要容器绑定到专用核心,避免被其他容器干扰

我见过一个Kubernetes环境,把数据库容器绑定到8核服务器的后4个核心,前4个核心给Web服务用,性能提升挺明显的。

4. --cpu-period 和 --cpu-quota(精细控制)

这是底层参数,--cpus就是对这俩的封装。

--cpu-period:CFS(完全公平调度器)的调度周期,默认100000微秒(100毫秒)--cpu-quota:在一个周期内,容器能用多少微秒的CPU时间

# 在100ms周期内,只能用50ms CPU时间(相当于0.5个核心)

docker run --cpu-period=100000 --cpu-quota=50000 nginx

# 等价于

docker run --cpus="0.5" nginx大部分时候用--cpus就够了,除非你要非常精细地控制(比如周期设短点让调度更频繁)。

真实案例:有个服务出了Bug,某个容器的线程池死循环,CPU飙到了800%(服务器是8核的)。没设限制,整个服务器被拖垮,SSH都连不上。后来给所有容器加了--cpus="2"的限制,再出这种Bug也只会拖慢自己,其他容器稳如老狗。

[图片:CPU限制对比测试]

提示词:CPU usage comparison chart, with and without limits, before/after graph showing CPU spike prevention, performance monitoring dashboard, clean visualization, high quality

实战监控方案

设了资源限制只是第一步,你还得知道容器实际用了多少资源。不然等内存泄漏泄到触发OOM时再发现,已经晚了。

工具1:docker stats(内置,零成本)

最简单的方式,Docker自带的。

# 实时刷新,Ctrl+C退出

docker stats

# 只输出一次,适合脚本调用

docker stats --no-stream

# 只看特定容器

docker stats nginx_container mysql_container输出长这样:

CONTAINER ID NAME CPU % MEM USAGE / LIMIT MEM % NET I/O

a1b2c3d4e5f6 nginx 0.50% 45.2MiB / 512MiB 8.83% 1.2kB / 0B优点:开箱即用,不用装东西。

缺点:只能看当前状态,没法回溯历史、没法告警、没法可视化。适合临时排查问题,不适合长期监控。

工具2:cAdvisor(Google出品,容器监控专家)

cAdvisor(Container Advisor)会自动检测宿主机上所有容器,收集CPU、内存、网络、磁盘I/O等指标,还提供了Web界面和Prometheus格式的metrics接口。

运行很简单:

docker run -d \

--name=cadvisor \

--restart=always \

-p 8080:8080 \

-v /:/rootfs:ro \

-v /var/run:/var/run:ro \

-v /sys:/sys:ro \

-v /var/lib/docker/:/var/lib/docker:ro \

-v /dev/disk/:/dev/disk:ro \

gcr.io/cadvisor/cadvisor:latest启动后访问 http://服务器IP:8080,就能看到每个容器的资源使用趋势图。访问 http://服务器IP:8080/metrics 能拿到Prometheus格式的数据。

优点:专业、全面、支持Prometheus生态。

缺点:只能保留最近2分钟的数据,想看历史趋势还得配合Prometheus。

工具3:Prometheus + Grafana(企业级方案)

这是完整的监控体系:

- cAdvisor:采集容器指标

- Prometheus:抓取并存储指标数据

- Grafana:可视化+告警

完整的docker-compose.yml配置:

version: '3.8'

services:

cadvisor:

image: gcr.io/cadvisor/cadvisor:latest

container_name: cadvisor

ports:

- "8080:8080"

volumes:

- /:/rootfs:ro

- /var/run:/var/run:ro

- /sys:/sys:ro

- /var/lib/docker/:/var/lib/docker:ro

- /dev/disk/:/dev/disk:ro

restart: always

prometheus:

image: prom/prometheus:latest

container_name: prometheus

ports:

- "9090:9090"

volumes:

- ./prometheus.yml:/etc/prometheus/prometheus.yml

- prometheus_data:/prometheus

command:

- '--config.file=/etc/prometheus/prometheus.yml'

- '--storage.tsdb.path=/prometheus'

restart: always

grafana:

image: grafana/grafana:latest

container_name: grafana

ports:

- "3000:3000"

volumes:

- grafana_data:/var/lib/grafana

environment:

- GF_SECURITY_ADMIN_PASSWORD=admin

restart: always

volumes:

prometheus_data:

grafana_data:配套的prometheus.yml:

global:

scrape_interval: 15s

scrape_configs:

- job_name: 'cadvisor'

static_configs:

- targets: ['cadvisor:8080']部署完后:

- Prometheus会每15秒从cAdvisor抓取数据

- Grafana访问

http://服务器IP:3000(默认账号admin/admin) - 添加Prometheus数据源(地址填

http://prometheus:9090) - 导入Grafana仪表盘模板(推荐Dashboard ID: 19908,专门为Docker容器设计的)

关键监控指标:

container_memory_usage_bytes:容器当前内存使用量container_memory_max_usage_bytes:容器内存使用的历史最高值container_cpu_load_average_10s:10秒平均CPU负载container_fs_io_time_seconds_total:磁盘I/O时间

设个告警规则,内存使用率超过80%时发邮件或钉钉通知,能在问题爆发前抓住苗头。

说实话,这套系统搭起来有点折腾,但一劳永逸。我现在管的20多个容器全靠Grafana监控,半夜再也没被叫醒过。

[图片:Grafana容器监控仪表盘]

提示词:Grafana dashboard showing Docker container metrics, memory and CPU graphs, clean modern UI, dark theme, monitoring panels with colorful charts, high quality

诊断内存泄漏的完整流程

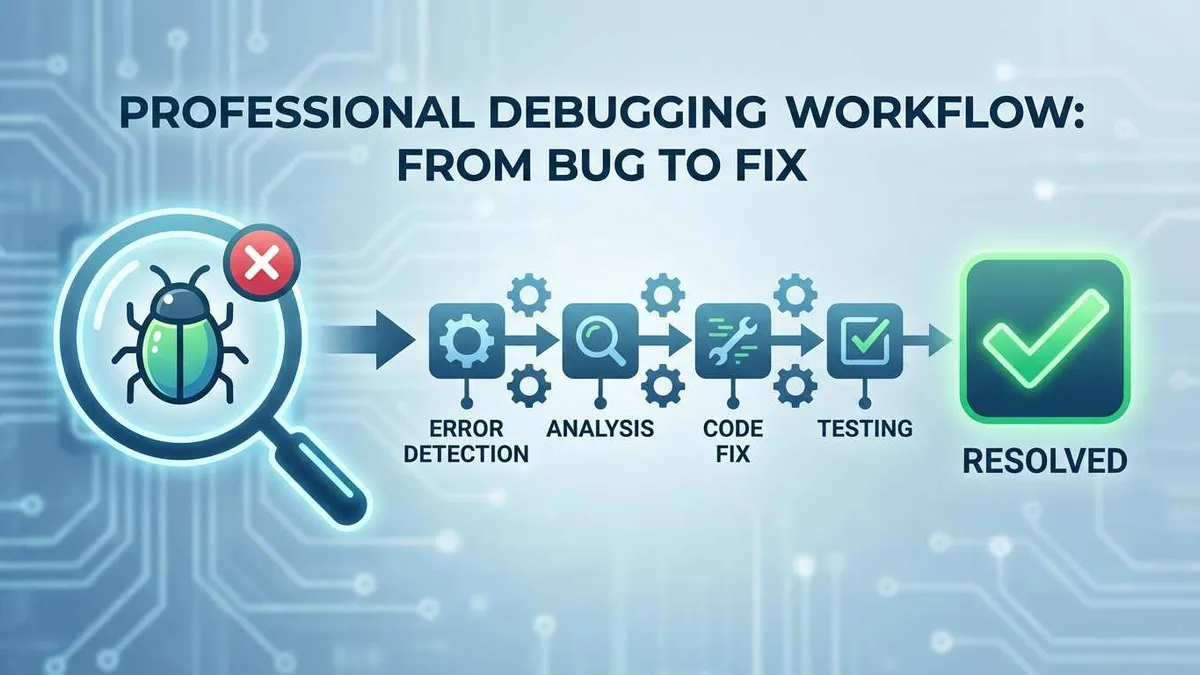

监控告警响了,或者容器莫名其妙挂了,怎么快速定位问题?按这个流程来。

第一步:发现异常

先用docker stats看看是哪个容器的内存在疯长:

docker stats --no-stream | grep -v "0.00%"发现某个容器内存占用已经接近限制了?查一下最近有没有被OOM killer杀过:

# 查看容器事件日志

docker events --filter 'event=oom' --since '24h'

# 查看容器的退出状态

docker inspect <容器名> --format='{{.State.ExitCode}}'

# 如果返回137,说明被OOM killer干掉了第二步:分析内存占用

进入容器内部看看到底是哪个进程在吃内存:

# 进入容器

docker exec -it <容器名> /bin/bash

# 看进程内存排行(需要容器里有top/htop)

top -o %MEM

# 或者用ps

ps aux --sort=-%mem | head -n 10如果容器里装了Java应用,可以导出heap dump分析:

# 找到Java进程PID

jps

# 导出heap dump

jcmd <PID> GC.heap_dump /tmp/heap.hprof

# 把文件拷贝出来分析

docker cp <容器名>:/tmp/heap.hprof ./第三步:应急处理

问题已经影响服务了,先临时缓解:

# 重启容器(会丢失容器内的临时数据)

docker restart <容器名>

# 如果容器还在跑,可以动态调整内存限制

docker update --memory 1g --memory-swap 1g <容器名>

# 清理系统中的无用资源(慎用,会删除未使用的镜像和容器)

docker system prune -a第四步:根治方案

临时措施只是止血,治本还得靠这些:

- 修复应用代码:找到内存泄漏的根源(忘记关闭连接、缓存无限增长、大对象未释放等),修改代码

- 设置资源限制:如果还没设,赶紧加上

--memory参数 - 部署监控:搭起Prometheus+Grafana,下次问题还没爆发就能收到告警

- 容器自动重启:加上

--restart=on-failure:3,OOM后自动重启最多3次

命令速查清单:

# 查看所有容器的资源限制配置

docker ps --format "{{.Names}}" | xargs docker inspect \

--format='{{.Name}}: Memory={{.HostConfig.Memory}} CPU={{.HostConfig.NanoCpus}}'

# 查看容器的历史重启次数

docker inspect --format='{{.RestartCount}}' <容器名>

# 查看容器的详细日志(最后100行)

docker logs --tail 100 <容器名>

# 查看容器内存使用明细

docker stats --no-stream --format \

"table {{.Name}}\t{{.MemUsage}}\t{{.MemPerc}}" <容器名>真实案例回顾:Storj的那个37GB内存泄漏案例,用户最后这么解决的:

- 发现容器内存飙升后,先

docker restart临时恢复服务 - 加上

-m 1g限制,避免再次拖垮宿主机 - 导出容器日志和heap dump,发给开发团队分析

- 等新版本修复Bug后,升级镜像重新部署

- 部署cAdvisor监控,设置内存使用率超过70%时告警

整个过程虽然折腾,但学到教训后,后面再也没出过类似问题。

[图片:内存诊断流程图]

提示词:flowchart showing memory leak diagnosis process, step by step from detection to resolution, arrows connecting boxes, clean infographic style, blue and green colors, high quality

最佳实践与避坑指南

说了这么多参数和工具,咱们总结一下怎么在生产环境正确使用。

生产环境必做清单

✅ 所有容器必须设置内存限制

别心存侥幸。哪怕是个Nginx静态文件服务器,也给它设个512MB。宁可保守一点,也别等出事再补救。

✅ 开发环境模拟生产限制

别在本地跑容器时不设限制,上生产才发现内存不够。开发环境就按生产环境的80%来设,提前发现问题。

✅ 定期审查资源使用

每个月看一次docker stats,有些容器可能需求变了,该加资源加,该降资源降。

❌ 不要禁用OOM killer

除非你100%确定应用会自己控制内存,否则别碰--oom-kill-disable。这是自杀式参数。

❌ 不要用无限swap--memory-swap -1 看着诱人,实际上是给服务器埋雷。容器疯狂用swap会把硬盘拖死,还不如让它被OOM killer收拾了痛快。

❌ 不要内存限制设太低

低于应用实际需求的限制会导致频繁OOM,反而降低可用性。先压测,再设限制。

Docker Compose中的正确姿势

services:

web:

image: nginx:latest

deploy:

resources:

limits:

cpus: '1.5'

memory: 512M

reservations:

cpus: '0.5'

memory: 256M

restart: on-failure:3注意这里用了deploy字段(Docker Compose v3语法)。limits是硬限制,reservations是软限制。容器平时用256MB就够,忙的时候可以用到512MB。

批量管理多个容器

如果你有一组微服务容器,想统一设置资源池,可以用cgroup-parent:

# 创建一个cgroup父组,限制总资源

docker run --cgroup-parent=/my-services -m 2g service-a

docker run --cgroup-parent=/my-services -m 2g service-b

# 两个容器共享一个cgroup,总内存不超过父组限制适用场景:多个关联容器组成一个业务单元,希望整体控制资源。

资源限制的经验公式

| 应用类型 | 内存限制建议 | CPU限制建议 |

|---|---|---|

| Nginx静态服务 | 256-512MB | 0.5-1核 |

| Node.js API | 512MB-1GB | 1-2核 |

| Java微服务 | 1-2GB | 2-4核 |

| 数据库(MySQL/PostgreSQL) | 2-4GB | 2-4核 |

| 消息队列(RabbitMQ/Kafka) | 1-2GB | 1-2核 |

这是保守估计,实际还得看业务量。压测时观察容器的资源使用峰值,然后乘以1.5倍作为限制值比较稳妥。

对比Kubernetes的资源管理

如果你用过Kubernetes,会发现它的requests和limits概念跟Docker的参数很像:

- requests:类似Docker的

--memory-reservation - limits:类似Docker的

--memory

K8s的好处是资源限制配置更规范(写在YAML里统一管理),Docker的灵活性更高(可以随时docker update调整)。

最后的忠告

资源限制不是”一次设置,永久有效”。应用会变,业务量会涨,监控数据会告诉你是该加资源还是该优化代码。定期回顾,别让配置成为摆设。

[图片:资源限制配置对比表]

提示词:comparison table showing Docker resource limits best practices, checkmarks and crosses, clean infographic style, professional layout, high quality

总结

回到开头的故事:凌晨3点被告警叫醒,服务器被容器拖崩。那个惨痛的教训让我明白,Docker的默认”自由”是个陷阱。你不主动设限制,就等于把服务器的生杀大权交给了容器。

现在回过头看,防御体系很清晰:

第一道防线:资源限制(预防)

给每个容器设--memory和--cpus,就像给野马套上缰绳。容器失控时自己挂掉,不会拖累整个服务器。这是最基础也最关键的一步。

第二道防线:监控告警(发现)

docker stats能让你看到当前状态,cAdvisor+Prometheus+Grafana能让你看到趋势和历史。内存使用率超过80%时告警,能在灾难发生前48小时发现苗头。

第三道防线:诊断流程(应对)

真出了问题,按流程来:发现异常 → 分析占用 → 应急处理 → 根治方案。别慌,命令清单都在文章里了。

从cgroups的底层原理到--memory-swap的参数细节,从Docker Compose配置到Kubernetes对比,这篇文章把Docker资源限制该讲的基本讲完了。剩下的是你的行动。

现在就做这三件事:

- 检查你的生产环境,跑这个命令看看哪些容器没设限制:

docker ps --format "{{.Names}}" | xargs docker inspect \

--format='{{.Name}}: Memory={{.HostConfig.Memory}} CPU={{.HostConfig.NanoCpus}}'Memory=0的容器就是定时炸弹。

部署监控方案,文章里的docker-compose.yml直接复制下来跑起来,30分钟搞定。

定个日历提醒,每个月花1小时看一次

docker stats,审查资源使用是否合理。

说实话,我不希望你像我一样,被凌晨3点的告警教育。资源限制这事,越早做越省心。别等出了事再后悔。

Docker资源限制完整配置流程

防止容器内存泄漏拖垮服务器,从cgroups原理到--memory、--cpus参数实战,再到监控方案

⏱️ 预计耗时: 1 小时

- 1

步骤1: 理解问题严重性和cgroups原理

问题严重性:

• 容器内存泄漏从500MB一路飙到16GB

• 把整个服务器的内存吃干抹净,连SSH都没资源响应了

• 其他正常运行的容器也跟着挂了,生产环境直接炸锅

cgroups原理:

• Linux内核的cgroups机制控制容器资源使用

• Docker通过cgroups限制CPU、内存、IO等资源

• 防止单个容器拖垮整个服务器

2024年Docker 27.0.3版本就曝出过严重的内存泄漏Bug,导致68个容器被Linux内核的OOM Killer一锅端。 - 2

步骤2: 配置资源限制:内存和CPU

内存限制:

• 使用--memory参数限制内存:docker run --memory=512m container-name

• 使用docker-compose配置资源限制:deploy.resources.limits.memory: 512m

• 设置内存交换限制:--memory-swap

CPU限制:

• 使用--cpus参数限制CPU:docker run --cpus=1.0 container-name

• 使用--cpu-shares设置CPU权重

• 使用docker-compose配置:deploy.resources.limits.cpus: '1.0'

验证限制:

• 使用docker stats查看容器资源使用情况

• 确认限制生效 - 3

步骤3: 部署监控方案和最佳实践

监控方案:

• docker stats实时监控容器资源使用:docker stats container-name

• cAdvisor提供可视化监控界面:

docker run -d -p 8080:8080 --name=cadvisor google/cadvisor

• Prometheus+Grafana实现生产级监控告警:

配置Prometheus抓取cAdvisor指标,Grafana可视化展示

最佳实践:

• 生产环境必须配置资源限制

• 设置合理的限制值(内存、CPU)

• 配置监控告警

• 定期检查容器资源使用情况(每个月花1小时看一次docker stats)

• 发现异常及时处理

常见问题

为什么需要配置Docker资源限制?

• 容器内存泄漏从500MB一路飙到16GB

• 把整个服务器的内存吃干抹净,连SSH都没资源响应了

• 其他正常运行的容器也跟着挂了,生产环境直接炸锅

2024年Docker 27.0.3版本就曝出过严重的内存泄漏Bug,导致68个容器被Linux内核的OOM Killer一锅端。

资源限制可以防止单个容器把整个服务器拖垮,发现内存泄漏的苗头时容器自己挂掉,而不是让整个服务器陪葬。

如何配置Docker容器资源限制?

• 使用--memory参数限制内存:docker run --memory=512m container-name

• 使用docker-compose配置资源限制:deploy.resources.limits.memory: 512m

• 设置内存交换限制:--memory-swap

CPU限制:

• 使用--cpus参数限制CPU:docker run --cpus=1.0 container-name

• 使用--cpu-shares设置CPU权重

• 使用docker-compose配置:deploy.resources.limits.cpus: '1.0'

验证限制:

• 使用docker stats查看容器资源使用情况

• 确认限制生效

如何监控Docker容器资源使用?

docker stats实时监控:

• docker stats container-name

cAdvisor提供可视化监控界面:

• docker run -d -p 8080:8080 --name=cadvisor google/cadvisor

Prometheus+Grafana实现生产级监控告警:

• 配置Prometheus抓取cAdvisor指标

• Grafana可视化展示

部署监控方案:文章里的docker-compose.yml直接复制下来跑起来,30分钟搞定。

定期检查:每个月花1小时看一次docker stats,审查资源使用是否合理。

Docker资源限制的最佳实践是什么?

• 生产环境必须配置资源限制

• 设置合理的限制值(内存、CPU)

• 配置监控告警

• 定期检查容器资源使用情况(每个月花1小时看一次docker stats)

• 发现异常及时处理

资源限制这事,越早做越省心,别等出了事再后悔。定个日历提醒,每个月花1小时看一次docker stats,审查资源使用是否合理。

18 分钟阅读 · 发布于: 2025年12月18日 · 修改于: 2026年2月5日

评论

使用 GitHub 账号登录后即可评论