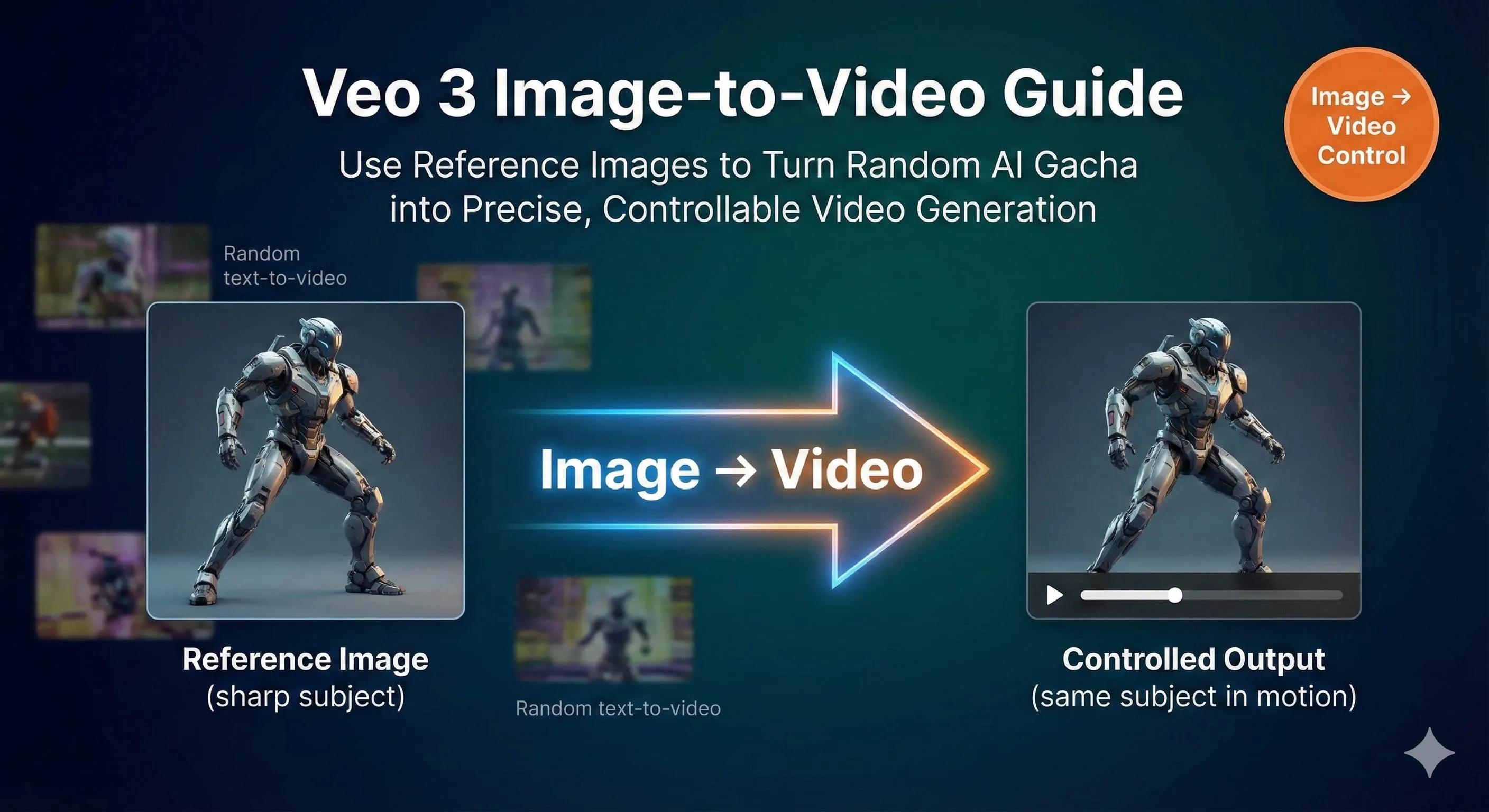

Veo 3 Image to Video実践:Reference Imageで動画効果を精密に制御する

午前1時、画面上の47番目のAI生成動画を見つめていました——ヒロインの顔がまた崩れています。今回は目が不揃いで、口角が妙に引きつっていて、まるでバグったゲームキャラクターのようです。プロンプトにははっきりと「優しく微笑む若い女性」と書いたのに、なぜAIはホラー映画のような効果を出してくるのでしょうか?

削除。やり直し。48回目。

正直なところ、これが純粋な「テキストから動画(Text-to-Video)」の日常です——終わりのない「ガチャ」。工夫を凝らした長いプロンプトを書き、期待を込めて30秒待ち、動画を開いた瞬間に心が折れます。表情がおかしい、動きが大きすぎる、カメラアングルが奇妙……99%の試行はゴミ箱行きです。毎回ブラインドボックスを開けるようなものですが、このボックスは特別高価です——時間コスト、計算リソース、そしてあなたの減りゆく髪の毛。

Veo 3の画像ガイド機能を見つけるまで、この悪夢は終わりませんでした。

今では参考画像を1枚アップロードして、AIに「この通りにやって」と伝えるだけで、2〜3回で満足のいく結果が得られます。「優しい微笑み」をAIがどう解釈するか推測する必要もなく、50回目で当たりを引くことを祈る必要もありません。この記事では、Veo 3の3つの画像ガイドモード——First Frame(最初のフレーム)、First & Last Frame(最初と最後のフレーム)、Reference Image(参照画像)——を詳しく解説し、既存の画像素材を使って動画効果を精密に制御し、「ガチャ」の回数を50回から5回以内に減らす方法をお教えします。

なぜ純粋なText to Videoは制御が難しいのか?

問題の根源は、実は言語そのものの曖昧さにあります。

「海辺をゆっくり歩く少女」と書いたとき、AIは何を読み取るでしょうか? 「ゆっくり」は秒速0.5メートルなのか1メートルなのか? 「歩く」はのんびり散歩なのか、物思いに耽りながらの歩行なのか? 「海辺」は岩場なのか、砂浜なのか、木の遊歩道なのか? 同じ10文字でも、100人いれば100通りの解釈があります。

AIも同じです。訓練データのパターンに基づいて、これらの詳細を自動的に補完します。問題は、その補完が往々にしてあなたの望むものではないということです。

特に印象に残っているのは、「振り向いて微笑む少女」のショットを生成しようとしたときのことです。簡単でしょう? しかしAIは十数個のバリエーションを生成してきました。保険のセールスマンのような笑顔、転びそうなほど大きな回転、完全に180度回転して背を向けてしまうもの……。すべてのバージョンが私の記述に「合致」していましたが、私の脳内のイメージと一致するものは一つもありませんでした。

これが純粋なText to Videoの最初の落とし穴:自然言語の曖昧性です。はっきり言ったつもりでも、実は至る所が曖昧なのです。

2つ目の落とし穴はさらに致命的です——AIの「創造的な発揮」は予測不可能。

AIは言及していない要素を勝手に追加します。「カフェに座っている人」を生成させると、謎の背景人物を追加したり、窓の外に奇妙な物体を漂わせたりします。人物の手の動きは頻繁に崩れます——指が6本あるのはよくあることで、腕がありえない角度に曲がることもあります。表情に至っては被害甚大で、瞬きするときに眼窩ごと変形することさえあります。

最も心が折れるのは、修正ができないことです。少しでも気に入らなければ、全てやり直しです。画像生成のようにインペインティングで部分修正することはできません。動画生成は「All or Nothing」——全面的に受け入れるか、削除してやり直すかです。

統計によると、純粋なText to Videoを使うクリエイターは、使える結果を得るために平均10〜50回の試行が必要です。毎回1分の待ち時間とすると、10〜50分の純粋な待ち時間になります。プロンプトを書いたりパラメータを調整したりする時間を含めれば、8秒の使える動画を作るのに1〜2時間かかることもあります。

これは創作ではありません。ギャンブルです。

しかし、画像ガイド機能の登場により、ついに私たちは制御権を取り戻すことができました。

Veo 3の3つの画像ガイドモード詳解

Veo 3は3つの異なる画像ガイドモードを提供しており、それぞれ異なる創作シナリオに適しています。一つずつ解説します。

モード1:First Frameモード(First Frame to Video)

これは最も直感的なモードです。画像を1枚アップロードすると、AIはそれを動画の最初のフレームとして使い、プロンプトに基づいて後続のアクションを生成します。

私がこのモードを最もよく使うのは何だと思いますか? 静止画イラストを動かすことです。

昨年、クライアントのためにブランド動画を制作した際、デザイナーが非常に精巧なシーンイラストを描いてくれました。カートゥーンスタイルのカフェで、暖色系の色調、細部まで描き込まれていました。クライアントはとても気に入ってくれましたが、雰囲気出すために動かしてほしいと言われました。以前ならこのような要望は基本的に無理でした。アニメーターに手描きを依頼するか(高い)、諦めるか(残念)のどちらかです。

今は? そのイラストをVeo 3のFirst Frameモードに直接アップロードし、プロンプトに「カメラがゆっくりと推進し、窓の外の木の葉が軽く揺れ、テーブルのコーヒーから湯気が立つ」と書くだけです。8秒の動画が一発で完成しました。重要なのは——そのカートゥーンスタイルが完璧に維持されたことです。ぎこちない補間アニメーションではなく、原画マンが手描きしたような動的効果でした。

これがFirst Frameモードの核心価値です:原画の画風を維持すること。

あなたの絵が水彩画、油絵、フラットなイラスト、あるいは写真であっても、Veo 3はアニメーション化しつつそのスタイルを維持できます。これはブランドのビジュアルガイドラインを持つクリエイターにとって救世主と言えます。

使用テクニック:

- 高画質な画像を選ぶこと。少なくとも1080p。ぼやけた画像からはぼやけた動画しか生まれません

- プロンプトで画像に既に存在するものを描写しないこと(「カフェ」など)。見たいアクションを描写すること(「カメラが推進、葉が揺れる」)

- 生成された動きが大きすぎたり小さすぎたりする場合は、プロンプトに “subtle movement”(微細な動き)や “dynamic motion”(ダイナミックな動き)を加える

モード2:First & Last Frameモード(First & Last Frame to Video)

これはより高度です。AIに同時に2枚の画像——開始と終了——を与え、AIがその中間の遷移を埋める責任を持ちます。

簡単そうに聞こえますが、この機能は恐ろしく強力です。

最も典型的な応用はカメラワークの制御です。例えば180度の回り込みショット——キャラクターの正面から背面まで撮りたいとします。以前はプロンプトに「カメラが時計回りに回転し、速度は均一で、高度を一定に保ち……」と長々と書く必要があり、AIが理解してくれる保証もありませんでした。今は2枚の画像をレンダリングするだけです:正面写真と背面写真。これらをFirst & Last Frameモードに放り込み、プロンプトに “smooth 180-degree arc shot”(スムーズな180度のアークショット)と書けば完了です。

もっとクレイジーなことも試しました——**物体の変形(モーフィング)**です。最初のフレームは実在の人物、最後のフレームはその人のカートゥーンキャラクター。AIは実在の人物が徐々に「カートゥーン化」する遷移動画を生成し、その変形プロセスは信じられないほど滑らかでした。

この機能を使ってブランドアニメーションを作る人もいます。最初のフレームはロゴA、最後のフレームはロゴB、中間の変形遷移はAIが自動生成。数十万円のモーショングラフィックス外注費が浮きました。

使用テクニック:

- 開始と終了フレームのスタイル、解像度は一致させるのがベストです。遷移がより自然になります

- 開始と終了の差が大きすぎる場合(例:昼から夜)、8秒の長さを選び、AIに表現の余地を与えましょう

- プロンプトでは「どう遷移するか」を描写します。単に開始と終了の画面を描写するだけではありません。例:“The camera performs a smooth dolly-in, gradually revealing more details”

モード3:Reference Imageモード(スタイルとキャラクターの一貫性)

個人的に一番好きなモードです。

前の2つのモードは「この動画がどう始まり/終わるか」を制御するのに対し、Reference Imageは「この人物/製品が動画全体でどう見えるか」を制御します。

最大3枚の参考画像をアップロードでき、同一主体の異なる角度を提示できます。そしてプロンプトでどんなシーン——海辺、カフェ、宇宙船——に登場させても、その主体の外見は一貫性を保ちます。

これはシリーズコンテンツを作るクリエイターにとって必須機能です。

ブランドマスコットのショート動画シリーズを10本作るとします。毎回違うシーンです。以前はどうしていましたか? 生成するたびに新しいキャラクターになり、シリーズ化は不可能でした。今はReference Imageを使えば、マスコットの3枚の標準写真(正面、側面、45度)をアップロードし、10個の異なるシーンの動画を生成しても、マスコットの顔、配色、比率は全て同じままです。

私はこの機能を使って製品展示動画を作ったことがあります。クライアントの製品はBluetoothスピーカーで、外見が少し特徴的でした。製品写真3枚をアップロードし、リビング、屋外、オフィス、ジム、キッチンという5つの異なるシーンの使用動画を生成しました。どの動画でもスピーカーの外見の細部は寸分違わず同じでした。クライアントはそれを見て即決し、実写の半分の予算で済んだと喜びました。

使用テクニック:

- 3枚の参考画像は異なる角度から主体を捉えたものがベスト(正面、側面、3/4アングル)

- 背景はシンプルに保ち、AIが背景要素に干渉されないようにする

- 生成された動画で主体が「漂流」した場合(色が変など)、最もぼやけている参考画像をより鮮明なものに差し替える

- 光源を統一する——ある画像は大太陽の下、別の画像は室内灯だと、AIは混乱します

これら3つのモードは排他的ではありません。高度な遊び方は組み合わせて使うことです。Reference Imageでキャラクターの一貫性を保証し、First & Last Frameでカメラワークを制御する。こうして生成された動画の制御性は90%以上に達します。

実践演習:画像から動画への完全なフロー

理論は終わりました。実践に移りましょう。ゼロから使える動画を生成するまでの完全なプロセスをご案内します。

ステップ1:適切なプラットフォームを選ぶ

Veo 3のフル機能は主にGoogle Flowというプラットフォームにあります。Geminiアプリでも使えますが、機能は制限されており、基本的なFirst Frameモードしかサポートしていません。First & Last FrameやReference Imageを使いたい場合は、Flowに行く必要があります。

アクセス方法:Flowにログイン後、prompt builderで “Frames to Video” を選択します。品質設定を必ず “Highest Quality” に変更してください。そうしないと古いバージョンのモデルが使われ、効果が大幅に落ちます。

ちなみに、Flowは現在地域制限があるかもしれません。アクセスできない場合でも、この記事で紹介する考え方やテクニックはRunway、Klingなどの他のプラットフォームにも同様に適用できます——核心ロジックはどれも「画像を使って生成をガイドする」ことです。

ステップ2:画像素材を準備する

このステップは多くの人が軽視しますが、実は非常に重要です。

画像の質が動画の質を直接決定します。私の基準は以下の通りです:

- 解像度:最低1080p、2Kならなお良し

- 構図:主体を中心または中心寄りに置く。端すぎると裁ち落とされる可能性があります

- 鮮明度:ぼやけさせない、ノイズを少なくする

- スタイルの統一:複数の参考画像を使う場合、光や色調が一致していることを確認する

実際の失敗例:一度手抜きをして、ネットから適当に拾った720p画像を使ったことがあります。結果、生成された動画は悲惨なものでした——粒子が粗く、細部は潰れていました。2K画像を探し直したところ、効果は一気に2段階上がりました。

ファイル形式はJPGまたはPNGで大丈夫です。私はJPGをよく使います。ファイルが小さくアップロードが早いからです。

ステップ3:Promptを書く(ここが重要)

画像と組み合わせて使うpromptは、純粋なText to Videoのpromptとは書き方が全く異なります。

核心原則:画像に既にあるものを描写せず、見たいアクションを描写する。

悪い例:

画像:海辺に立つ少女

Prompt:“A girl standing by the sea”(これじゃ意味がないでしょう?)

良い例:

画像:海辺に立つ少女

Prompt:“She turns towards the camera with a gentle smile, her hair flowing in the ocean breeze, golden hour backlight”

(彼女はカメラの方を向いて優しく微笑み、潮風に髪をなびかせている。ゴールデンアワーの逆光)

違いがわかりますか? 画像は「何であるか」を定義し、promptは「どう動くか」を定義します。

Promptの3つの必須要素:

-

カメラと動き(Camera & Motion)

- “handheld close-up”(手持ち特写)

- “slow dolly-in”(ゆっくりとドリーイン)

- “steady tracking left”(安定した左トラッキング)

- “locked-off”(固定カメラ、主体だけ動かしカメラは動かさない場合に適しています)

-

光と時間(Lighting & Time)

- “golden hour backlight”(ゴールデンアワーの逆光、暖かい雰囲気)

- “soft diffused light”(柔らかな拡散光、室内に適しています)

- “noir hard shadows”(フィルム・ノワール風の硬い影、ドラマチック感)

-

アクションと振る舞い(Action & Behavior)

- これが核心部分であり、具体的である必要があります

- 「微笑む」ではなく、「暖かく微笑み、目尻に笑みを浮かべる」と書く

- 「歩く」ではなく、「ゆっくりと前に歩き、足取りは軽く、時折足元を見る」と書く

First & Last Frameモードを使う場合、promptの構造を少し変える必要があります:

“The camera performs a smooth 180-degree arc shot, starting from the frontal view of the character and gradually circling around to end at the back view, maintaining consistent height and speed throughout the movement.”

(カメラは滑らかな180度のアークショットを行い、キャラクターの正面から始まり、徐々に背面に回り込んで終わる。移動中は一定の高さと速度を維持する)

重要なのは「どこからどこへ、どう遷移するか」をはっきりさせることです。

ステップ4:パラメータ設定

いくつかの重要なパラメータの選択:

- 長さ:8秒推奨。4秒は短すぎて動きが十分に展開せず、6秒は中途半端。8秒が丁度いいです

- 解像度:私は一般的に1080pを使います。720pは速いですが質が落ちます。時間があるなら1080pを試してみてください

- 生成数:一度に2〜4つのバリエーションを生成して比較しましょう。1つだけだと選択肢がありません

- Seed:再現可能な結果が欲しい場合(微調整が必要な場合など)、固定のSeed値(0〜4294967295の間で適当に選ぶ)を設定します。設定しないと毎回ランダムになります

バージョンの選択:

- Veo 3.1 Fast:生成が速く、Text to VideoとFirst & Last Frameをサポートしますが、Reference Imageは非対応です

- Veo 3.1 完全版:全機能をサポートし、最高品質ですが、少し遅いです

私の習慣は、初期テストではFastバージョンで高速に反復し、方向性が決まったら完全版で最終成果物を出力することです。

ステップ5:生成と問題のトラブルシューティング

生成をクリックし、30〜90秒待ちます。この間にコーヒーを淹れに行きましょう(冗談ではなく、私は本当に毎回そうしています)。

動画生成後、90%の確率で「悪くはないが、少し問題がある」という状態になります。慌てないでください、これは正常です。よくある問題と解決策:

問題1:主体が漂流または変形する

- 症状:人物の顔が徐々に変わる、または製品の色がずれる

- 原因:参考画像が鮮明でない、または数が足りない

- 解決:最もぼやけた参考画像を差し替える、または3枚目の別角度の画像を追加する

問題2:動きの感覚がおかしい

- 症状:動きが速すぎる/遅すぎる、または方向が意図と違う

- 原因:promptが明確でない

- 解決:具体的な動きの描写を加える。例:“slow and steady”(ゆっくりと安定した)、“quick but smooth”(素早いが滑らか)

問題3:スタイルが原画から外れる

- 症状:カートゥーン画像をアップしたのに、動画が写実的なスタイルになり始めた

- 原因:AIの「創造的な発揮」

- 解決:promptの最後に “maintaining the [original style] style” を追加する。例:“maintaining the watercolor painting style”(水彩画のスタイルを維持して)

問題4:首尾フレームの接続が不自然

- 症状:中間の遷移がぎこちなく、明らかなジャンプがある

- 原因:開始と終了のフレームの差が大きすぎる、または時間が短すぎる

- 解決:時間を8秒に設定してAIに余裕を持たせる、または開始と終了のフレームを調整して近づける

これらの問題に直面しても落ち込まないでください。2〜3回調整したとしても、純粋なText to Videoの50回よりはずっとマシです。しかも調整のたびに何を修正すべきかがわかっており、明確な最適化の方向性があります。当てずっぽうではありません。

これこそがImage to Videoの最大の利点——予測可能な反復作業です。

上級テクニック:Image to Videoをプロ級にする

基礎操作をマスターしたら、いくつかの高度な遊び方を話しましょう。これらは私が実戦で失敗しながらまとめたもので、動画の品質をさらに一段階引き上げます。

テクニック1:マルチクリップ接続で一貫性を保つ

単一の8秒動画では足りないことがよくありますよね? 長尺動画を作るには、複数のクリップを繋げる必要があります。

重要なテクニック:前の動画の最後のフレームを、次の動画の最初のフレームとして使う。

具体的な操作:最初の動画を生成した後、最後のフレームのスクリーンショットを撮り、それを2番目の動画のFirst Frameとしてアップロードします。これで2つの動画間の接続は滑らかになり、唐突なジャンプ感がなくなります。

Reference Imageと組み合わせるとさらに効果的です。全編通して同じ参考画像セットを使ってキャラクターの外見を維持し、First & Last Frameで各クリップのカメラ遷移を制御します。

私が手掛けた事例:歌手のパフォーマンス動画、5つのクリップ。観客視点、側面、背面、アップ、全景と順に切り替えました。各クリップはFirst & Last Frameでカメラ遷移を制御し、全編通して歌手の3枚の参考画像を使ってイメージを統一しました。最後に5つの動画を編集ソフトで繋げると、まるでワンカット撮影のように見えましたが、実際は5回別々に生成したものです。

テクニック2:スタイル転写(Style Transfer)の創造的応用

これはクールな遊び方です。ある視覚スタイルの画像を別のスタイルの動画に変換します。

最も一般的なのは実写写真からアニメスタイルへの変換です。実写写真をFirst Frameとしてアップロードし、promptに “anime style, cel-shaded, vibrant colors”(アニメスタイル、セルシェーディング、鮮やかな色)と書くと、生成される動画は実写から徐々にアニメ化していく効果になります。オープニングアニメーションやアート志向の短編に適しています。

逆も可能です:アニメ画像から実写スタイルへの変換。アニメキャラクターを「実写化」する動画を作るのに使っている人を見たことがありますが、かなり衝撃的です。

面白い応用例:素材スタイルの統一。出所の異なる画像がたくさんあるとします——写真、イラスト、3Dレンダリングなど、スタイルがバラバラです。これらを全てVeo 3に放り込み、統一されたスタイル記述で動画を生成すると、最終的に出力される動画のスタイルは統一されます。

テクニック3:完全なワークフロー統合

Image to Videoは制作プロセスの一環に過ぎません。完成品を作るには完全なパイプラインが必要です。

私自身のワークフローは以下の通りです:

-

前期:Midjourney/DALL-Eでコンセプトアートを生成

- 10〜20分かけて高品質なキーフレーム画像を生成

- このステップで素早く試行錯誤し、最も満足のいく構図とスタイルを見つける

-

中期:Veo 3で画像を動画に変換

- ニーズに合わせてFirst Frame、First & Last Frame、またはReference Imageモードを選択

- 通常2〜5回の反復で満足のいく結果が出る

-

後期:編集ソフトで繋ぎ合わせる

- Premiere/Final Cut/CapCutなど何でもOK

- カラーグレーディング、トランジション追加、リズム調整

- 重要:すべてのクリップの色調を統一し、繋ぎ目を自然にする

-

音声:AI音声ツールで吹き替え・BGM

- Suno/UdioでBGM生成

- ElevenLabs/Azure TTSでナレーション

- 適切な効果音を加える(Epidemic Soundなどのライブラリ)

このフローなら、1〜2分の高品質なショート動画を、今では2〜3時間で完成させられます。一年前なら、この品質の動画は外注(数万円〜)するか、自分で撮影(準備・撮影・編集で最低1週間)するしかありませんでした。

テクニック4:ビジネスシーンでの実戦応用

現実的な話、この機能でどう稼ぐか?

シナリオ1:製品展示動画

クライアントから製品写真をもらい、様々なシーンの使用動画を生成します。料金は本数ベースで、8秒動画1本5000〜10000円、1日に5〜10本制作可能です。

シナリオ2:ブランドマスコットシリーズ

Reference Imageでマスコットの外見を維持し、1シーズン分のシリーズショート動画を制作します。これはプロジェクト単位の課金に適しており、1シーズン10〜20話でまとまった金額になります。

シナリオ3:ソーシャルメディア・コンテンツマトリックス

クライアントのグラフィックデザイン、ポスター、製品写真をすべて動画バージョンに変換します。データによると動画コンテンツのエンゲージメント率は画像の3〜5倍高く、多くのブランドがこれにお金を払います。

シナリオ4:教育・トレーニング動画

教育用イラストをアニメーション化します。歴史的出来事、科学原理、製品使用チュートリアルなど。この市場は大きく、多くの教育機関や知識系インフルエンサーに需要があります。

私の周りにこれを専門にしている友人がいますが、主に中小ブランド向けにサービスを提供しています。Image to Videoをマスターしてから、納品が速く、コストが抑えられるため、顧客満足度が高く、業務量が3倍になったと言っていました。

小さなアドバイス:これを単なる技術作業だと思わないでください。クライアントが求めているのは「Veo 3で動画を作ること」ではなく、「マーケティング/拡散/コンテンツの問題を解決すること」です。彼らのビジネスニーズを理解し、適切な視覚的ソリューションを提示すること。技術はそのための手段に過ぎません。

コスト比較:Image to Video vs 純粋なText to Video

結局のところ、画像ガイドを使うとどれくらいの時間とお金が浮くのでしょうか? 計算してみましょう。

時間コスト比較

純粋なText to Video:

- 平均試行回数:10〜50回

- 1回の待ち時間:30〜120秒

- 総所要時間:5〜100分の純粋な待ち時間 + prompt作成・調整時間

- 実際の体験:午後の時間を使って、使える動画が1〜2本できるかどうか

Image to Video:

- 平均試行回数:2〜5回

- 1回の待ち時間:30〜120秒

- 総所要時間:1〜10分の純粋な待ち時間 + 画像準備時間

- 実際の体験:午後の時間で使える動画が5〜8本できる

時間節約:80-90%

特に明確な視覚的要求があるプロジェクト(ブランド動画、製品展示など)において、Image to Videoは圧倒的です。

計算コスト比較

プラットフォームがクレジットやポイント制で課金し、生成1回につき1単位消費すると仮定します:

- 純粋なText to Video:完成品まで10〜50単位

- Image to Video:完成品まで2〜5単位

コスト節約:80-90%

従量課金のAPIを使っている場合、この差はそのまま現金の差になります。1ヶ月で浮いたお金で、ツールをいくつか追加契約できるでしょう。

品質の安定性比較

これは数字では量れませんが、違いは明らかです:

純粋なText to Video:

- 結果は高度にランダム、くじ引きのよう

- 何が生成されるか予測不能

- 「自由奔放」なクリエイティブ探求に適している

Image to Video:

- 結果は安定して制御可能、最低ラインがある

- 大体の方向性を予測可能

- 明確な要件がある商業プロジェクトに適している

公式にリリースされ、ブランドイメージを代表するようなコンテンツにおいて、Image to Videoの方がリスクははるかに低いです。クライアントは「50回試したけど生成できませんでした」という言い訳を受け入れてくれません。

クリエイティブ資産の再利用価値

これはImage to Videoの隠れたメリットです。

以前デザイナーに依頼したイラスト、撮影した製品写真、制作した3Dレンダリングなど、これら全てを動画に変換して再利用できます。ハードディスクで眠っていた素材が、一気に新しい価値を持つのです。

コンテンツの蓄積があるクリエイターやブランドにとって、これは既存資産の活性化に等しいです。過去3年間のブログ画像をすべて掘り起こし、一括でショート動画に変換して、コンテンツマトリックスを一気に数倍に拡大した人を見たことがあります。

総勘定:もしあなたの仕事が動画コンテンツ制作に関わっているなら、Image to Videoスキルを習得することで効率は3〜5倍になり、コストは80%以上削減できます。これは大袈裟ではなく、私自身と数十人の同業者のリアルなデータです。

結論

長々と話しましたが、核心は一言です:画像ガイドはAI動画を「ブラインドボックス」から精密制御へと変える。

純粋なText to Videoがダメなわけではありません。自由奔放で、明確な視覚的予期がないクリエイティブな探求には適しています。しかし、どんな画面が欲しいかわかっている場合、あるいは手元に既存の画像素材がある場合、Image to Videoの効率と品質は純粋なText to Videoを圧倒します。

3つのモードにはそれぞれの用途があります:

- First Frameモード:静止画を動かし、スタイルを維持する

- First & Last Frameモード:カメラワークと遷移効果を精密に制御する

- Reference Imageモード:シリーズ動画で人物・製品の一貫性を保つ

これら3つのモードをマスターし、正しいpromptテクニックとパラメータ設定を組み合わせれば、あなたの「ガチャ」回数は50回から5回以内に減ります。

私のおすすめは、最もシンプルなFirst Frameモードから試すことです。お気に入りの写真やイラストを1枚見つけ、Veo 3(またはRunway、Klingなどのプラットフォーム)にアップロードし、シンプルな動作記述を書いて、効果を見てみましょう。一回でダメならpromptを調整するか画像を変えてみる。2〜3回やれば感覚が掴めます。

一度「生成結果が予想通り」という快感を味わったら、もう純粋なText to Videoには戻れません。

最後に一言:この記事のテクニックや考え方は、Veo 3だけに適用されるものではありません。Runway、Kling、Pikaなどの他のImage to Videoツールも、根本的なロジックは同じです——画像を使ってAIにより明確な指針を与え、曖昧さを減らし、制御性を高めることです。ですから、今Veo 3を使えなくても、これらの方法は依然として有効です。

さあ、試してみてください。あなたのハードディスクにはきっと良い画像が眠っているはずです。今すぐそれらを動かしてみましょう。

FAQ

Veo 3の3つの画像ガイドモードにはどのような違いがありますか?

• 画像を動画の最初のフレームとして使用

• 原画の芸術的スタイルを維持

First & Last Frameモード:

• 2枚の画像で開始と終了を制御

• AIが中間の遷移を埋める

• カメラワークの制御に適している

Reference Imageモード:

• 最大3枚の参考画像をアップロード

• シリーズ動画における人物や製品の外見の一貫性を保証

Image to VideoはText to Videoに比べてどれくらい時間を節約できますか?

• 平均試行回数が10-50回から2-5回に減少

• 時間を80-90%節約

効率比較:

• 純粋なText to Videoでは午後半日で使える動画が1-2本

• Image to Videoなら5-8本

画像ガイド機能を使ってキャラクターの一貫性を保つには?

1) 異なる角度(正面、側面、3/4アングル)から主体を捉えた参考画像を3枚アップロードする

2) 背景がシンプルで、光線が一致していることを確認する

3) シリーズ動画を生成する際、全編で同一の参考画像セットを使用することで、キャラクターの外見を寸分違わず維持できる

Promptを書く際の注意点は?

Promptに含めるべき3要素:

1) カメラと動き(例:slow dolly-in)

2) 光と時間(例:golden hour backlight)

3) アクションと振る舞い(具体的に、曖昧な記述は避ける)

複数の8秒動画クリップを繋げて長尺動画にする方法は?

1) 前の動画の最後のフレームを、次の動画の最初のフレームとして使用する

2) Reference Imageを併用してキャラクターの外見を維持する

3) 第一段落を生成後、最後のフレームをキャプチャし、第二段落のFirst Frameとしてアップロードする

4) このプロセスを繰り返す

5) 最後に編集ソフトで色調とトランジションを統一する

画像の品質は生成効果にどのような影響を与えますか?

推奨:

• 少なくとも1080p(2K推奨)の高画質画像を使用

• 主体を中心とした構図

• ノイズがなく鮮明であること

複数の参考画像を使う場合:

• 光線と色調が一致していることを確認する

注意:720pのぼやけた画像は、粒子が粗く細部がぼやけた動画になります

13 min read · 公開日: 2025年12月7日 · 更新日: 2026年3月3日

関連記事

プログラマー向けAIツール実践:OpenClaw + Claude Codeによる24時間自動バグ修正

プログラマー向けAIツール実践:OpenClaw + Claude Codeによる24時間自動バグ修正

第二の脳を構築する:OpenClawとObsidian/Notionのディープ・メモリー同期実践

第二の脳を構築する:OpenClawとObsidian/Notionのディープ・メモリー同期実践

警告!ClawHubスキルライブラリで800以上の悪意あるプラグインを発見。あなたのAPI Keyは本当に安全ですか?

コメント

GitHubアカウントでログインしてコメントできます