Veo 3角色一致性完整指南:用Scenebuilder制作连贯多镜头视频

说实话,我第一次用Veo 3生成多镜头视频的时候,差点把笔记本砸了。

你知道那种感觉吗?花了整整一个晚上,精心设计了5个镜头的短片脚本,满怀期待地一个个生成。结果呢?第一个镜头里的主角是黑短发、穿蓝色西装;第二个镜头突然变成了棕色长发、灰色卫衣;到了第三个镜头,整个人连脸型都变了,活脱脱变成了另一个人。

我盯着屏幕,心里只有一个念头:这特么不是在讲一个七胞胎的故事吧?

如果你也遇到过这个问题,恭喜你,你不是一个人。角色外观不一致,是AI视频生成最让人抓狂的痛点之一。但经过大量测试和研究,我找到了一套真正有效的方法。今天这篇文章,我会把所有经验和盘托出。

为什么AI视频总是”角色漂移”?

在讲解决方案之前,我们得先搞清楚:为什么AI视频里的角色总是变来变去?理解了这个,你才能对症下药。

AI其实有”失忆症”

这是最核心的问题。Veo 3、Runway,包括所有的AI视频生成模型,它们都有一个致命缺陷:没有长期记忆。

什么意思?就是说,你在第一个镜头里让AI生成了一个穿黑西装的男人,AI并不会记住这个角色的样子。当你生成第二个镜头的时候,对它来说这是一个全新的任务,就像和一个失忆症患者对话,每次都要重新介绍自己。

我刚开始用的时候,天真地以为AI会自动保持角色一致性。毕竟前一个镜头刚生成完,数据应该还在吧?后来才发现,我真是too young too simple。AI模型会把每个提示词当作独立任务处理,前后不会有任何关联。

文字描述天生就不精确

第二个问题出在我们的提示词上。

你想想,“一个穿黑色西装的男人”,这句话能对应多少种视觉结果?可以是30岁的,也可以是50岁的;可以是亚洲人,也可以是欧洲人;西装可以是意大利三件套,也可以是普通商务款。AI面对这么宽泛的描述,每次生成的结果自然会有差异。

就像你去餐厅点”一份炒饭”,不同厨师做出来的炒饭肯定不一样。想要味道一致,你得提供精确的配方——多少克米、几个鸡蛋、什么品牌的酱油、炒几分钟。AI也是一样,描述越详细,结果越稳定。

技术本身也有局限

还有一个原因是技术层面的。

早期的AI视频生成,其实是逐帧生成的。AI先生成第1帧,然后基于第1帧生成第2帧,再基于第2帧生成第3帧…每一帧都可能产生微小的偏差。这些偏差累积下来,到了视频结尾,角色可能已经面目全非了。

这就像我们小时候玩的传话游戏,第一个人说”今天天气真好”,传到最后一个人可能变成了”今天晚上吃宵夜”。

根据行业调研数据,在Runway Gen-4和Veo 3.1这些专门优化过角色一致性的模型推出之前,用户对AI视频角色一致性的满意度普遍只有3-4分(10分制)。这个问题有多普遍,可见一斑。

Veo 3的三大角色一致性武器

好在,Google和其他AI公司也意识到了这个问题。Veo 3专门开发了几个功能来解决角色一致性,效果确实立竿见影。根据Google Flow的官方数据,使用这些功能后,角色一致性可以提升60-70%。

让我一个个给你讲清楚。

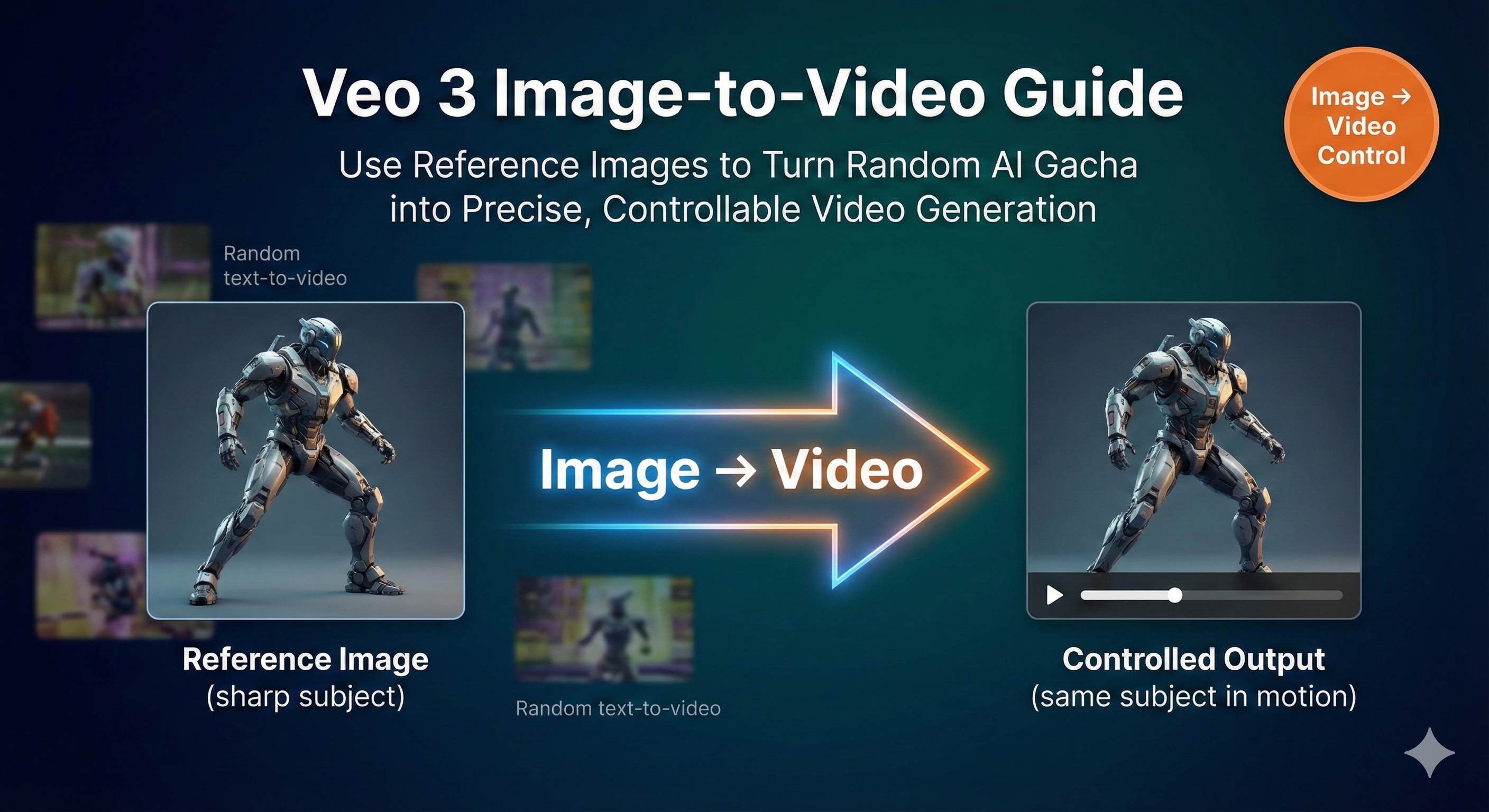

武器一:Reference Images(参考图片)

这是Veo 3.1标准版本独有的功能。简单说,就是你可以上传1-3张图片,告诉AI:“我要的角色就长这样,严格按这个来。”

AI会从你上传的图片中提取角色的关键特征——脸型、发型、肤色、五官比例等等,然后在生成视频的时候尽可能还原这些特征。

这个功能特别适合两种场景:

- 你要创作一个全新的虚构角色,需要从零开始定义外观

- 你想还原某个特定人物的样貌(比如历史人物、小说角色)

不过老实讲,这个功能也有限制。首先,它只在Standard模式可用,基础版的Veo 3用不了。其次,效果虽然好,但也不是100%完美复制,你还是得配合详细的文字描述。

我测试过几次,用真人照片作为参考图,AI生成的角色确实能抓住主要特征,但细节上还是会有出入。比如眼睛颜色可能稍微偏差,发型的蓬松度可能不太一样。但整体来说,已经比纯靠文字描述好太多了。

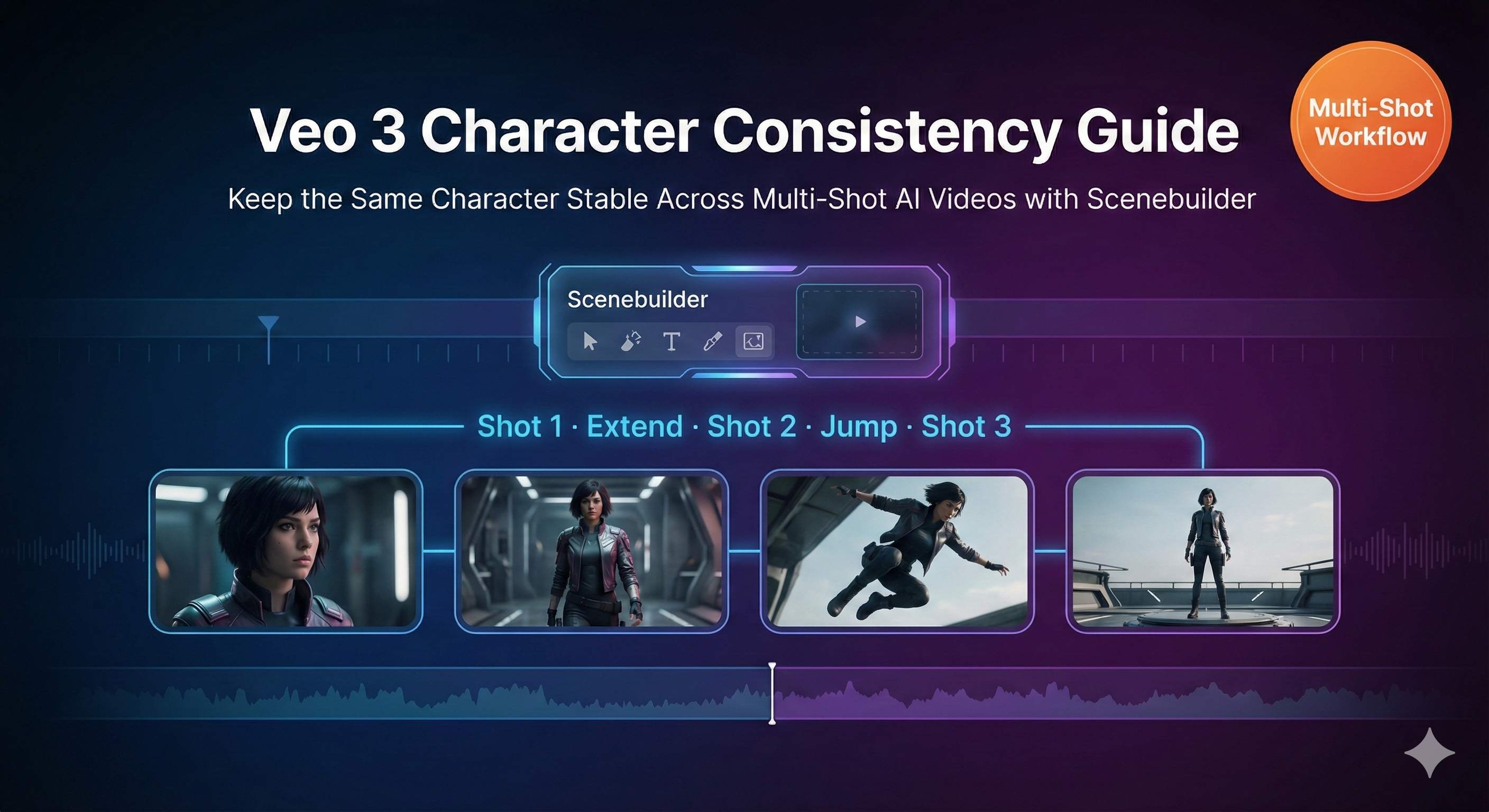

武器二:Scenebuilder(场景构建器)

这是我用得最多,也是最依赖的功能。可以说,Scenebuilder就是多镜头角色一致性的核心解决方案。

它的工作原理是:用上一个镜头的视觉信息,作为下一个镜头的参考。这就像给AI装了一个”短期记忆”,虽然不能记住所有历史,但至少能记住刚刚发生的事情。

Scenebuilder有几个关键功能:

“Add to Scene”(添加到场景)

当你生成了一个满意的镜头,点击这个按钮,视频就会被添加到一个时间线上。这个操作本质上是告诉AI:“记住这个角色的样子,后面我还要用。”

“Extend”(延续)

这是生成下一个镜头的主要方式。它会基于前一个镜头的视觉内容,生成自然衔接的后续画面。关键是,它会尽可能保持角色的外观不变。

“Jump to”(跳转)

如果你想来个硬切换——比如从室内场景切到室外——可以用这个功能。它会创建一个不连贯的剪辑切换,但仍然会尽量保持角色外观的一致性。

我第一次用Scenebuilder成功生成5个连贯镜头的时候,那种成就感真的难以言表。角色的服装、发型、面部特征基本都保持了一致,只有光照因为场景变化稍微有点差异,但完全在可接受范围内。

Google Flow的官方案例显示,使用Scenebuilder后角色一致性可以提升60-70%。换句话说,如果你之前10次生成只有3次满意,现在可以达到6-7次。这个提升是质的飞跃。

武器三:Ingredients to Video(元素生成视频)

这个功能更适合复杂场景,特别是多个角色同时出现的情况。

工作流程是这样的:

- 先用Gemini 2.5 Flash Image或其他工具,单独生成每个角色和场景元素的参考图

- 把这些”原料”(Ingredients)上传到Veo 3

- 用Ingredients to Video功能,让AI把这些元素合成到一个场景里

这样做的好处是,每个角色都有明确的视觉参考,AI不需要凭空想象。比如你要做一个两个人对话的场景,可以先分别生成A和B的角色立绘,然后用Ingredients功能合成对话镜头。

我自己用得不多,因为对于单主角的故事,Scenebuilder已经够用了。但如果你要做多角色互动的视频,Ingredients to Video绝对是最优选择。

实战操作:用Scenebuilder创建连贯视频

好,理论讲完了,咱们来点实际的。我会一步步带你走一遍完整流程,就算你是第一次用Veo 3,跟着做也能上手。

第零步:创建”角色圣经”

这一步经常被忽略,但其实是最重要的。

在你打开Veo 3之前,先花15-30分钟,写一个详细的角色描述文档,俗称”Character Bible”(角色圣经)。这个文档要包含:

- 基础信息:年龄、性别、种族

- 头发:长度、颜色、质地、发型(比如”肩膀长度的波浪卷黑发,中分,发尾微微外翘”)

- 面部:眼睛颜色、眉毛形状、鼻子特征、下巴轮廓、任何明显标记(痣、疤痕)

- 体型:身材、身高感觉、姿态特征

- 服装:每一件衣物的类型、颜色、材质、合身度、配饰

越详细越好。我的建议是写到100-150字。

举个例子:

一个28岁的亚洲女性,黑色长直发扎成低马尾,深棕色眼睛,眉毛略粗,小巧的鼻子,圆润的下巴。穿着白色纯棉T恤(微宽松,领口圆领),搭配深蓝色牛仔裤(修身款,裤脚挽起),脚穿白色帆布鞋。身材纤细但不瘦弱,站姿自信,略微抬头。左手手腕戴着银色细手表。

看到没有?这段描述足够具体,AI基本没什么发挥空间。这就是你要的效果。

其实很多人会觉得,这么详细会不会太麻烦?老实讲,是有点麻烦。但这15分钟的投入,能帮你省下3个小时的重复生成时间。这个账怎么算都划算。

第一步:生成基准镜头

打开Google Flow,选择Veo 3,把你的角色描述完整粘贴进去,然后加上第一个镜头的动作和场景。

比如:

[粘贴完整角色描述]。她站在咖啡店门口,推开玻璃门走进去。中景镜头,略微推进。柔和的自然光,温暖的下午色调。

点击生成。

这里有个关键:第一个镜头可能要试好几次。不要着急,也不要将就。因为第一个镜头是整个系列的基准,后面所有镜头都会以它为参照。如果第一个镜头的角色外观就不准确,后面全盘皆输。

我通常会生成3-5次,挑一个最满意的。检查这几个点:

- 面部特征符合描述吗?

- 服装细节正确吗?

- 整体风格符合预期吗?

- 画面质量够好吗?(构图、光照)

全都满意了,才进入下一步。

第二步:添加到场景

在满意的视频下方,你会看到几个按钮。点击**“Add to Scene”**。

这时候界面会切换到时间线视图,你刚才生成的视频会出现在时间线的第一个位置。恭喜,你的第一个镜头正式锁定了。

这个操作看起来简单,但它实际上做了一件很重要的事:告诉Veo 3的系统,“这是我的标准角色样子,记住它”。

第三步:添加新镜头

在时间线上,你会看到一个**”+“号**。点击它。

系统会弹出选项,问你想要什么样的镜头类型:

- Extend(延续):继续前一个镜头的动作和场景,自然衔接

- Jump to(跳转):切换到新场景,但保持角色外观

如果你的下一个镜头是紧接着的动作(比如她走进门后去柜台点单),选Extend。

如果你想直接跳到另一个场景(比如她已经坐下来喝咖啡了),选Jump to。

大部分情况下,我会选Extend,因为它的连贯性最好。

第四步:撰写新镜头的提示词

这一步是重中之重,也是最多人犯错的地方。

很多人在这里会图省事,简化提示词。比如写:“她走向柜台点咖啡。”

错!大错特错!

AI在处理新镜头时,虽然会参考上一个镜头的视觉信息,但你的文字描述依然是主要依据。如果你不提供完整的角色描述,AI可能会偏离原来的样子。

正确做法是:逐字复制粘贴完整的角色描述,然后只修改动作和场景部分。

继续上面的例子:

[粘贴完整角色描述,和第一个镜头一模一样]。她走向咖啡店的木质柜台,对着咖啡师微笑。镜头跟随,从侧面拍摄。保持柔和的自然光。

看到了吗?角色描述一个字都没变,只改了动作和镜头设定。

这就是所谓的”Verbatim Rule”(逐字规则)。有测试数据显示,使用完整描述和简化描述,最终的角色一致性差异可以达到40%。这个差别足以决定你的视频是”勉强能看”还是”专业级连贯”。

我知道这样做很繁琐。复制粘贴、复制粘贴、再复制粘贴…但没办法,这就是现阶段AI的技术限制。等哪天AI真的有了长期记忆,我们就不用这么麻烦了。但在那一天到来之前,老老实实按规矩来。

第五步:生成并检查

点击生成,等待30秒到2分钟。

视频生成后,立刻做对比检查:

- 发型还一致吗?

- 服装还是原来那套吗?

- 面部特征有明显偏差吗?

- 整体感觉还是同一个人吗?

如果一致性达到8分以上(10分制),恭喜,你可以接受这个镜头。

如果只有6-7分,有些细节不太对,但主要特征还在,你可以考虑接受,或者调整提示词重新生成。

如果只有5分以下,角色明显变样了,别犹豫,直接重新生成。注意,重新生成时不要改动角色描述,只调整场景或镜头设定的部分。

第六步:重复构建完整场景

继续用同样的方法添加第3、第4、第5个镜头。

每添加一个镜头,我建议你回头播放一遍整个序列,检查一下整体连贯性。因为有时候单个镜头看起来还行,但连起来放就会发现不对劲。

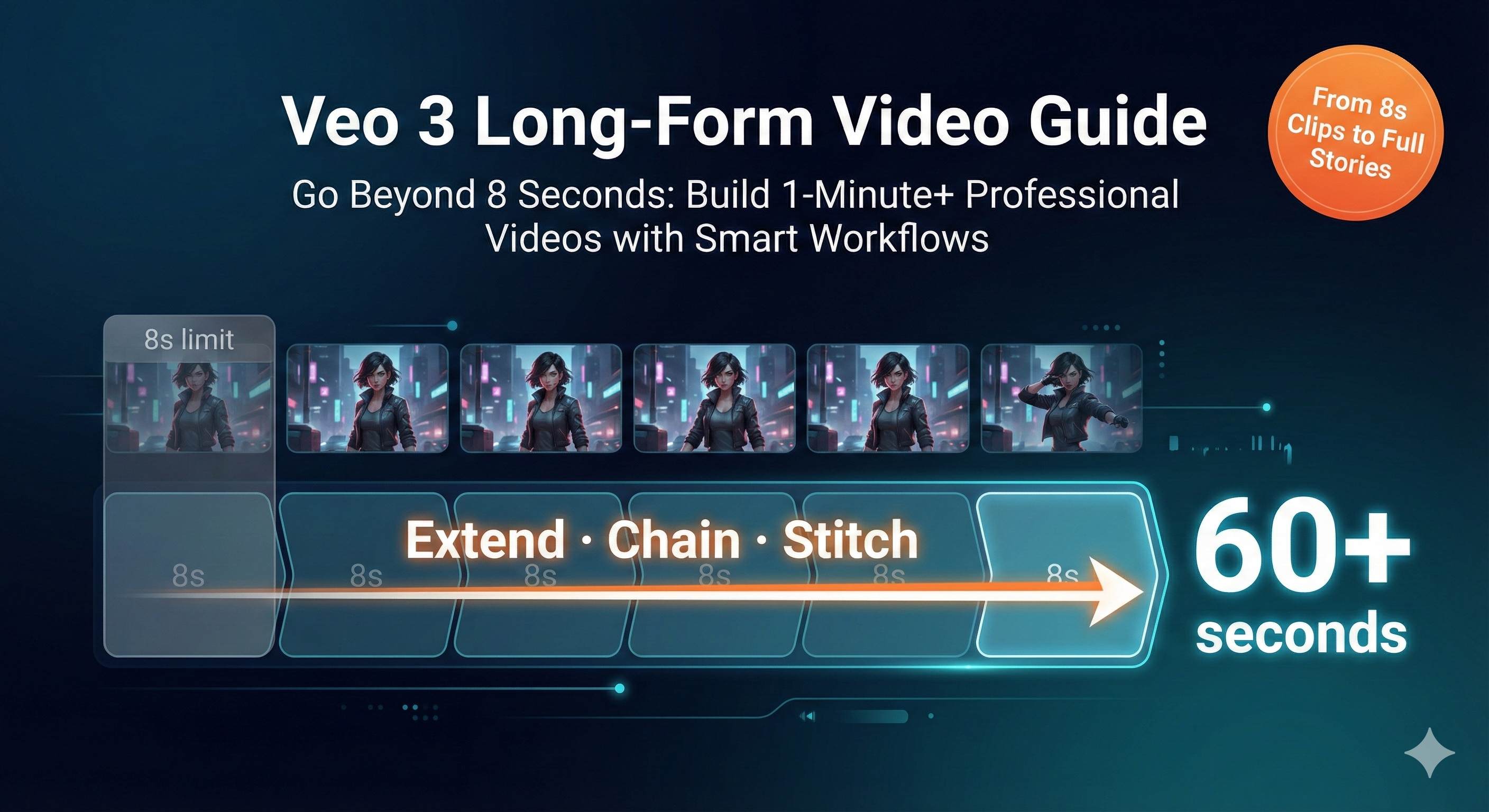

另外,不要一口气做太长。Veo 3的单个视频时长是5-8秒,做5-7个镜头(总共约30-50秒)就差不多了。太长的话,角色一致性会逐渐下降,而且会耗费大量时间和信用额度。

高级技巧(可选但推荐)

如果你想进一步提升一致性,可以试试这几个技巧:

1. 使用负面提示词

在角色描述后面,加一句”no hat, no glasses, no beard, no accessories”(如果你的角色本身就没有这些特征的话)。

这能防止AI随机添加一些你不想要的元素。我之前有一次,前面镜头角色都没戴眼镜,结果第4个镜头突然给他加了个墨镜,整个人气质都变了。后来加了负面提示词,这个问题就没再出现。

2. 保持光照一致

突然的光照变化会影响AI对角色的识别。比如从室内明亮场景突然跳到夜晚室外,AI可能会因为光线差异过大而改变角色外观。

如果必须换场景,尽量让光照条件相似,或者用过渡镜头缓冲。

3. 避免极端角度

俯视、仰视这种极端角度,会让AI难以识别面部特征,导致后续镜头失准。

前几个镜头尽量用平视或略微俯视的常规角度,等角色外观稳定了,再尝试特殊角度。

4. 建立提示词模板库

把你常用的角色描述保存在Notion、Google Docs或者任何笔记软件里。每次需要的时候直接复制,不要每次重新打字。

我自己建了一个模板库,里面有5-6个不同类型的角色(男性、女性、老人、儿童等),每次新项目就从里面挑一个改改。这能节省大量时间。

提示词管理和优化策略

聊完了Scenebuilder的操作,我们来谈谈提示词这个事儿。很多人觉得提示词就是随便写写,其实这里面学问大着呢。

提示词的基本结构

一个好的Veo 3提示词,应该包含这四个部分:

[角色完整描述] + [动作/场景] + [镜头运动] + [风格/氛围]

举几个具体例子:

示例1:简单场景

一个35岁的白人男性,短棕色头发略带灰白,蓝眼睛,胡子修剪整齐,穿着深蓝色西装配白衬衫和深红色领带,身材适中,姿态正式。他走在城市街道上,环顾四周。中景镜头,略微跟随。柔和的晨光,现代都市氛围。示例2:室内对话

一个28岁的亚洲女性,黑色长直发扎成低马尾,深棕色眼睛,穿着白色T恤配深蓝色牛仔裤,身材纤细,自信姿态。她坐在咖啡店的木桌前,对着镜头微笑,双手捧着咖啡杯。正面中近景,固定机位。温暖的室内光,咖啡馆背景虚化。示例3:动作场景

一个22岁的黑人男性,短卷发,深棕色眼睛,穿着灰色连帽卫衣和黑色运动裤,身材健壮,运动员姿态。他在公园里慢跑,步伐轻快。侧面跟拍,镜头跟随人物移动。清晨的自然光,公园绿树背景。看出规律了吗?角色部分永远是最详细的,动作和场景部分相对简洁,镜头和氛围部分起辅助作用。

角色描述的黄金法则

前面强调过很多次,但我还要再说一遍,因为太重要了:

每次生成新镜头,都要完整复制粘贴角色描述,一个字都不要改。

为什么这么严格?因为AI对语言的理解是概率性的,不是精确的。“白色T恤”和”白色的T恤”,对人类来说没区别,但对AI来说可能就是两个略微不同的输入,导致略微不同的输出。

这些微小的差异,在单个镜头里可能看不出来,但累积到5个、10个镜头,差异就会被放大。到最后,你会发现角色又”漂移”了。

所以,别偷懒,别改写,别简化。复制粘贴,原封不动。

根据用户测试数据,严格遵守”逐字规则”的创作者,角色一致性平均能达到8.5分(10分制);而随意改写提示词的创作者,平均只有5-6分。这个差距是决定性的。

场景连接的技巧

生成独立镜头不难,难的是让这些镜头自然衔接。

技巧1:保持环境连续性

如果前一个镜头是在咖啡店,下一个镜头突然跳到海滩,视觉割裂感会很强。AI也更容易搞混角色外观。

尽量让场景有逻辑关联。比如:咖啡店内→咖啡店门口→街道→公园。这种渐进式的场景变化,AI处理起来更稳定。

技巧2:用过渡镜头

如果必须做大场景切换,考虑加一个过渡镜头。

比如,从室内到室外,可以加一个”她推开门,阳光洒进来”的镜头。这样不仅视觉效果更好,AI的角色一致性也会更稳定。

技巧3:明确时间延续

在提示词里加上”继续…”、“然后…”这样的词,帮助AI理解这是一个连续动作。

错误示例:“她坐在桌前喝咖啡。“(突兀)

正确示例:“她走到桌前坐下,端起咖啡杯喝了一口。“(连贯)

我的个人模板库

分享几个我常用的模板,你可以直接拿去改:

模板1:现代都市男性

一个32岁的亚洲男性,黑色短发整齐向后梳,深棕色眼睛,轻微胡茬,穿着灰色针织毛衣配黑色休闲裤,身材匀称,放松但有气场的姿态。模板2:职场女性

一个29岁的白人女性,金褐色肩长波浪卷发,浅蓝色眼睛,穿着米色衬衫配深灰色西裤,脚穿黑色低跟鞋,身材纤细,专业自信的姿态。模板3:街头少年

一个19岁的拉丁裔男性,黑色中长发微卷,深棕色眼睛,穿着黑色图案T恤配蓝色破洞牛仔裤和白色运动鞋,身材瘦高,随性放松的姿态。你只需要把这些模板保存下来,用的时候根据你的故事需求稍微调整细节就行。比如把发型换一换、服装换一换,基础框架是可以复用的。

常见问题和实战解决方案

做了这么多视频,我踩过的坑基本都踩遍了。下面这些问题,可能也会是你会遇到的。

问题1:明明用了Scenebuilder,角色还是变了

症状:前两个镜头还挺一致,到第三第四个镜头开始走样,服装颜色变了,发型变了,甚至脸型都不太对了。

可能原因:

- 提示词有微小差异(比如你简化了角色描述)

- 光照或场景变化太大

- 镜头角度过于极端

解决方案:

首先,检查你的提示词。打开你用过的所有提示词,逐字对比角色描述部分。我保证你会发现差异——可能是”深蓝色西装”变成了”蓝色西装”,或者漏了某个细节。把描述统一,重新生成。

其次,回顾场景设置。如果第二个镜头是明亮的室内,第三个镜头突然跳到昏暗的夜晚街道,AI会因为光线差异搞混角色。解决办法是要么保持光照相似,要么在提示词里强调”保持相同的角色外观”。

最后,检查镜头角度。如果你用了极端的俯视或仰视角度,AI可能识别不准面部特征。前期尽量用常规角度,等角色外观稳定了再玩特殊角度。

我之前有个项目,角色在第4个镜头突然变了,检查半天才发现,原来那个镜头我用了超广角仰视,角色的脸被透视变形了,AI根本认不出来。后来改成平视角度,问题立刻解决。

问题2:我的Veo 3没有Reference Images功能

症状:看教程说可以上传参考图片,但你的界面里找不到这个选项。

原因:Reference Images是Veo 3.1 Standard模式的独占功能。如果你用的是基础版或者旧版本,就没有这个功能。

解决方案:

升级到AI Ultra订阅计划。老实讲,这个计划不便宜,每个月$250。但如果你是认真做AI视频创作的,这个投资是值得的。Standard模式的生成质量、速度和功能都比基础版好很多。

如果暂时不想升级,也没关系。Reference Images不是必须的,Scenebuilder加上详细的文字描述,已经能达到不错的一致性了。我自己有大半项目都没用Reference Images,照样做出了连贯的视频。

另一个替代方案是,用其他工具(比如Midjourney、Stable Diffusion)先生成一张角色立绘,然后根据这张图写一个超级详细的文字描述,再用这个描述去生成视频。效果虽然不如直接上传图片,但也比纯文字要好。

问题3:生成速度慢,成本太高

症状:每个镜头生成要1-2分钟,一个5镜头的项目要反复试错,一晚上只能搞定一个,还烧了一堆信用额度。

现实check:是的,这就是现状。AI视频生成目前就是慢,就是贵,这不是你的问题,这是技术发展阶段的限制。

但你可以优化工作流程:

策略1:充分准备再动手

不要打开Veo 3就开始生成。先花1小时把脚本、角色描述、每个镜头的提示词全部准备好,检查无误,再开始生成。盲目试错是最浪费时间和成本的。

我现在的习惯是,在Notion里先把整个项目规划好,包括5-7个镜头的完整提示词,都写在一个文档里。然后一次性复制粘贴去生成,减少临时修改和反复调整。

策略2:用低成本工具做准备

在用Veo 3之前,先用免费或便宜的工具做角色设计。

比如,用Whisk(Google的免费工具)生成角色立绘,用Leonardo.ai或Ideogram生成场景参考图。把角色外观视觉化并锁定,再去Veo 3做动画,成功率会高很多。

策略3:只生成关键镜头

不是每个镜头都要用Veo 3生成。一些不重要的过渡镜头、远景镜头,可以用更便宜的工具(比如Pika、Runway的基础版)生成,或者干脆用真实素材。

只把预算花在真正需要角色特写、重要动作的镜头上。

我之前做一个项目,7个镜头里有3个是角色特写,2个是中景对话,2个是环境远景。前5个我用Veo 3精心制作,后2个直接用了免费的Pexels视频素材。最后剪出来,完全看不出违和感,但成本省了一半。

问题4:多个角色同时出现更难搞

挑战:你的故事里有两个主角,甚至三个,要让所有人都保持一致,简直是地狱难度。

为什么这么难:

每个角色都需要详细描述,提示词会变得超级长。Veo 3的提示词是有长度限制的,太长会被截断。而且,角色越多,AI越容易搞混,张冠李戴。

解决方案:

优先级排序

明确主次。如果有一个主角和一个配角,把80%的精力花在主角身上,配角的一致性要求可以放宽一些。观众的注意力主要在主角,配角稍微有点偏差,大部分人不会注意。

使用Ingredients to Video

这是多角色场景的最佳工具。先单独生成每个角色的参考图(可以用Gemini 2.5 Flash Image或Midjourney),然后用Ingredients功能合成。这样每个角色都有明确的视觉锚点,AI不容易搞混。

分镜头拍摄

尽量避免多个角色同时出现在一个镜头里。用蒙太奇手法,A说话的时候拍A的特写,B回应的时候切到B的特写。这样每个镜头只处理一个角色,一致性问题立刻减半。

我看过一个很聪明的案例,创作者做了一个两人对话的短片,但全程没有一个镜头同时拍到两个人,全是单人特写切来切去,配合画外音。观众完全感觉不到这是技术限制,反而觉得这种剪辑节奏很专业。

写在最后

说了这么多,我想聊几句实话。

角色一致性确实是AI视频生成的最大挑战之一,即使用了Scenebuilder、Reference Images这些工具,也不可能做到100%完美。你还是会遇到失败的生成,还是会需要反复重试,还是会偶尔抓狂。

但是,通过系统化的方法——详细的角色圣经、严格的提示词管理、Scenebuilder的正确使用——你绝对能把一致性从3分提升到8分。这个差距,足以让你的作品从”看起来是AI生成的”变成”看起来像专业制作的”。

我自己从一开始的手忙脚乱,到现在能稳定产出连贯的多镜头视频,大概花了两周时间和上百次生成测试。如果你能从我的经验里学到一些东西,少走一些弯路,那这篇文章就值了。

最后,给你一个行动建议:从小项目开始。

不要一上来就想做10分钟的短片。先做一个2-3个镜头的超短场景,就当练手。熟悉流程,建立信心,积累模板。等你能稳定做出3个一致的镜头,再扩展到5个、7个。

罗马不是一天建成的,技能也不是一次就练成的。

好了,教程到这里。打开你的Google Flow,创建你的第一个角色圣经,开始尝试吧。如果有什么问题或者成功案例,欢迎在评论区分享。我也很想看看你做出了什么作品。

祝你生成顺利,角色如一。

发布于: 2025年12月7日 · 修改于: 2025年12月15日

评论

使用 GitHub 账号登录后即可评论