Veo 3图生视频实战:用Reference Image精准控制视频效果

凌晨一点,我盯着屏幕上第47个AI生成的视频——女主角的脸又崩了。这次她的眼睛一大一小,嘴角莫名其妙地抽搐,像是卡了bug的游戏角色。我在prompt里明明写了”温柔微笑的年轻女性”,为什么AI偏要给我生成个恐怖片效果?

删掉。重来。第48次。

说实话,这就是纯文生视频的日常——无休止的”抽卡”。你写了一大段精心设计的提示词,满怀期待等待30秒,结果打开视频的瞬间,心凉了半截。人物表情不对、动作幅度太大、镜头角度诡异…99%的尝试都是废品。每次都像开盲盒,只是这个盲盒特别贵——时间成本、算力成本,还有你日渐稀疏的头发。

直到我发现Veo 3的图片引导功能,这个噩梦才终于结束。

现在我只需要上传一张参考图片,告诉AI”就按这个来”,2-3次就能出满意的结果。不用再猜AI会怎么理解”温柔微笑”,不用再祈祷第50次能中奖。这篇文章,我会详细拆解Veo 3的三种图片引导模式——首帧、首尾帧、reference image,教你怎么用现有的图片素材精准控制视频效果,把”抽卡”次数从50次降到5次以内。

为什么纯文生视频这么难控制?

问题的根源,其实在于语言本身的模糊性。

当你写”一个女孩在海边缓慢行走”,AI读到的是什么?“缓慢”是每秒移动0.5米还是1米?“行走”是悠闲散步还是若有所思地踱步?“海边”是礁石区、沙滩还是木栈道?同样的七个字,100个人能有100种不同的理解。

AI也一样。它会根据训练数据里的模式,自动补充这些细节。问题是,它补充的往往不是你想要的。

我印象特别深的一次,我想生成一个”女孩转身微笑”的镜头。很简单对吧?结果AI给我生成了十几个版本:有的笑得像推销保险的,有的转身幅度大得像要摔倒,还有的干脆转了180度变成背对镜头。每个版本都”符合”我的描述,但没有一个是我脑子里想的那个画面。

这就是纯文生视频的第一个坑:自然语言的歧义性。你以为说清楚了,其实到处都是模糊地带。

第二个坑更要命——AI的”创造性发挥”不可预测。

它会自动添加你没提到的元素。你让它生成”一个人坐在咖啡馆”,它可能给你加上莫名其妙的背景人物,或者窗外飘过奇怪的物体。人物的手部动作经常失真——六根手指算是常见操作,手臂扭曲成不可能的角度也时有发生。脸部表情更是重灾区,眨眼的时候整个眼眶都在变形。

最崩溃的是,你没法修改。一点不满意就得全部重来。不像图片生成,你还能用inpainting局部修复。视频生成是all or nothing——要么全盘接受,要么删掉重来。

有人统计过,用纯文生视频的创作者,平均需要尝试10到50次才能得到可用的结果。按每次等待1分钟算,那就是10到50分钟的纯等待时间。如果算上写prompt、调参数的时间,一个8秒的可用视频可能要花掉你一两个小时。

这不是创作,这是赌博。

而图片引导功能的出现,终于让我们能够把控制权拿回来。

Veo 3的三种图片引导模式详解

Veo 3提供了三种不同的图片引导模式,每种适用于不同的创作场景。我一个个讲。

模式一:首帧模式(First Frame to Video)

这是最直观的一种。你上传一张图片,AI就把它作为视频的第一帧,然后根据你的prompt生成后续动作。

我最常用这个模式干什么?把静态插画动起来。

去年给客户做品牌视频,设计师画了一套超精美的场景插画——卡通风格的咖啡馆,暖黄色调,细节满满。客户看了很喜欢,但希望能动起来,增加氛围感。以前这种需求基本没戏,要么找动画师手绘(贵),要么放弃(遗憾)。

现在?我直接把那张插画上传到Veo 3的首帧模式,prompt写”镜头缓慢推进,窗外树叶轻轻摆动,桌上的咖啡冒着热气”。8秒钟的视频,一次过。重点是——那个卡通风格完美保留了。不是那种生硬的插值动画,而是真的像原画师亲自画出来的动态效果。

这就是首帧模式的核心价值:保持原图的艺术风格。

不管你的图是水彩画、油画、扁平插画还是摄影照片,Veo 3都能在动画化的同时保持那个风格。这对于有品牌视觉规范的创作者来说,简直是救星。

使用技巧:

- 选高清图片,至少1080p。模糊的图生成出来也模糊

- prompt别描述图片里已经有的东西(“一个咖啡馆”),要描述你想看到的动作(“镜头推进,树叶摆动”)

- 如果生成的动作幅度太大或太小,在prompt里加”subtle movement”(细微动作)或”dynamic motion”(动态运动)

模式二:首尾帧模式(First & Last Frame to Video)

这个更进阶。你同时给AI两张图——一张开头,一张结尾,它负责填充中间的过渡。

听起来简单,实际上这功能强大得可怕。

最经典的应用是镜头运动。比如你想要一个180度环绕镜头——从角色正面拍到背面。以前你得在prompt里写一大堆”相机顺时针旋转,速度均匀,高度保持不变…”,AI还不一定听得懂。现在你只需要渲染两张图:一张正面照,一张背面照,丢给首尾帧模式,prompt里写”smooth 180-degree arc shot”(平滑的180度弧形镜头),搞定。

我试过更疯狂的——物体变形。首帧是一个真人,尾帧是那个人的卡通形象。AI会生成真人逐渐”卡通化”的过渡视频,那个变形过程丝滑得不可思议。

还有人用这个功能做品牌动画:首帧是logo A,尾帧是logo B,中间的变形过渡由AI自动生成。省了几千块的动效外包费。

使用技巧:

- 首尾帧的风格、分辨率最好一致,这样过渡更自然

- 如果首尾帧差异太大(比如白天到黑夜),选8秒时长,给AI更多空间发挥

- prompt要描述”如何过渡”,不只是描述首尾画面。比如”The camera performs a smooth dolly-in, gradually revealing more details”

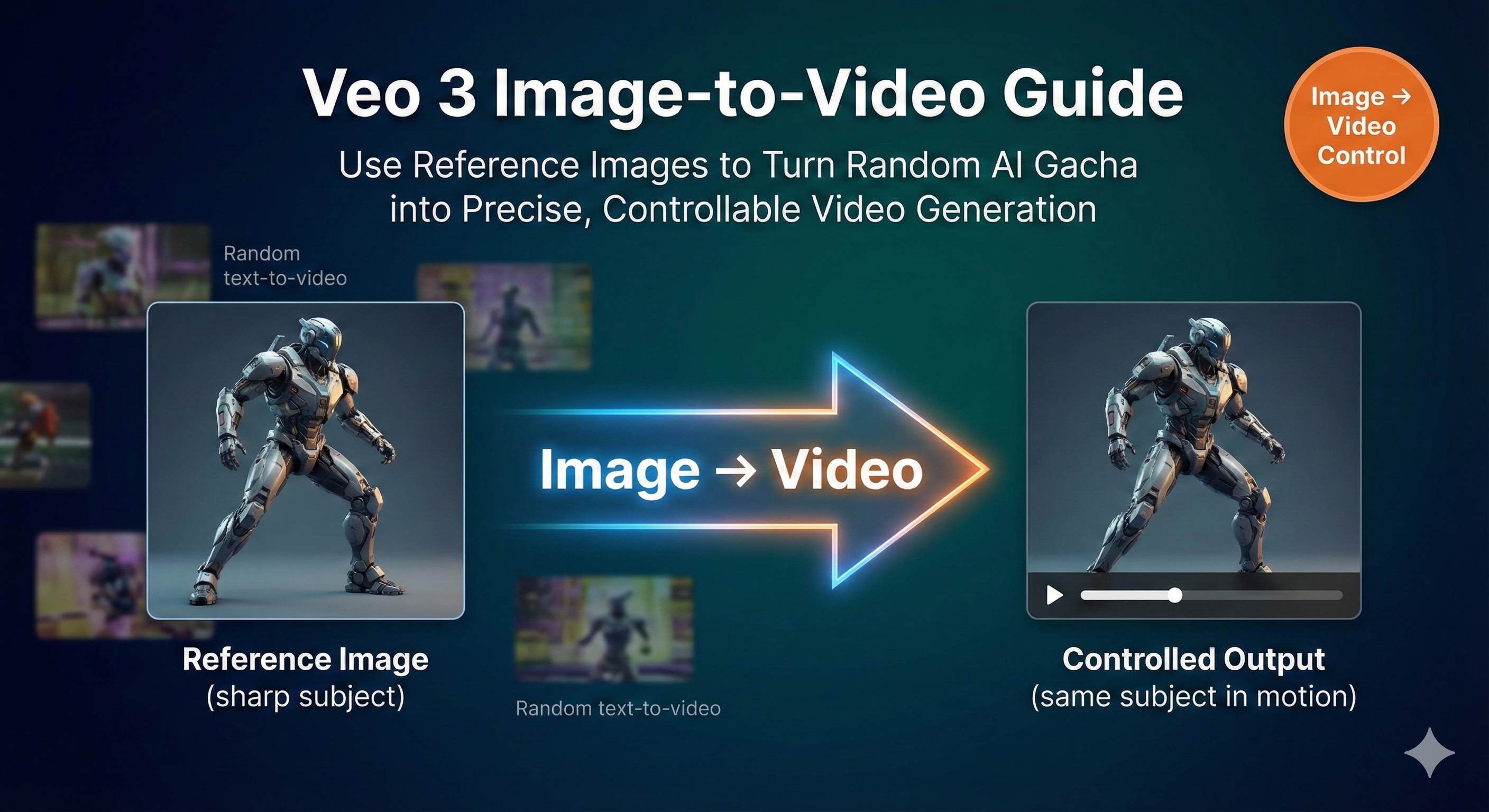

模式三:Reference Image(风格和角色一致性)

这个是我个人最爱。

前两个模式控制的是”这个视频怎么开始/结束”,Reference Image控制的是”这个人物/产品在整个视频里长什么样”。

你最多可以上传3张参考图,展示同一个主体的不同角度。然后不管你在prompt里让它出现在什么场景——海边、咖啡馆、太空飞船——那个主体的外观都会保持一致。

这对做系列内容的创作者来说是刚需。

假设你在做一个品牌吉祥物的系列短视频,10集,每集不同场景。以前怎么办?每次生成都是新角色,压根做不了系列。现在用Reference Image,上传吉祥物的3张标准照(正面、侧面、45度角),然后生成10个不同场景的视频,吉祥物的长相、配色、比例全都一模一样。

我用这个功能做过产品展示视频。客户的产品是一款蓝牙音箱,外观有点特别。我上传了3张产品照,然后生成了5个不同场景的使用视频——客厅、户外、办公室、健身房、厨房。每个视频里,那个音箱的外观细节都分毫不差。客户看了直接拍板,说比实拍省了一半预算。

使用技巧:

- 3张参考图最好从不同角度展示主体(正面、侧面、3/4视角)

- 背景保持简单,别让AI被背景元素干扰

- 如果生成的视频里主体”漂移”了(比如颜色变了),换掉最模糊的那张参考图,用更清晰的

- 光线要一致——别一张大太阳一张室内灯光,AI会confused

这三种模式不是互斥的。高级玩法是组合使用:用Reference Image保证角色一致性,再用首尾帧控制镜头运动。这样生成的视频,可控性能达到90%以上。

实战演练:从图片到视频的完整流程

理论讲完了,来点实际的。我带你走一遍完整流程,从零开始生成一个可用的视频。

第一步:选对平台

Veo 3的完整功能主要在Google Flow这个平台上。Gemini App也能用,但功能是阉割版,只支持基础的首帧模式。如果你想用首尾帧或Reference Image,必须去Flow。

访问方式:登录Flow后,在prompt builder里选”Frames to Video”。注意一定要把质量设置改成”Highest Quality”,不然用的是老版本模型,效果差很多。

对了,Flow目前可能有地区限制。如果你访问不了,本文介绍的思路和技巧同样适用于Runway、Kling等其他平台——核心逻辑都是”用图片指导生成”。

第二步:准备图片素材

这一步很多人都忽略,其实很关键。

图片质量直接决定视频质量。我的标准是:

- 分辨率:最低1080p,能到2K更好

- 构图:主体居中或偏中,别太靠边(可能被裁掉)

- 清晰度:别糊,别噪点太多

- 风格统一:如果用多张参考图,确保它们光线、色调一致

实际案例:我有次偷懒,用了一张从网上随便下的720p图片,结果生成的视频惨不忍睹——颗粒感重,细节全糊成一团。重新找了张2K图,效果立刻上了两个档次。

文件格式JPG或PNG都行,我一般用JPG,文件小传得快。

第三步:写Prompt(重点来了)

配合图片使用的prompt,和纯文生视频的prompt写法完全不同。

核心原则:别描述图片里已经有的东西,要描述你想看到的动作。

错误示例:

图片:一个女孩站在海边

Prompt:“A girl standing by the sea”(这不是废话吗?)

正确示例:

图片:一个女孩站在海边

Prompt:“She turns towards the camera with a gentle smile, her hair flowing in the ocean breeze, golden hour backlight”

(她转向镜头露出温柔的微笑,头发在海风中飘动,黄金时刻背光)

看到区别了吗?图片定义了”是什么”,prompt定义了”怎么动”。

Prompt的三个必备元素:

镜头和运动(Camera & Motion)

- “handheld close-up”(手持特写)

- “slow dolly-in”(缓慢推镜头)

- “steady tracking left”(稳定左移)

- “locked-off”(固定机位,适合只想要主体动,镜头不动的情况)

光线和时间(Lighting & Time)

- “golden hour backlight”(黄金时刻背光,温暖氛围)

- “soft diffused light”(柔和散射光,适合室内)

- “noir hard shadows”(黑色电影风格硬阴影,戏剧感)

动作和行为(Action & Behavior)

- 这是最核心的部分,要具体

- 别写”微笑”,写”露出温暖的微笑,眼角带着笑意”

- 别写”走”,写”缓慢向前走,步伐轻盈,偶尔低头看路”

如果你用的是首尾帧模式,prompt结构要变一下:

“The camera performs a smooth 180-degree arc shot, starting from the frontal view of the character and gradually circling around to end at the back view, maintaining consistent height and speed throughout the movement.”

(相机执行平滑的180度弧形镜头,从角色正面开始,逐渐环绕到背面结束,全程保持一致的高度和速度)

重点是要说清楚”从哪到哪,怎么过渡”。

第四步:设置参数

几个关键参数的选择:

- 时长:首选8秒。4秒太短动作不够舒展,6秒有点尴尬,8秒刚好

- 分辨率:我一般用1080p。720p快一点但质量有损失;如果你时间充裕,可以试试1080p

- 生成数量:一次生成2-4个variant对比,别只生成1个,给自己多点选择空间

- Seed:如果你想要可重复的结果(比如需要多次微调),设一个固定seed值(0到4294967295之间随便选)。不设的话每次都是随机的

版本选择:

- Veo 3.1 Fast:生成快,支持文生视频和首尾帧,但不支持Reference Image

- Veo 3.1 完整版:支持所有功能,质量最高,就是慢一点

我自己的习惯是初期测试用Fast版本快速迭代,确定方向后用完整版出最终成品。

第五步:生成并排查问题

点击生成,等30-90秒。这段时间你可以去倒杯咖啡(不是玩笑,我真的每次都这么干)。

视频生成后,90%的情况是:还不错,但有点小问题。别慌,这很正常。常见问题和解决方案:

问题1:主体漂移或变形

- 表现:人物的脸逐渐变样,或者产品颜色偏离

- 原因:参考图不够清晰或数量不足

- 解决:换掉最模糊的参考图,或者加第三张不同角度的图

问题2:运动感觉不对

- 表现:动作太快/太慢,或者方向不是你想要的

- 原因:prompt不够明确

- 解决:加上具体的运动描述词,比如”slow and steady”(缓慢稳定)、“quick but smooth”(快速但流畅)

问题3:风格偏离原图

- 表现:明明上传的是卡通图,生成的视频开始往写实风格走

- 原因:AI的”创造性发挥”又来了

- 解决:在prompt末尾加”maintaining the [original style] style”,比如”maintaining the watercolor painting style”(保持水彩画风格)

问题4:首尾帧衔接不自然

- 表现:中间过渡很生硬,有明显的跳跃感

- 原因:首尾帧差异太大,或者时长太短

- 解决:把时长调到8秒,给AI更多发挥空间;或者调整首尾帧让它们更接近一点

遇到这些问题别灰心。记住,即使调整2-3次,也比纯文生视频的50次强得多。而且每次调整你都知道自己在改什么,有明确的优化方向,不是瞎猜。

这就是图生视频的最大优势——可预测的迭代。

进阶技巧:让图生视频效果更专业

掌握基础操作后,来聊聊一些高级玩法。这些是我实战踩坑总结出来的,能让你的视频质量再上一个台阶。

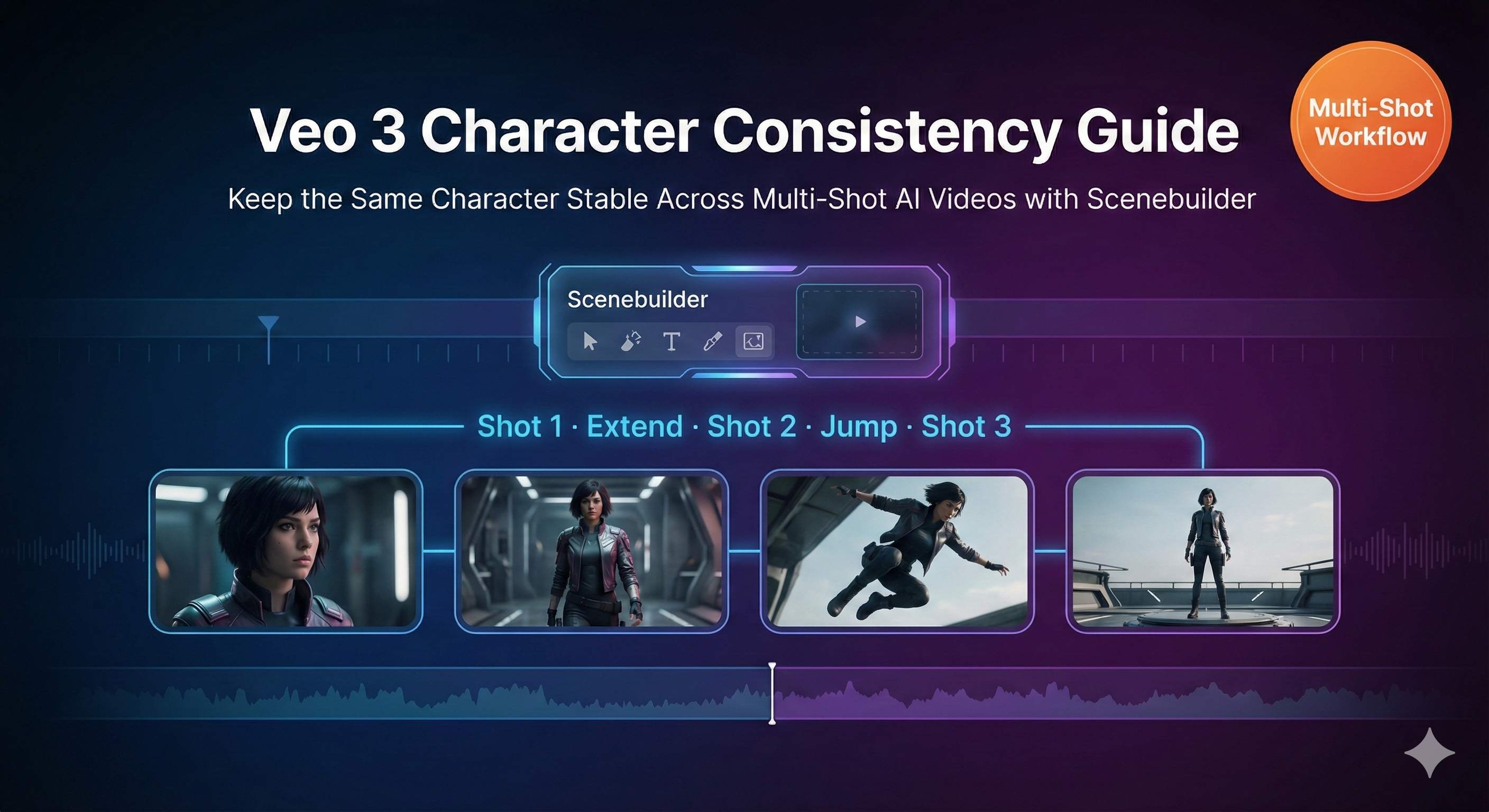

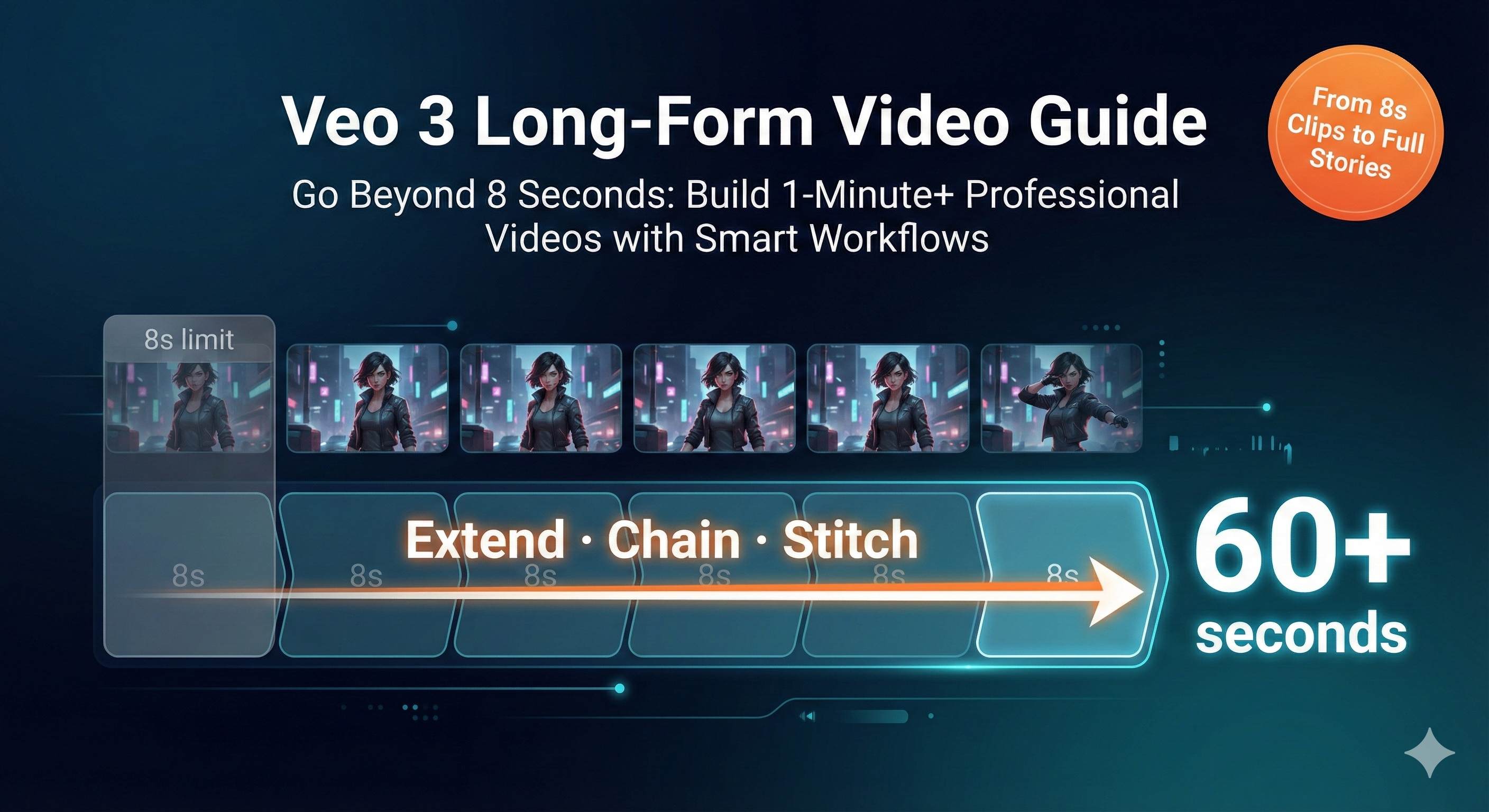

技巧一:多片段连接保持一致性

单个8秒视频经常不够用对吧?想做长视频,就得把多个片段连起来。

关键技巧:用前一个视频的最后一帧作为下一个视频的首帧。

具体操作:生成第一段视频后,截取最后一帧的截图,作为第二段视频的首帧上传。这样两段视频之间的衔接就丝滑了,不会有突兀的跳跃感。

配合Reference Image效果更好。你可以全程用同一组参考图保持角色外观一致,然后通过首尾帧控制不同片段的镜头运动。

我做过一个案例:歌手表演视频,5个片段,从观众视角、侧面、背后、特写、全景依次切换。每个片段用首尾帧控制镜头过渡,全程用3张歌手的参考图保持形象统一。最后把5段视频在剪辑软件里一拼,看起来就像一镜到底,实际上是5次分别生成的。

技巧二:风格迁移的创意应用

这个玩法很酷:把一种视觉风格的图片转成另一种风格的视频。

最常见的是真人照片转动漫风格。上传一张真人照片作为首帧,在prompt里写”anime style, cel-shaded, vibrant colors”(动漫风格、赛璐璐着色、鲜艳色彩),生成的视频会逐渐从真人过渡到动漫化效果。适合做开场动画或者艺术向的短片。

反过来也行:动漫图转真人风格。我见过有人用这个功能给动漫角色做”真人化”视频,效果挺震撼的。

还有个有意思的应用:统一素材风格。假设你有一堆不同来源的图片——有照片、有插画、有3D渲染图,视觉风格乱七八糟。全部丢给Veo 3,用统一的风格描述词生成视频,最后输出的视频风格就统一了。

技巧三:完整工作流整合

图生视频只是整个创作流程的一环。要做出成品,你需要一套完整的pipeline。

我自己的工作流是这样的:

前期:Midjourney/DALL-E生成概念图

- 花10-20分钟生成一组高质量的关键帧图片

- 这一步可以快速试错,找到最满意的构图和风格

中期:Veo 3将图片转视频

- 根据需求选择首帧、首尾帧或Reference Image模式

- 一般2-5次迭代就能出满意结果

后期:剪辑软件拼接打磨

- Premiere/Final Cut/剪映都行

- 调色、加转场、调整节奏

- 重要:统一所有片段的色调,让拼接后看起来更自然

音频:AI音频工具配音配乐

- Suno/Udio生成背景音乐

- ElevenLabs/Azure TTS做配音

- 加上适当的音效(Epidemic Sound之类的音效库)

这套流程下来,一个1-2分钟的高质量短视频,我现在能在2-3小时内搞定。放在一年前,这种质量的视频要么外包(几千块),要么自己拍(准备加拍摄加剪辑至少一周)。

技巧四:商业场景的实战应用

说点实际的,这功能怎么赚钱?

场景1:产品展示视频

客户给你产品图,你生成不同场景的使用视频。收费可以按条数,一条8秒视频500-1000元,一天能做5-10条。

场景2:品牌吉祥物系列内容

用Reference Image保持吉祥物外观一致,生成一整季的系列短视频。这个适合按项目收费,一季10-20集,报价1-3万。

场景3:社交媒体内容矩阵

把客户的平面设计稿、海报、产品图全部转成视频版本。数据显示视频内容的互动率比图片高3-5倍,很多品牌愿意为此付费。

场景4:教育培训视频

把教学插图动画化。比如历史事件、科学原理、产品使用教程。这个市场挺大的,很多教育机构和知识博主有需求。

我身边有个朋友专做这个,主要服务中小品牌。他说自从掌握了图生视频,业务量翻了两倍,因为交付速度快、成本可控,客户满意度还高。

一点小建议:别把这当成纯技术活。客户要的不是”用Veo 3生成视频”,他们要的是”帮我解决营销/传播/内容问题”。你得理解他们的业务需求,给出合适的视觉方案,技术只是实现手段。

成本对比:图生视频 vs 纯文生视频

说到底,用图片引导到底能省多少时间和钱?我给你算笔账。

时间成本对比

纯文生视频:

- 平均尝试次数:10-50次

- 单次等待时间:30-120秒

- 总耗时:5-100分钟纯等待 + 写prompt调参数的时间

- 实际体验:一个下午可能就出1-2个可用视频

图生视频:

- 平均尝试次数:2-5次

- 单次等待时间:30-120秒

- 总耗时:1-10分钟纯等待 + 准备图片的时间

- 实际体验:一个下午能出5-8个可用视频

时间节省:80-90%

特别是对于有明确视觉需求的项目(比如品牌视频、产品展示),图生视频简直是降维打击。

算力成本对比

假设平台按credit或积分收费,每次生成消耗1个单位:

- 纯文生视频:10-50个单位才能出成品

- 图生视频:2-5个单位就能出成品

成本节省:80-90%

如果你用的是按量付费的API,这个差别就是真金白银。一个月下来,省的钱够你多订几个工具了。

质量稳定性对比

这个没法用数字量化,但差别明显:

纯文生视频:

- 结果高度随机,像抽奖

- 无法预测会生成什么

- 适合”天马行空”的创意探索

图生视频:

- 结果稳定可控,有底线

- 能预测大概方向

- 适合有明确要求的商业项目

对于需要正式发布、代表品牌形象的内容,图生视频的风险低得多。客户不会接受”我试了50次但就是生成不出来”这种说法。

创意资产复用价值

这是图生视频的隐藏优势。

你之前花钱请设计师画的插画、拍的产品图、做的3D渲染,现在都能二次利用转成视频。这些素材本来躺在硬盘里吃灰,现在一下子有了新价值。

对于有内容积累的创作者或品牌来说,这相当于把存量资产盘活了。我见过有人把过去三年的博客配图全翻出来,批量转成短视频,内容矩阵一下子扩充了好几倍。

算总账:如果你的工作涉及视频内容制作,掌握图生视频技能能让你的效率提升3-5倍,成本降低80%以上。这不是夸张,是我自己和几十个同行的真实数据。

结论

说了这么多,核心就一句话:图片引导让AI视频从”开盲盒”变成精准控制。

纯文生视频不是不行,它适合那些天马行空、没有明确视觉预期的创意探索。但如果你知道自己要什么样的画面,或者你手头有现成的图片素材,图生视频的效率和质量都会碾压纯文生视频。

三种模式各有用途:

- 首帧模式:把静态图动起来,保持风格

- 首尾帧模式:精准控制镜头运动和过渡效果

- Reference Image:保持人物/产品在系列视频中的一致性

掌握这三种模式,配合正确的prompt技巧和参数设置,你的”抽卡”次数能从50次降到5次以内。

我的建议是:从最简单的首帧模式开始试。找一张你最喜欢的照片或插画,上传到Veo 3(或者Runway、Kling等平台),写个简单的动作描述,看看效果。一次不行就调整prompt或者换张图,2-3次之后你就能找到感觉。

一旦你体验过那种”生成结果符合预期”的爽感,你就回不去纯文生视频了。

最后说一句:这篇文章里的技巧和思路,不只是适用于Veo 3。Runway、Kling、Pika等其他图生视频工具,底层逻辑都是一样的——用图片给AI更明确的指引,减少歧义,提升可控性。所以即使你现在用不了Veo 3,这些方法依然有用。

去试试吧。你的硬盘里肯定有几张不错的图片,现在就让它们动起来。

发布于: 2025年12月7日 · 修改于: 2025年12月15日

评论

使用 GitHub 账号登录后即可评论