Dockerfile优化实战:5个技巧让镜像体积缩小80%

凌晨三点,我盯着终端上的进度条,已经卡在”Pushing to registry”30分钟了。

3.2GB。

我的第一个Node.js应用的Docker镜像,按照网上教程一步步写的Dockerfile,构建倒是成功了,可这体积…完全没想到。更尴尬的是第二天早上,同事在Slack上问我:“你那个镜像是不是把整个操作系统都打包进去了?我笔记本硬盘都快满了。”

说实话,当时我也不知道问题出在哪。Ubuntu基础镜像?node_modules?还是编译工具?反正最后的结果就是:一个简单的API服务,镜像比整个项目代码大了50倍。

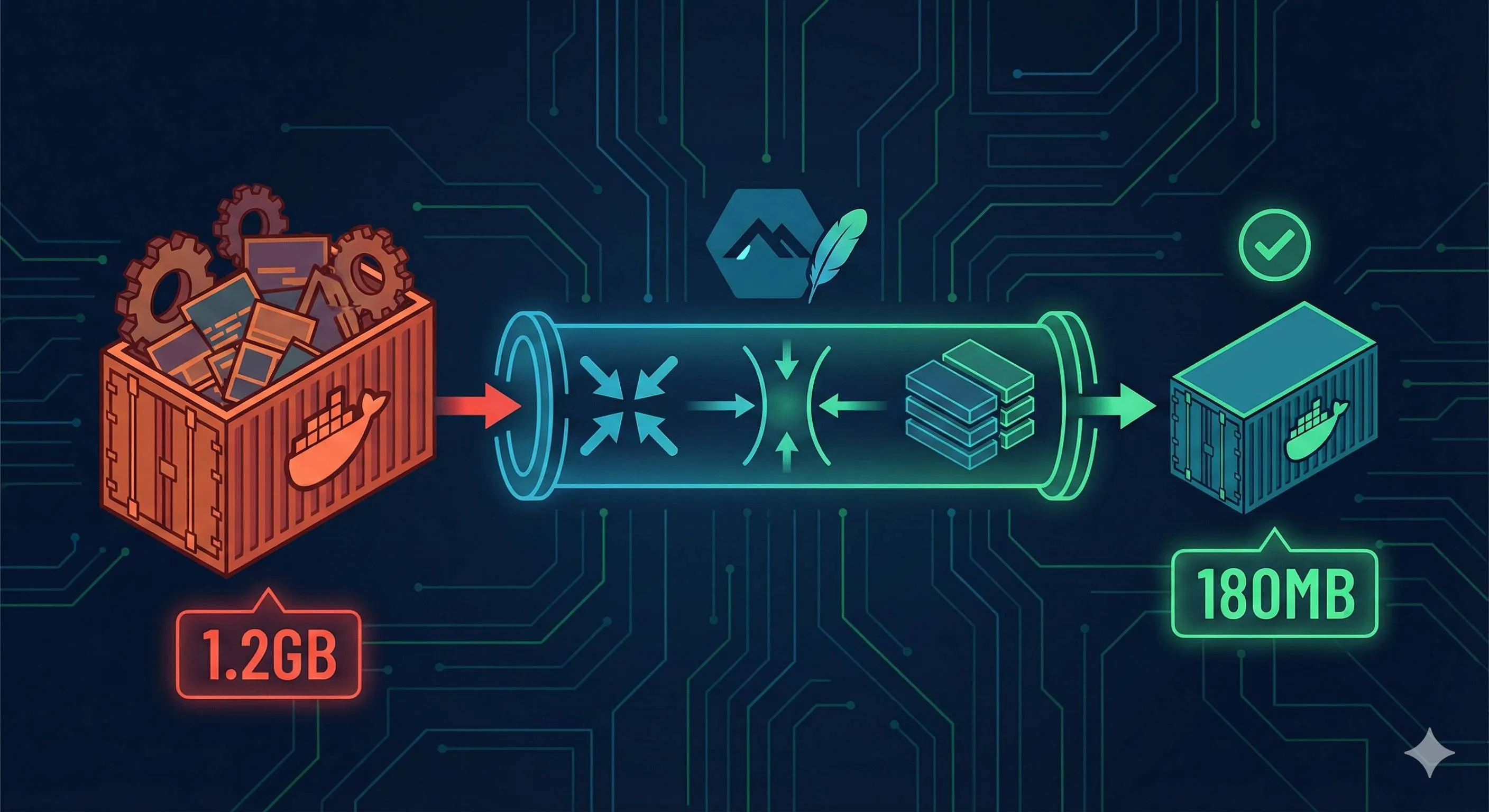

后来花了几天时间研究Docker官方文档、翻遍各种最佳实践,总算把这个3.2GB的怪物降到了180MB。整整减少了94%。

这篇文章就来聊聊这个过程中发现的5个最管用的技巧。不只告诉你怎么做,还会解释为什么这么做有效——毕竟理解原理比死记命令重要得多。

先搞懂Docker镜像为什么这么大

在讲优化技巧之前,得先搞明白问题的根源。

Docker镜像是分层的。每条RUN、COPY、ADD指令都会创建一层新的文件系统。这些层会堆叠起来,最终形成你看到的那个镜像。关键在于:每一层都是只添加不删除的。

举个例子。你在Dockerfile里写了:

RUN apt-get update

RUN apt-get install -y build-essential

RUN rm -rf /var/lib/apt/lists/*表面上看,最后一行删除了apt缓存。但实际上,那个缓存已经被永久保存在第二层里了。第三层只是标记”这些文件被删除了”,但那些数据还躺在镜像里占着空间。

就像搬家时给每次整理房间都拍了照片,即使你最后扔掉了垃圾,那些带垃圾的照片还是要一起带走。有点蠢,但Docker的写时复制机制就是这么工作的。

用docker history看看一个未优化的镜像,你会发现很多层加起来的大小远超过实际需要的文件。

还有个容易忽视的点:基础镜像的选择直接决定了你的体积下限。ubuntu:20.04自己就有72MB,node:16更是直接1.09GB——因为它基于完整的Debian系统,带着各种你可能永远不会用到的系统工具。

明白了这个,优化的思路就清楚了:减少层数,选更轻量的基础镜像,在同一层内完成安装和清理。

技巧一:选对基础镜像,赢在起跑线

基础镜像的选择,就像买房看地段。选错了,后面怎么装修都有上限。

先看几个数字对比:

node:16→ 1.09GBnode:16-slim→ 240MBnode:16-alpine→ 174MBalpine:latest→ 5.6MB

差距一目了然。我当时从node:16换成node:16-alpine,镜像直接从1.2GB降到400MB,啥代码都没改。

Alpine Linux是啥?

它是个为容器环境专门设计的Linux发行版。极简主义路线,只保留最核心的组件。用的是musl libc而不是标准的glibc,包管理器是apk而不是apt。

优势很明显:

- 体积小(5MB vs Ubuntu的72MB)

- 安全(攻击面最小化)

- 启动快

但也有坑。

Alpine的兼容性陷阱

因为用的是musl libc,有些预编译的二进制程序可能跑不起来。我遇到过一次:项目里依赖一个用C++写的Node.js原生模块,在Alpine上直接报错”library not found”。折腾了半天才发现是libc的问题。

所以务实的建议是:

- 优先试试Alpine变体(

-alpine后缀) - 遇到兼容性问题,换

-slim变体(基于Debian但精简了很多包) - 实在不行再用标准镜像,但这种情况其实挺少的

代码改起来超简单:

# 优化前

FROM node:16

# 优化后

FROM node:16-alpine就这一行,省下800MB。

如何验证效果

构建完后跑:

docker images your-image-name看SIZE那一列。要是还是很大,说明问题不只是基础镜像,继续往下看。

技巧二:合并RUN指令,减少镜像层数

这个技巧理解起来简单,但实际用的时候经常被忽略。

前面提到了,每个RUN指令都会创建一层。而且关键是:删除文件只在同一层内有效。

看这个反面教材:

# 错误示范(创建3层)

RUN apt-get update

RUN apt-get install -y python3 gcc

RUN rm -rf /var/lib/apt/lists/*这样写,apt的缓存(通常有几十MB)会被保存在第二层。第三层的删除操作只是标记”这些文件不在了”,但实际数据还在镜像里。

正确的做法是用&&把它们连在一起:

# 正确做法(只创建1层)

RUN apt-get update && \

apt-get install -y python3 gcc && \

rm -rf /var/lib/apt/lists/*这样安装和清理在同一层完成,删除才是真的删除。

反斜杠的作用

注意那个\。它让你可以把长命令拆成多行,方便阅读和维护。不用的话,全挤在一行可太丑了。

怎么判断要不要合并

不是所有RUN都该合并。有个简单的判断标准:

- 要合并:安装+清理、下载+解压+删除压缩包

- 别合并:逻辑上不相关的操作、经常变化的步骤(会破坏构建缓存)

比如:

# 好的分层

RUN apt-get update && apt-get install -y curl && rm -rf /var/lib/apt/lists/*

RUN npm install

RUN npm run build安装系统依赖是一层,npm install是一层(因为package.json经常变),构建是一层。这样改package.json时,前面的系统依赖层可以用缓存,不用重新跑。

实测效果:我有个项目本来12个RUN指令,合并优化后变成4个,镜像从520MB降到320MB。

技巧三:多阶段构建,只带走必需品

多阶段构建(Multi-stage Build)是Docker镜像瘦身最有效的武器。没有之一。

核心思想特别简单:构建和运行分开。

想想看,编译一个Go程序需要整个Go工具链(几百MB),但编译出来的二进制文件可能只有10MB。如果把Go工具链也打包进最终镜像,那就是纯浪费。

多阶段构建就是解决这个问题的。你可以在一个Dockerfile里定义多个阶段:第一阶段用来构建,第二阶段只复制构建产物。

看个Node.js的例子:

# === 构建阶段 ===

FROM node:16-alpine AS builder

WORKDIR /app

# 复制依赖文件

COPY package*.json ./

RUN npm install

# 复制源代码并构建

COPY . .

RUN npm run build

# === 运行阶段 ===

FROM node:16-alpine

WORKDIR /app

# 只复制必需的文件

COPY --from=builder /app/dist ./dist

COPY --from=builder /app/node_modules ./node_modules

COPY package*.json ./

EXPOSE 3000

CMD ["node", "dist/index.js"]关键看那个COPY --from=builder。它从第一阶段(builder)复制文件到第二阶段。最终镜像只包含第二阶段的内容,第一阶段的所有中间产物都被扔掉了。

什么时候该用多阶段构建

几个典型场景:

- 编译型语言:Go、Rust、C++等需要编译器的

- 前端项目:TypeScript编译、Webpack打包

- 需要构建工具:比如Python项目用到gcc编译某些库

我那个Node.js项目就是典型的TypeScript转JavaScript场景。源代码400MB(包括node_modules里的@types),编译后的dist文件夹只有2MB。用多阶段构建,从400MB降到220MB。

一个容易踩的坑

有人会在运行阶段也npm install,想着”反正要装依赖”。别!那样的话,devDependencies(开发依赖)也会被装进去,白白浪费空间。

正确做法是在构建阶段用npm install(包含dev依赖,因为要编译),然后把整个node_modules复制到运行阶段。或者更精确的做法:

# 构建阶段

RUN npm install

# 运行阶段

RUN npm install --production只装生产依赖,体积能再少30-40%。

多阶段构建刚看可能有点绕,但理解之后你会觉得这设计真优雅。就像旅行打包:在家里(构建阶段)把所有东西摊开整理,但上飞机(运行阶段)只带箱子里必需的。

技巧四:用.dockerignore排除无用文件

.dockerignore文件的作用和.gitignore很像,但很多人都忽略它。

当你在Dockerfile里写COPY . .时,Docker会把整个目录发送给Docker daemon作为构建上下文。如果你的项目目录有几百MB的node_modules、.git历史、测试文件、日志,它们都会被发送和复制。

即使最后没用到这些文件,构建过程也会变慢,而且容易不小心把不该进镜像的东西打包进去(比如.env文件里的密钥)。

解决方法:在项目根目录创建.dockerignore文件。

# .dockerignore

node_modules

npm-debug.log

.git

.gitignore

.env

.env.local

README.md

.vscode

.idea

*.md

.DS_Store

coverage/

.pytest_cache/

__pycache__/

*.pyc

dist-local/关键原则

把这些东西加进去:

- 已有的依赖目录:node_modules、vendor、target等(反正构建时会重新安装)

- 开发工具配置:.vscode、.idea、.editorconfig

- Git相关:.git、.gitignore(.git文件夹经常几十MB)

- 文档和说明:README、CHANGELOG、docs/

- 敏感信息:.env、credentials.json、*.pem

我之前有个项目忘了加.git,结果每次构建都要传输.git文件夹里的500MB历史记录。加上.dockerignore后,构建速度从2分钟降到30秒,镜像体积也少了不少。

一个实用技巧

如果不确定哪些文件会被复制,可以先构建一次,然后进入容器看:

docker run --rm -it your-image sh

ls -lah发现有不该在的文件,就把它们加到.dockerignore里。

这个技巧看起来简单,但效果立竿见影。特别是前端项目,dist目录、node_modules、.cache加起来随便就上GB。

技巧五:清理包管理器缓存

各种包管理器(npm、pip、apt、apk)安装软件包后都会留下缓存。这些缓存在本地开发时能加速后续安装,但在Docker镜像里就是纯占地方。

问题是,很多人知道要清理,但清理的方式不对。

必须在同一个RUN指令里清理

再强调一遍这个关键点:清理必须和安装在同一层。

# ❌ 无效的清理

RUN apt-get update

RUN apt-get install -y curl

RUN rm -rf /var/lib/apt/lists/* # 这行白写了

# ✅ 有效的清理

RUN apt-get update && \

apt-get install -y curl && \

rm -rf /var/lib/apt/lists/*不同的包管理器清理方法不同,这里列个清单:

Node.js (npm/yarn)

# npm - 传统方式

RUN npm install && \

npm cache clean --force

# npm - 更简单的方式(禁用缓存)

RUN npm install --no-cache

# yarn

RUN yarn install && \

yarn cache cleanPython (pip)

# 最直接:安装时就不生成缓存

RUN pip install --no-cache-dir -r requirements.txt

# 或者安装后清理

RUN pip install -r requirements.txt && \

rm -rf ~/.cache/pipAlpine (apk)

# Alpine的apk有个超方便的选项

RUN apk add --no-cache package-name

# 或者手动清理

RUN apk add package-name && \

rm -rf /var/cache/apk/*Debian/Ubuntu (apt)

RUN apt-get update && \

apt-get install -y package-name && \

apt-get clean && \

rm -rf /var/lib/apt/lists/*实测数据

我测试了一个Python项目,同样的依赖:

- 不清理缓存:450MB

- 清理缓存:320MB

- 用

--no-cache-dir:310MB(最干净)

差了140MB!就加一个参数的事。

开发环境 vs 生产环境

有个细节:生产环境的镜像应该用--production或--no-dev只装必需的包。开发依赖通常占总体积的30-50%。

# Node.js只装生产依赖

RUN npm install --production

# Python只装必需的包(在requirements.txt里区分)

RUN pip install --no-cache-dir -r requirements-prod.txt这5个技巧组合使用,效果是乘法不是加法。我那个3.2GB的项目最后降到180MB,就是把这些技巧都用上的结果。

完整案例:Node.js应用的优化全过程

说了这么多理论,来看一个真实的优化案例。这是我之前做的一个Express API服务的Dockerfile演变过程。

优化前(1.2GB)

FROM node:16

WORKDIR /app

COPY . .

RUN npm install

RUN npm run build

EXPOSE 3000

CMD ["node", "dist/index.js"]简单粗暴,但镜像巨大。

第一步优化:换Alpine基础镜像(→ 400MB,-67%)

FROM node:16-alpine

WORKDIR /app

COPY . .

RUN npm install

RUN npm run build

EXPOSE 3000

CMD ["node", "dist/index.js"]只改一行,省了800MB。

第二步优化:添加.dockerignore(→ 380MB,-5%)

创建.dockerignore:

node_modules

.git

*.md

.env

coverage虽然看起来省的不多,但构建速度快了很多。

第三步优化:多阶段构建(→ 220MB,-42%)

# 构建阶段

FROM node:16-alpine AS builder

WORKDIR /app

COPY package*.json ./

RUN npm install

COPY . .

RUN npm run build

# 运行阶段

FROM node:16-alpine

WORKDIR /app

COPY --from=builder /app/dist ./dist

COPY --from=builder /app/node_modules ./node_modules

COPY package*.json ./

EXPOSE 3000

CMD ["node", "dist/index.js"]这一步效果最显著,扔掉了所有构建过程的中间文件。

第四步优化:只装生产依赖 + 清理缓存(→ 180MB,-18%)

# 构建阶段

FROM node:16-alpine AS builder

WORKDIR /app

COPY package*.json ./

RUN npm install

COPY . .

RUN npm run build

# 运行阶段

FROM node:16-alpine

WORKDIR /app

COPY package*.json ./

RUN npm install --production --no-cache && \

npm cache clean --force

COPY --from=builder /app/dist ./dist

EXPOSE 3000

CMD ["node", "dist/index.js"]最终版本:180MB,比最初的1.2GB减少了85%。

优化路线图总结

1.2GB (node:16原版)

↓ 换Alpine

400MB (-67%)

↓ .dockerignore

380MB (-5%)

↓ 多阶段构建

220MB (-42%)

↓ 生产依赖+清理

180MB (-18%)

────────────────

总计减少 85%哪些技巧效果最好?

从这个案例能看出:

- Alpine基础镜像:立竿见影,最容易上手

- 多阶段构建:效果最显著,但需要一点学习成本

- 清理和生产依赖:细节优化,积少成多

如果时间有限,优先做前两个。

结论

回顾一下这5个技巧:

- 选Alpine基础镜像 - 从源头减小体积

- 合并RUN指令 - 在同一层完成安装和清理

- 多阶段构建 - 只带走运行时需要的文件

- .dockerignore - 排除无用文件和敏感信息

- 清理包管理器缓存 - 用

--no-cache类参数

这些技巧不是孤立的,组合使用效果最好。我的经验是:Alpine + 多阶段构建能解决80%的体积问题,剩下的20%靠清理和排除优化。

立即行动

别等到遇到问题再优化。找一个现有项目,试试这5个技巧:

- 看看能换成Alpine不(大概率可以)

- 检查Dockerfile有没有分开的安装和清理(有的话合并)

- 加个多阶段构建(编译型项目必做)

- 创建.dockerignore文件

- 给包管理器加上

--no-cache参数

构建完用docker images对比一下,看能省多少。

进阶方向

如果还想深入,可以研究:

- Docker BuildKit的缓存挂载功能

- Distroless镜像(Google出品,比Alpine还小)

- 镜像安全扫描工具(Trivy、Grype)

Dockerfile优化不是一次性的事,是个持续改进的过程。每次构建时看一眼镜像大小,养成这个习惯,体积自然就控制住了。

祝你的镜像越来越轻。

Dockerfile优化完整流程

5个技巧让镜像体积缩小80%,从3.2GB降到180MB,减少94%

⏱️ 预计耗时: 1 小时

- 1

步骤1: 技巧1:使用Alpine基础镜像

Alpine基础镜像优势:

• 体积小(只有5MB,Ubuntu有200MB)

• 安全性高(最小化攻击面)

• 包管理器简单(apk)

• 适合生产环境

使用Alpine:

• 将FROM ubuntu:20.04改为FROM alpine:latest

• 使用apk替代apt-get安装包:apk add --no-cache nodejs npm

• 镜像体积从200MB降到5MB,减少95% - 2

步骤2: 技巧2-3:合并RUN指令和多阶段构建

合并RUN指令:

• 将多个RUN指令合并成一个,减少镜像层数

• 使用&&连接命令,使用\换行提高可读性

• 最后清理缓存:

RUN apt-get update && \

apt-get install -y nodejs npm && \

apt-get clean && \

rm -rf /var/lib/apt/lists/*

多阶段构建:

• 第一阶段使用完整构建镜像编译

• 第二阶段使用最小运行镜像运行

• 只保留运行时需要的文件,编译工具不打包

• 镜像体积大幅减少 - 3

步骤3: 技巧4-5:配置.dockerignore和清理缓存

配置.dockerignore:

• 排除node_modules、.git、.env、dist等不需要的文件

• 减少构建上下文大小,加快构建速度

清理缓存:

• 使用--no-cache参数:apk add --no-cache

• 清理apt缓存:apt-get clean && rm -rf /var/lib/apt/lists/*

• 清理npm缓存:npm cache clean --force

• 减少镜像体积

常见问题

Dockerfile优化的5个技巧是什么?

1) 使用Alpine基础镜像(从Ubuntu 200MB降到Alpine 5MB,减少95%)

2) 合并RUN指令(减少镜像层数,降低镜像体积)

3) 多阶段构建(只保留运行时需要的文件,编译工具不打包)

4) 配置.dockerignore(排除node_modules、.git等不需要的文件)

5) 清理缓存(apt-get clean、npm cache clean等)

优化效果:

• Node.js应用镜像从3.2GB降到180MB(减少94%)

• 从1.2GB降到180MB(减少85%)

• 部署时间从30分钟缩短到几分钟

• 镜像体积大幅减少

为什么Alpine基础镜像更好?

• 体积小(只有5MB,Ubuntu有200MB)

• 安全性高(最小化攻击面)

• 包管理器简单(apk)

• 适合生产环境

使用Alpine:

• 将FROM ubuntu:20.04改为FROM alpine:latest

• 使用apk替代apt-get安装包:apk add --no-cache nodejs npm

• 镜像体积从200MB降到5MB,减少95%

如何合并RUN指令?

• 将多个RUN指令合并成一个,减少镜像层数

• 使用&&连接命令

• 使用\换行提高可读性

• 最后清理缓存:

RUN apt-get update && \

apt-get install -y nodejs npm && \

apt-get clean && \

rm -rf /var/lib/apt/lists/*

这样可以减少镜像层数,降低镜像体积,提高构建效率。

Dockerfile优化的最佳实践是什么?

• 使用Alpine基础镜像

• 合并RUN指令

• 使用多阶段构建

• 配置.dockerignore

• 清理缓存

• 定期更新基础镜像版本

这些技巧不是孤立的,组合使用效果最好。我的经验是:Alpine + 多阶段构建能解决80%的体积问题,剩下的20%靠清理和排除优化。

Dockerfile优化不是一次性的事,是个持续改进的过程,每次构建时看一眼镜像大小,养成这个习惯,体积自然就控制住了。

12 分钟阅读 · 发布于: 2025年12月17日 · 修改于: 2026年2月5日

评论

使用 GitHub 账号登录后即可评论